Redis基础

黑马程序员 Redis 入门到实战教程,全面透析 redis 底层原理+redis分布式锁+企业解决方案+redis实战_哔哩哔哩_bilibili

Redis 介绍:诞生于 2009 年,全称是 Remote Dictionary Server,远程字典服务器,是一个基于内存的键值型 NoSQL 数据库。

特点

| - | SQL | NoSQL |

|---|---|---|

| 数据结构 | 结构化(Structured) | 非结构化 |

| 数据关联 | 关联的(Relational) | 无关联的 |

| 查询方式 | SQL 查询 | 非 SQL |

| 事务特性 | ACID | BASE |

| 存储方式 | 磁盘 | 内存 |

| 扩展性 | 垂直 | 水平 |

| 使用场景 | 1) 数据结构固定 2) 相关业务对数据安全性、一致性要求较高 |

1) 数据结构不固定 2) 对一致性、安全性要求不高 3) 对性能要求高 |

NoSQL 的类型有如下几种

- 键值类型(Redis)

- 文档类型(MongoBD)

- 列类型(HBase)

- Graph 类型(Neo4j)

Redis 的特点

- key-value 类型,value 支持多种不同的数据结构,功能丰富。

- 单线程,每个命令具备原子性(类似 6.0 的多线程仅仅是在请求处理这块,核心的命令执行仍是当线程的)

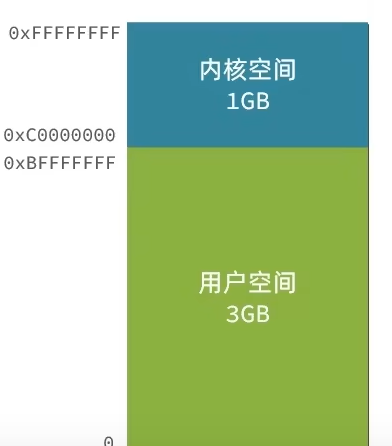

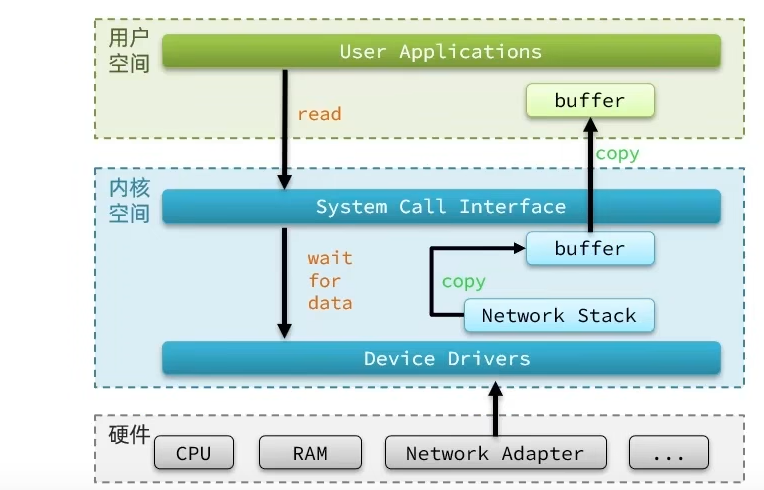

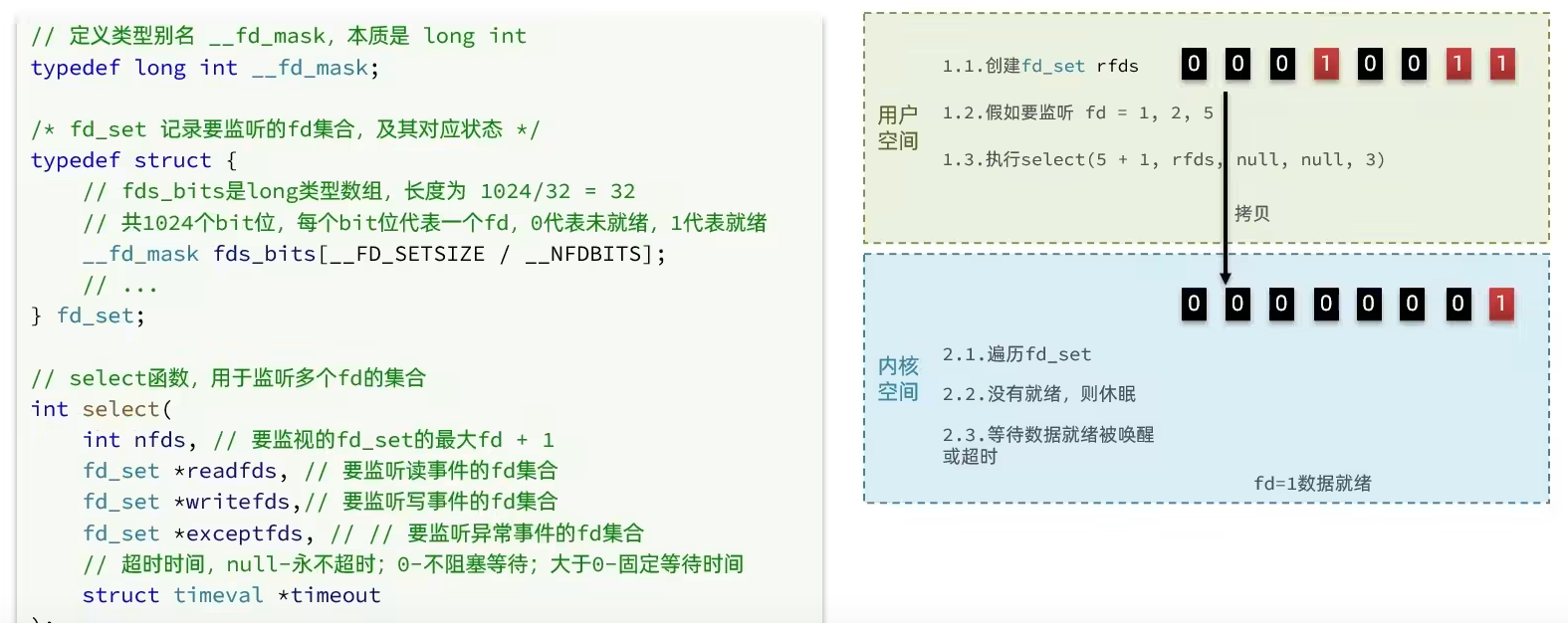

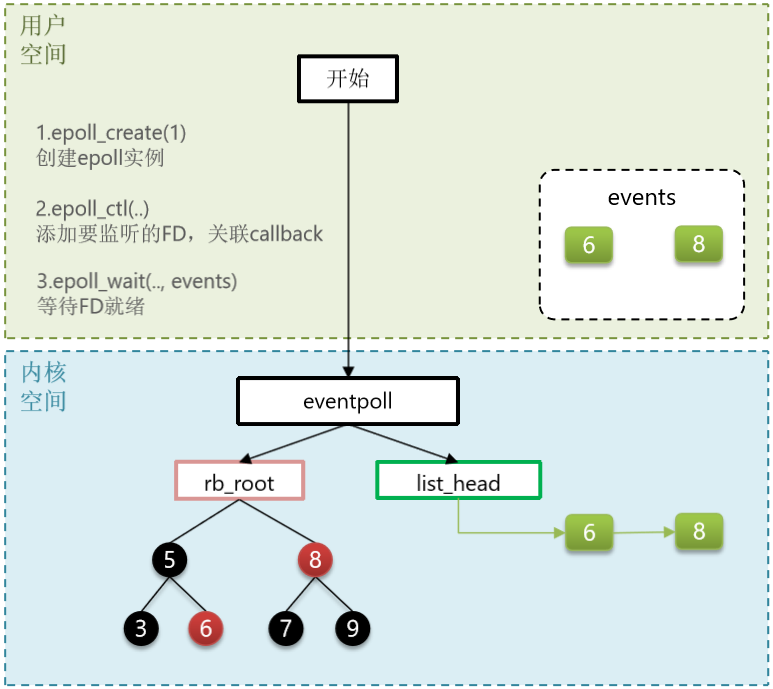

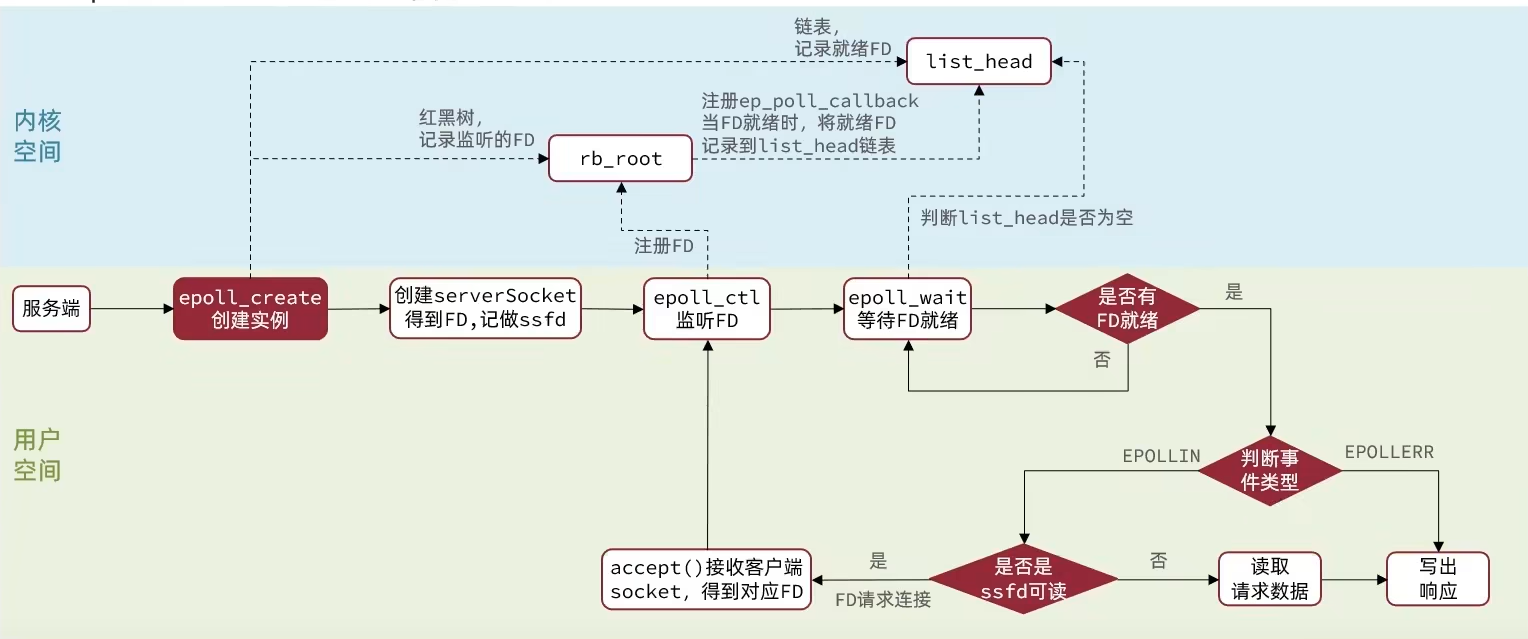

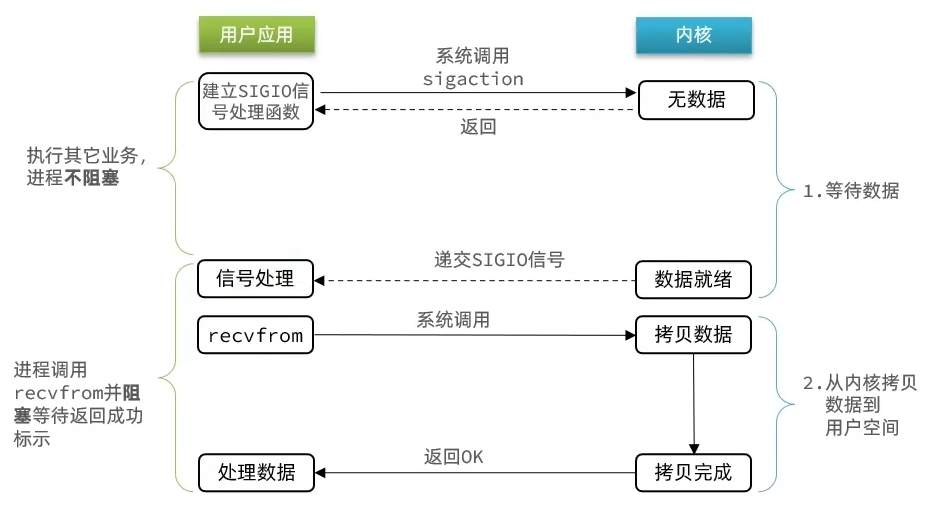

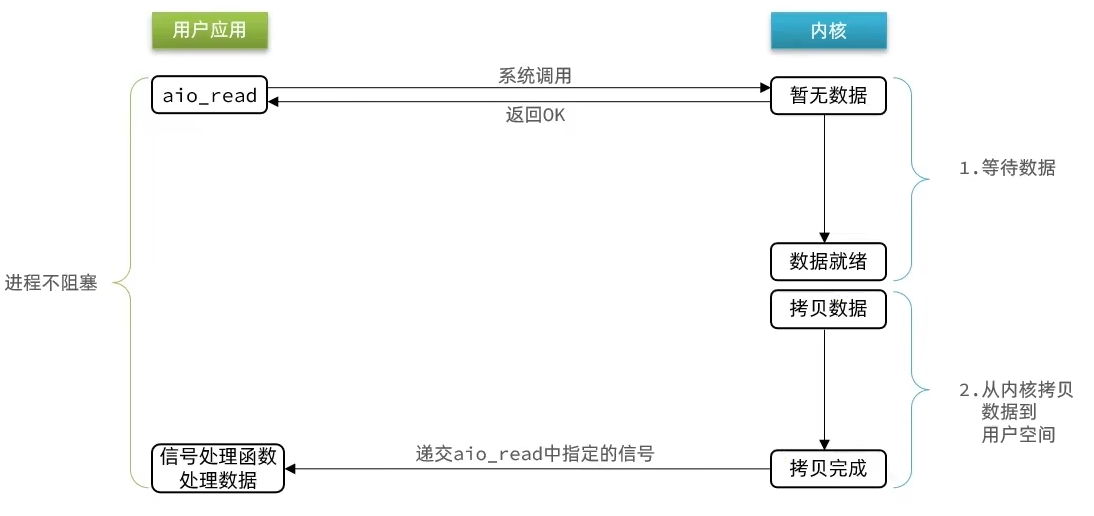

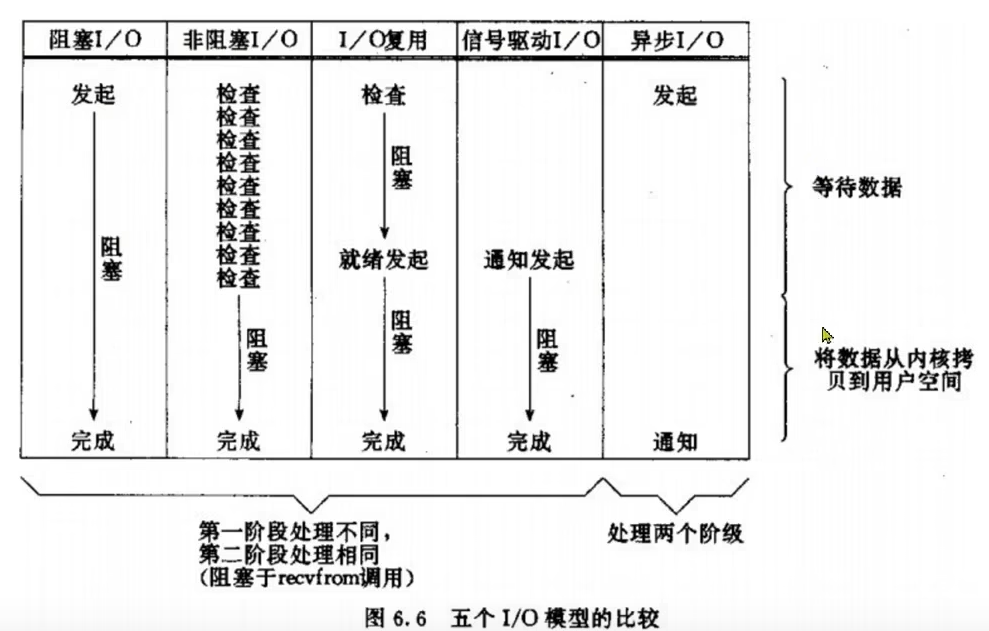

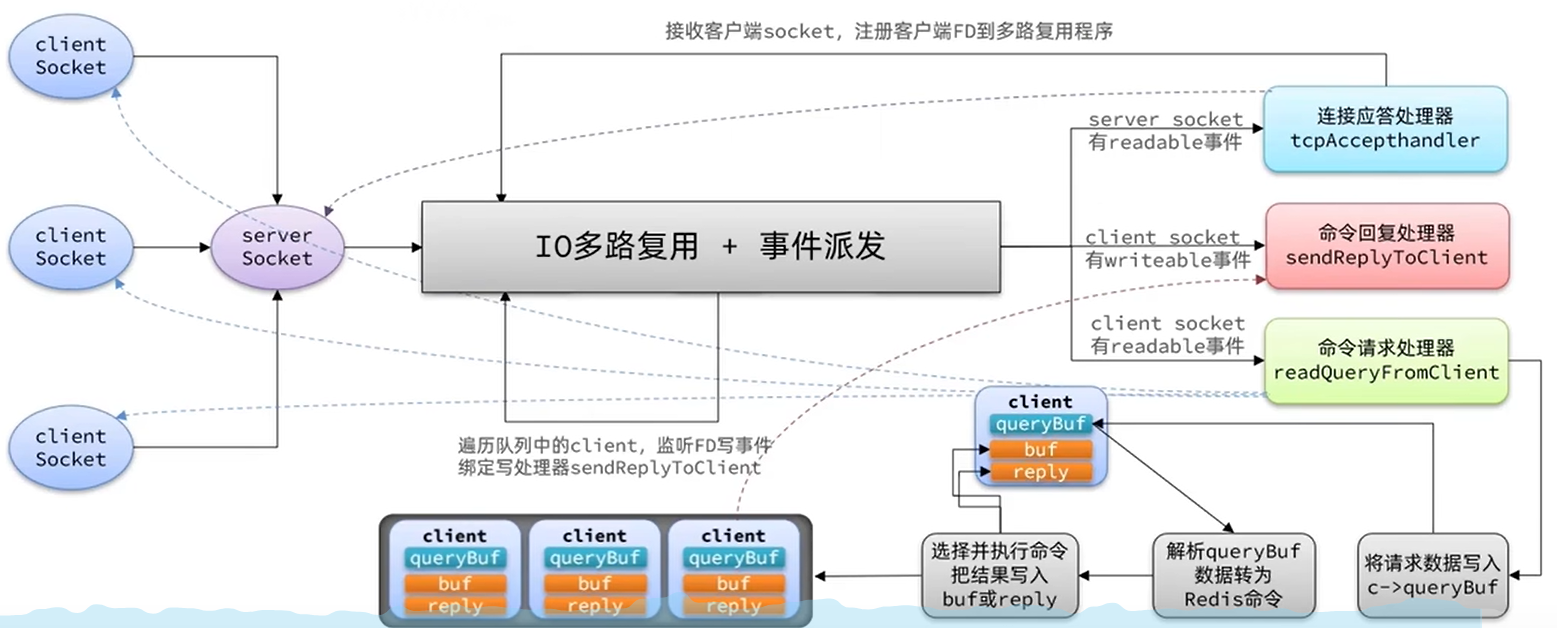

- 低延迟,速度快(基于内存、IO 多路复用、良好的编码)

- 支持数据持久化

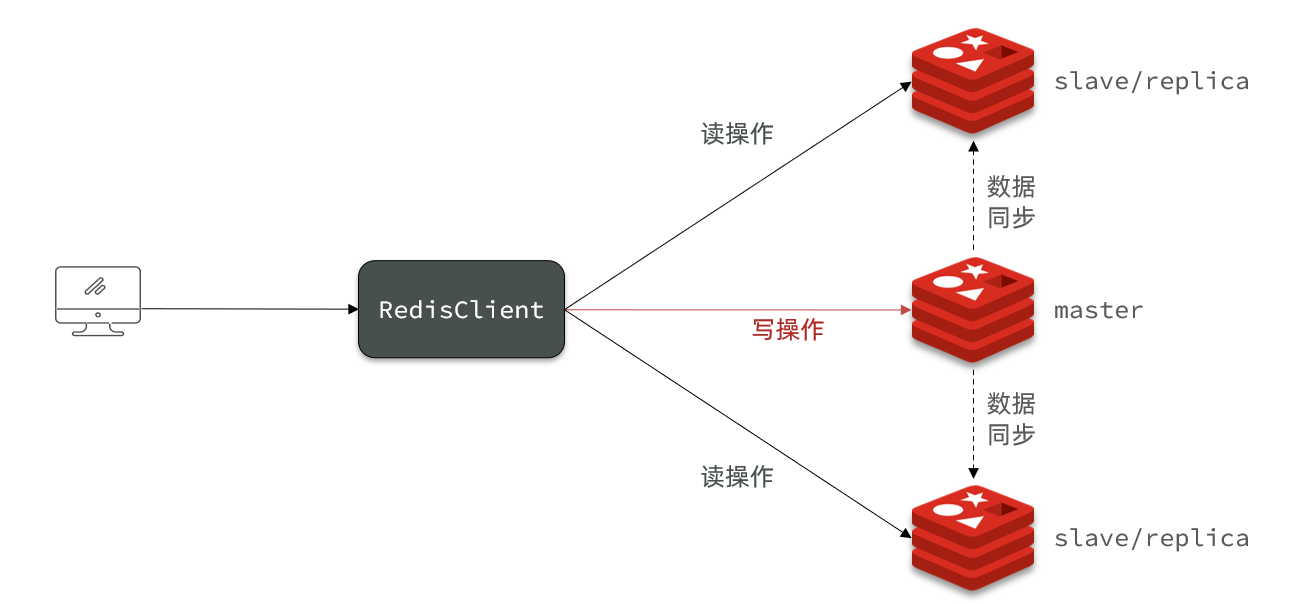

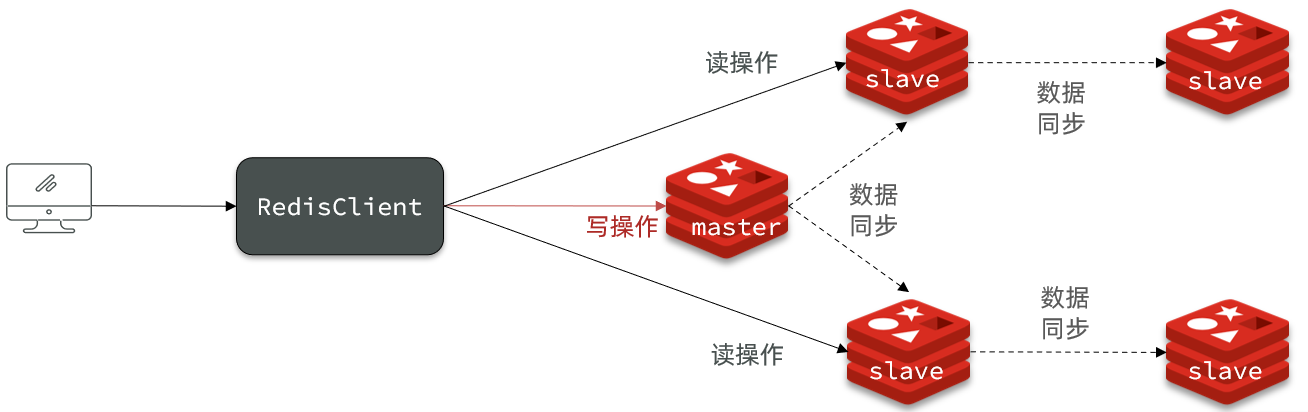

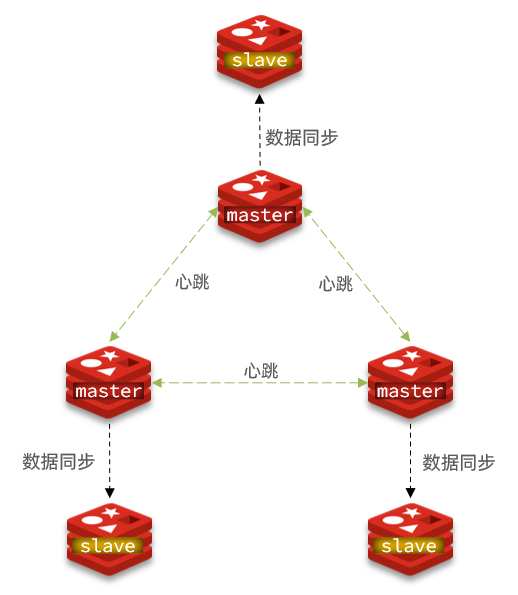

- 支持主从集群、分片集群

- 主从集群:从节点可以去备份主节点

- 分片集群:进行数据拆分,比如把 1T 的数据切分成多分存储在不同的服务器上

- 支持多语言客户端

键值存储数据库

- 相关产品:Tokyo Cabinet/Tyrant、Redis、Voldemort、Berkeley DB

- 典型应用:内容缓存,主要用于处理大量数据的高访问负载。

- 数据模型:一系列键值对

- 优势:快速查询

- 劣势:存储的数据缺少结构化

列存储数据库

- 相关产品:Cassandra, HBase, Riak

- 典型应用:分布式的文件系统

- 数据模型:以列簇式存储,将同一列数据存在一起

- 优势:查找速度快,可扩展性强,更容易进行分布式扩展

- 劣势:功能相对局限

文档型数据库

- 相关产品:CouchDB、MongoDB

- 典型应用:Web 应用(与 Key-Value 类似,Value 是结构化的)

- 数据模型:一系列键值对

- 优势:数据结构要求不严格

- 劣势:查询性能不高,而且缺乏统一的查询语法

图形(Graph)数据库

- 相关数据库:Neo4J、InfoGrid、Infinite Graph

- 典型应用:社交网络

- 数据模型:图结构

- 优势:利用图结构相关算法。

- 劣势:需要对整个图做计算才能得出结果,不容易做分布式的集群方案。

安装

windows

- 官网:https://redis.io

- 中文网:http://www.redis.net.cn/

- 解压直接可以使用: redis.windows.conf:配置文件 redis-cli.exe:redis 的客户端 redis-server.exe:redis 服务器端

docker

在 docker 中安装 redis。

docker 中进入后台运行的 redis:docker exec -it ae7c /bin/bash。然后再输入 redis-cli 启动交互模式。

# 拉取 redis 镜像

docker pull redis

# 运行 redis 容器

docker run --name myredis -d -p6379:6379 redis

# 执行容器中的 redis-cli 可以直接命令行操作 redis

docker exec -it myredis redis-cli

docker 启动 redis 并配置 redis.conf,配置数据存储目录

sudo docker run -p 6379:6379 # 端口映射

--name redis # 设置容器名

-v /home/payphone/software/redis-6/redis.conf:/etc/redis/redis.conf # 配置文件路径映射

-v /home/payphone/software/redis-6:/data # 数据存储路径映射

-d redis

redis-server /etc/redis/redis.conf # 启动 redis-server 配置规则按 redis.conf 设置

--appendonly yes # 开启 appendonly

# 无注释版本

sudo docker run -p 6379:6379 --name redis -v /home/payphone/software/redis-6/redis.conf:/etc/redis/redis.conf -v /home/payphone/software/redis-6:/data -d redis redis-server /etc/redis/redis.conf --appendonly yes

docker 启动的 redis 可能连接不上,需要把 redis.conf 中的 bind 127.0.0.1 注释掉,再把 87 行的 protected-mode yes 改成 no。

# bind 127.0.0.1

protected-mode no

WSL

也可以直接在 windows 的 wsl 子系统中安装 redis,也很方便。

apt-get install redis

# 运行客户端

redis-cli

源码编译

- 下载 redis 源码

- 编译(记得安装 gcc 和 tcl)

- tar xzf redis-xx.tar.gz

- cd redis-xx

- sudo make

- sudo make test

- sudo make install

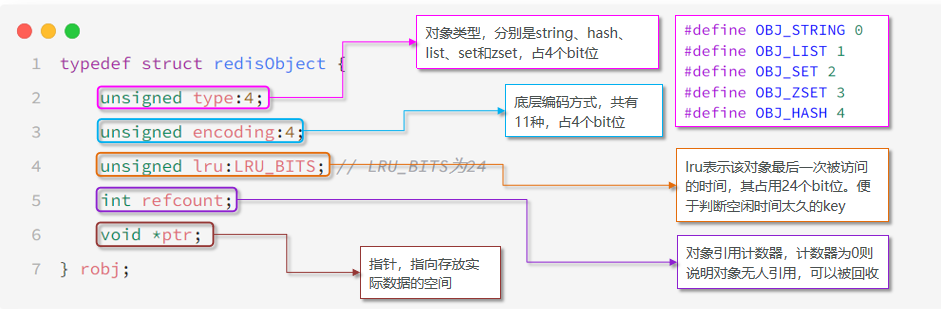

数据结构

Redis 是一个 key-value 的数据库,key 一般是 String 类型,不过 value 的类型多种多样。

五大基本类型

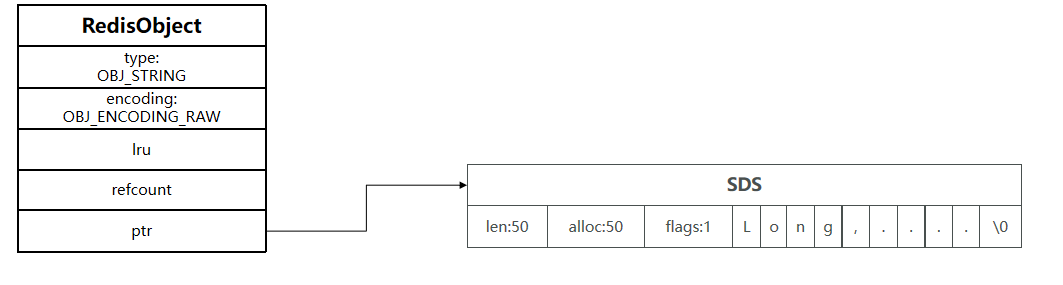

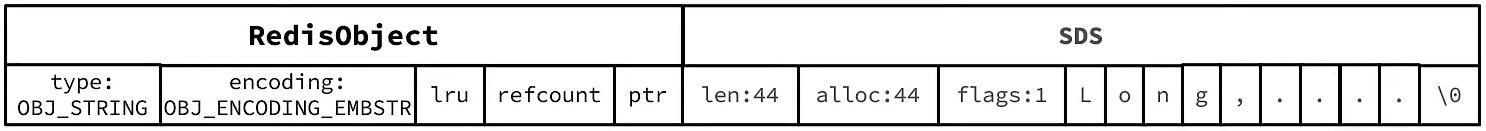

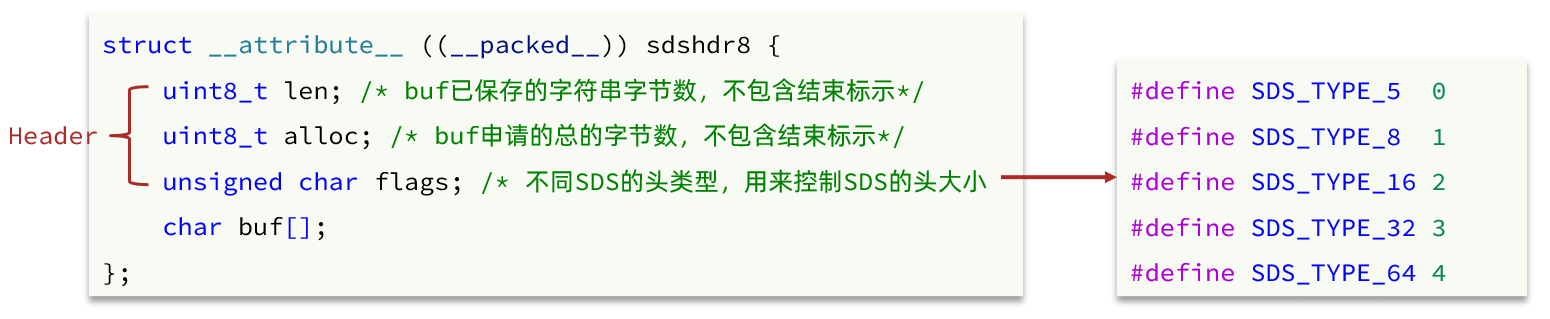

- String 类型 ==> “hello”,用字符数组实现的,不过有两种存储方式,长度短时用 embstr 存储,长度超过 44 字节时用 raw 形式存储。

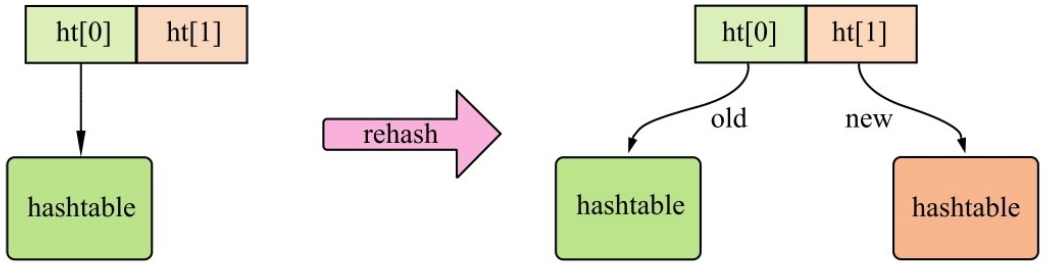

- Hash 类型 ==> {name: “Jack”, age: 21},相当于 Java 中的 HashMap,不过扩容时用的 rehash 策略。

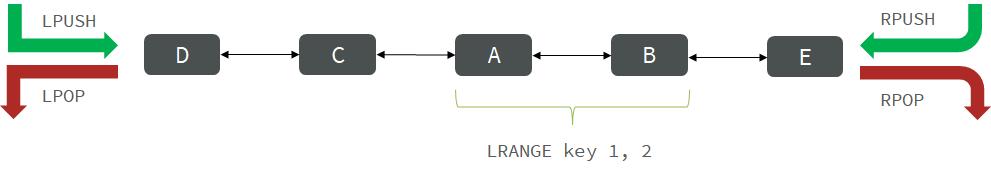

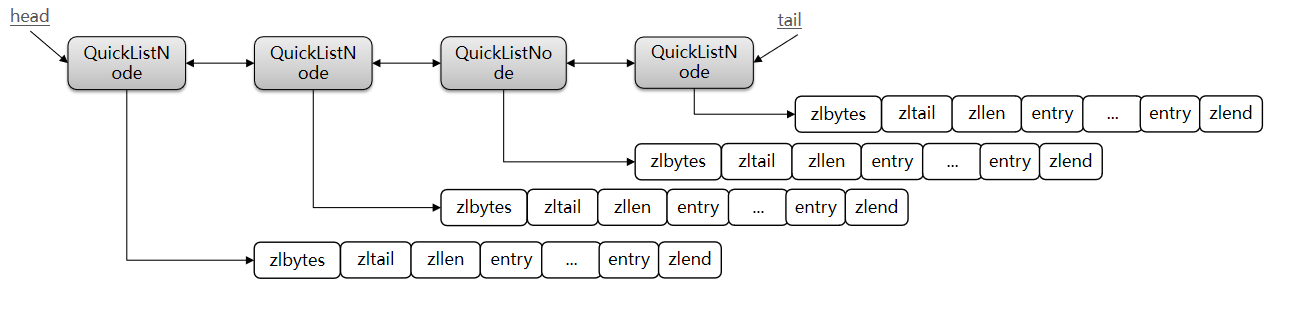

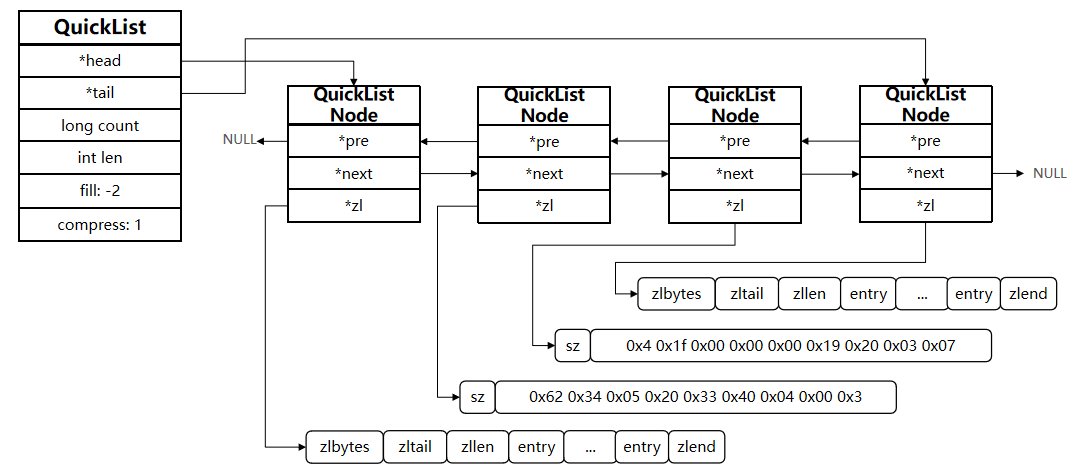

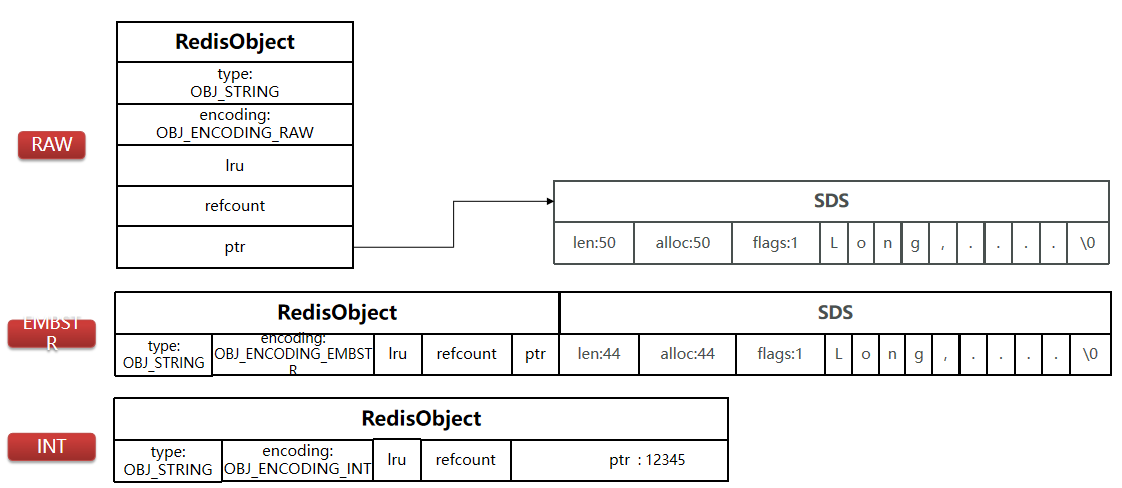

- List 类型 ==> [A -> B -> C -> C],也有两种实现方式,列表元素较少的情况下,会使用一块连续的内存存储,这个结构是 ziplist。如果元素较多,就将多个 ziplist 使用双指针穿起来,Redis 中称这种存储结构为 quicklist。

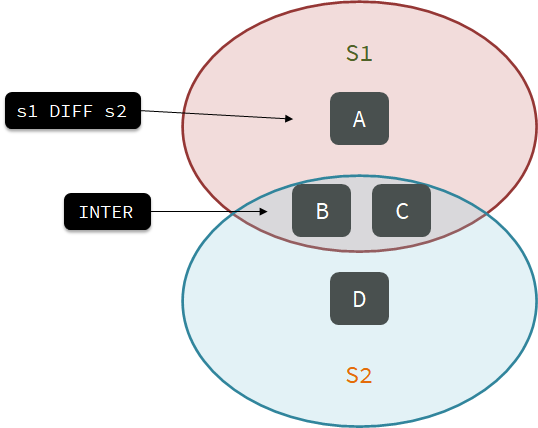

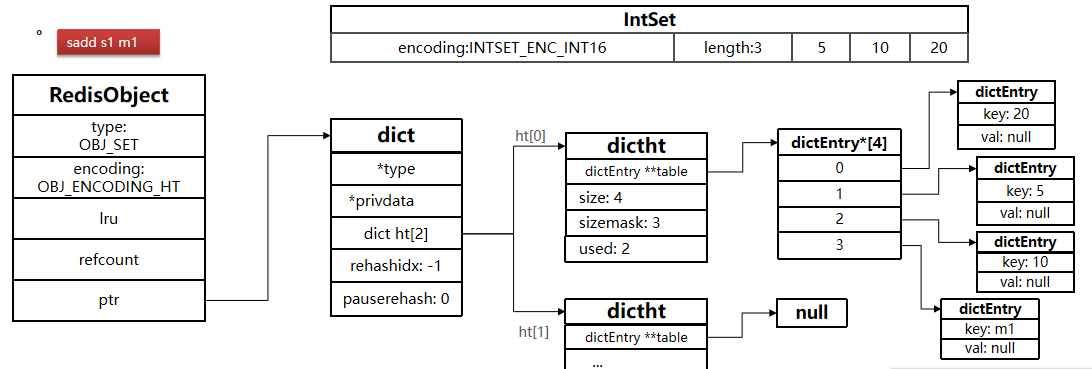

- Set 类型 ==> {A, B, C},相当于 Java 中的 HashSet,无序。

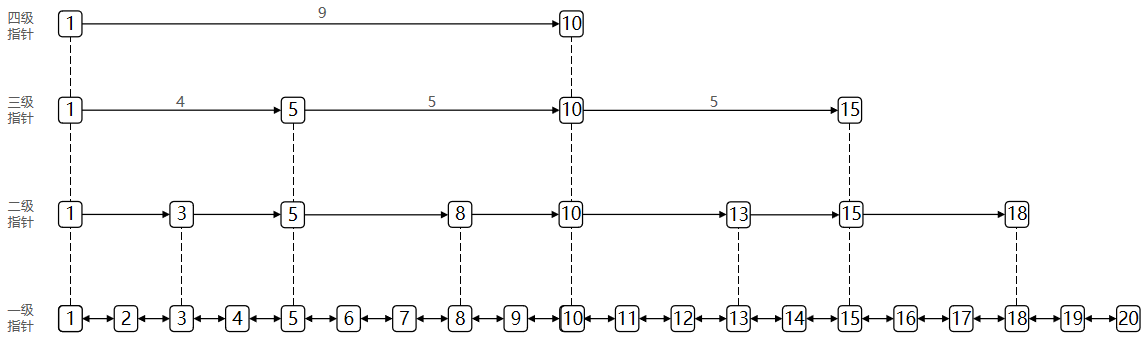

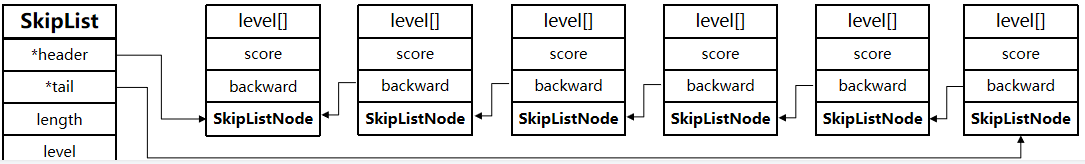

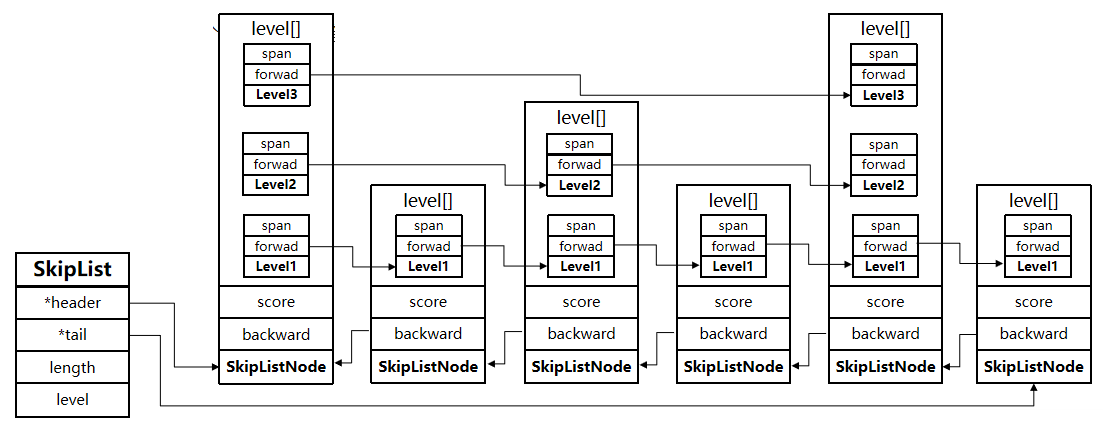

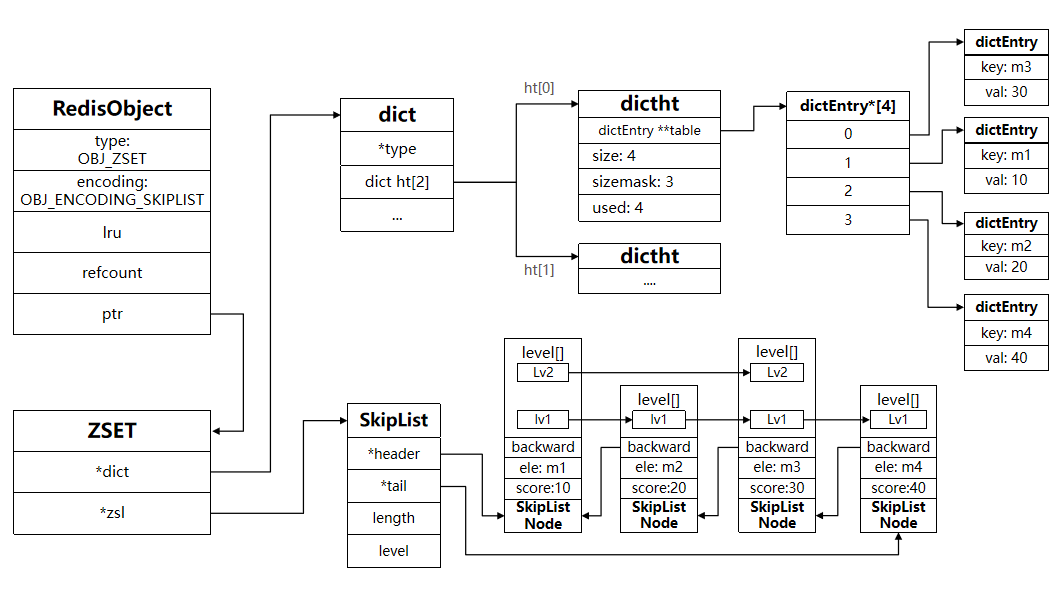

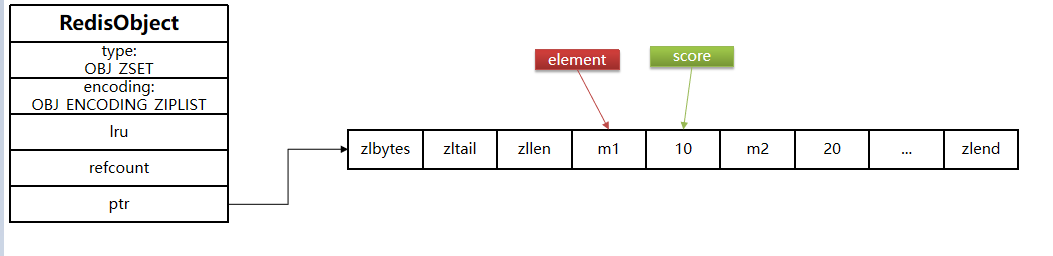

- SortedSet 类型 ==> {A: 1, B: 2, C: 3},用 zset 数据结构实现的,而 zset 类似于 Java 中的 SkipMap,元素唯一且有序,而有序是通过 skiplist 实现的。

特殊类型

- GEO ==> {A:(120.3, 30.5)}

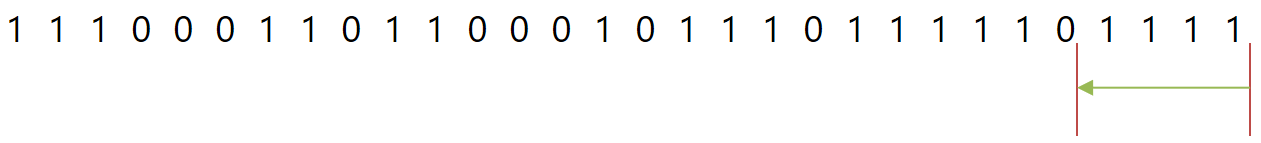

- BitMap ==> 0110110101110101011

- HyperLog ==> 0110110101110101011

命令

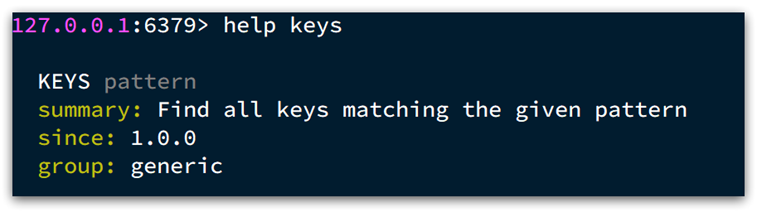

Redis 的命令可以在官网查询到,也可以通过在 Redis 客户端输入 help @命令类型 如 help @generic 查询通用命令的使用方式。

通用命令

通用指令是部分数据类型的,都可以使用的指令,常见的有:

-

KEYS:查看符合模板的所有 key,不建议在生产环境设备上使用

-

DEL:删除一个指定的 key

- EXISTS:判断 key 是否存在

- EXPIRE:给一个 key 设置有效期,有效期到期时该 key 会被自动删除,不设置时间的话默认是永久有效

- TTL:查看一个 KEY 的剩余有效期(它怎么统计有效期的呢?1、可能是有个定时器,定时轮询,发现有 key 过期了就主动剔除;2、可能是访问 key 时会对比 key 的时间是否过期,过期了就剔除 key)

通过 help [command] 可以查看一个命令的具体用法,例如:

String类型

String 类型,也就是字符串类型,是 Redis 中最简单的存储类型。其 value 是字符串,不过根据字符串的格式不同,又可以分为 3 类:

- string:普通字符串

- int:整数类型,可以做自增、自减操作

- float:浮点类型,可以做自增、自减操作

不管是哪种格式,底层都是字节数组形式存储,只不过是编码方式不同。

| key | value |

|---|---|

| msg | hello world |

| num | 10 |

| score | 92.6 |

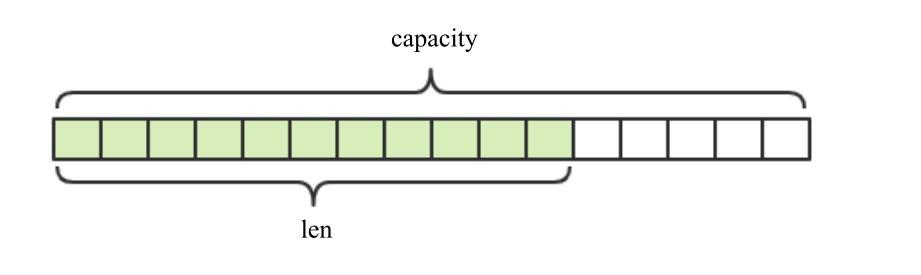

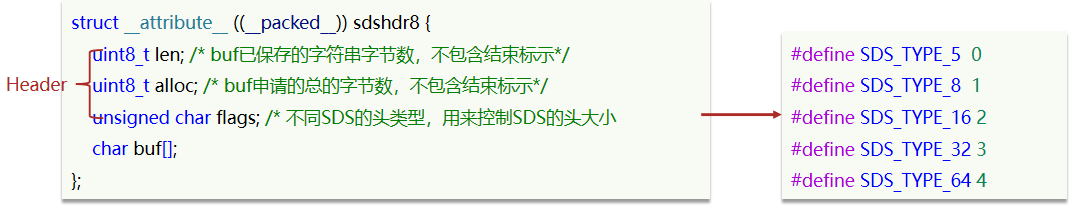

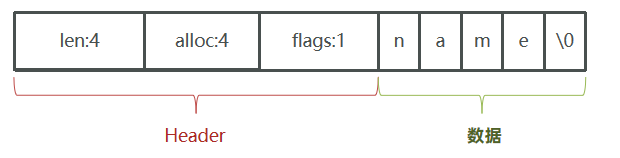

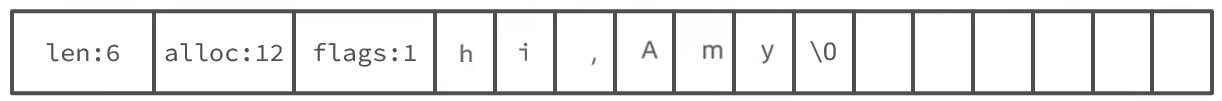

Redis 的 String 类型是动态字符串,是可以修改的字符串,采用预分配冗余空间的方式来减少内存的频繁分配。

具体来说 String 类型内部为当前字符串分配的实际空间 capacity 一般要高于实际字符串长度 len。当字符串长度小于 1MB 时,扩容都是加倍现有的空间。如果字符串长度超过 1MB,扩容时一次只会多扩 1MB 的空间。字符串最大长度为 512MB。

| String 常见命令 | 说明 |

|---|---|

| SET | 添加或者修改已经存在的一个 String 类型的键值对 |

| GET | 根据 key 获取 String 类型的 value |

| MSET | 批量添加多个 String 类型的键值对,M 开头的都是批量操作 |

| MGET | 根据多个 key 获取多个 String 类型的 value |

| INCR | 让一个整型的 key 自增 1 |

| INCRBY | 让一个整型的 key 自增并指定步长,例如:incrby num 2 让 num 值自增 2 |

| INCRBYFLOAT | 让一个浮点类型的数字自增并指定步长 |

| SETNX | 添加一个 String 类型的键值对,前提是这个 key 不存在,否则不执行 (返回 0 表示存在了,未添加成功) |

| SETEX | 添加一个 String 类型的键值对,并且指定有效期 |

# 存储:set key value

# set key value

127.0.0.1:6379> set username zhangsan

OK

# 获取

# get key

127.0.0.1:6379> get username

"zhangsan"

# 删除

# del key

127.0.0.1:6379> del age

(integer) 1

# 查看是否存在

127.0.0.1:6379> exists username

存储结构

用字符数组实现的,不过有两种存储方式,长度短时用 embstr 存储,长度超过 44 字节时用 raw 形式存储。具体的存储结构形式看原理部分。

Hash类型

Hash 类型,也叫散列,其 value 是一个无序字典,类似于 Java 中的 HashMap 结构。

String 结构是将对象序列化为 JSON 字符串后存储,当需要修改对象某个字段时很不方便,而 Hash 结构可以将对象中的每个字段独立存储,可以针对单个字段做 CRUD。

| Hash 的常见命令 | 说明 |

|---|---|

| HSET key field value | 添加或者修改 hash 类型 key 的 field 的值 |

| HGET key field | 获取一个 hash 类型 key 的 field 的值 |

| HMSET | 批量添加多个 hash 类型 key 的 field 的值 |

| HMGET | 批量获取多个 hash 类型 key 的 field 的值 |

| HGETALL | 获取一个 hash 类型的 key 中的所有的 field 和 value |

| HKEYS | 获取一个 hash 类型的 key 中的所有的 field |

| HVALS | 获取一个 hash 类型的 key 中的所有的 value |

| HINCRBY | 让一个 hash 类型 key 的字段值自增并指定步长 |

| HSETNX | 添加一个 hash 类型的 key 的 field 值,前提是这个 field 不存在,否则不执行 |

# hset key field value

127.0.0.1:6379> hset myhash username lisi

(integer) 1

127.0.0.1:6379> hset myhash password 123

(integer) 1

# hget key field: 获取指定的field对应的值

127.0.0.1:6379> hget myhash username

"lisi"

# hgetall key:获取所有的field和value

127.0.0.1:6379> hgetall myhash

1) "username"

2) "lisi"

3) "password"

4) "123"

127.0.0.1:6379> hget myhash username

"lisi"

# hdel key field

127.0.0.1:6379> hdel myhash username

(integer) 1

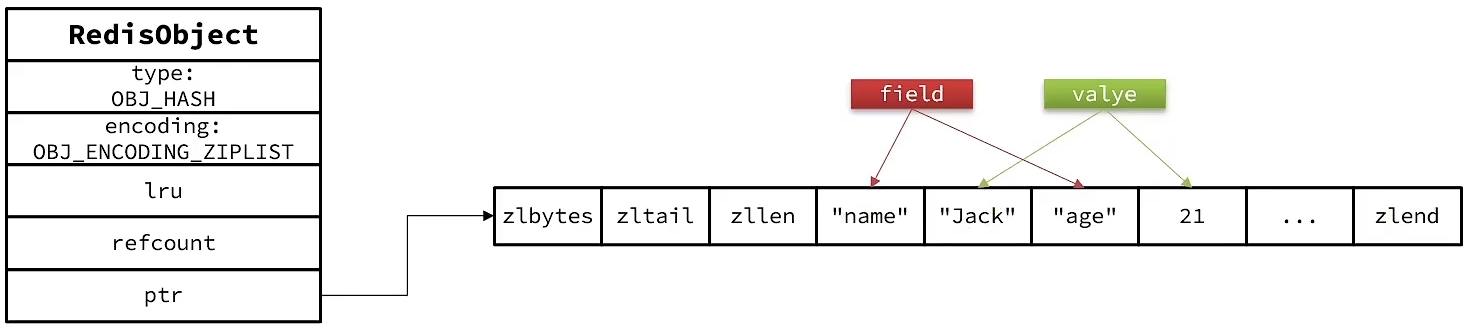

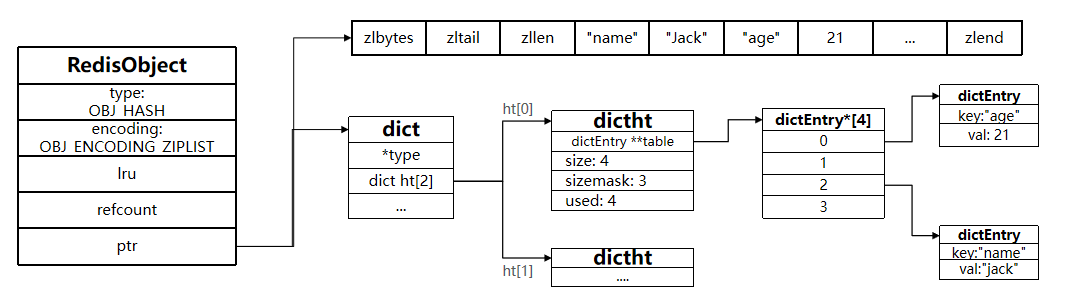

存储结构

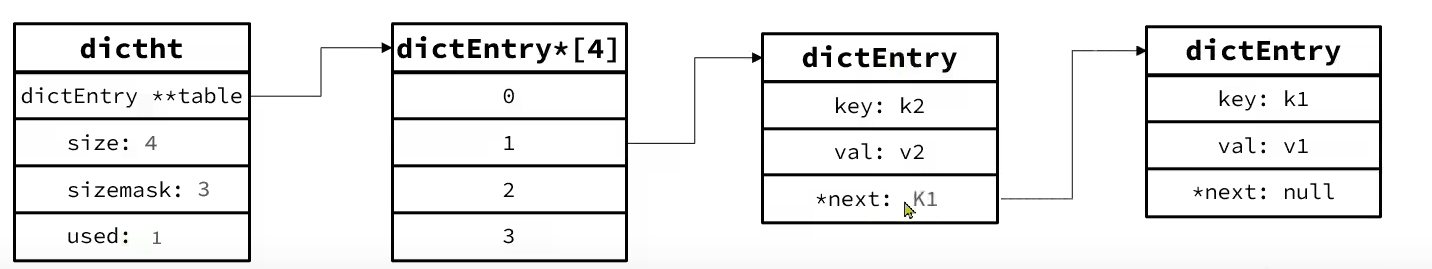

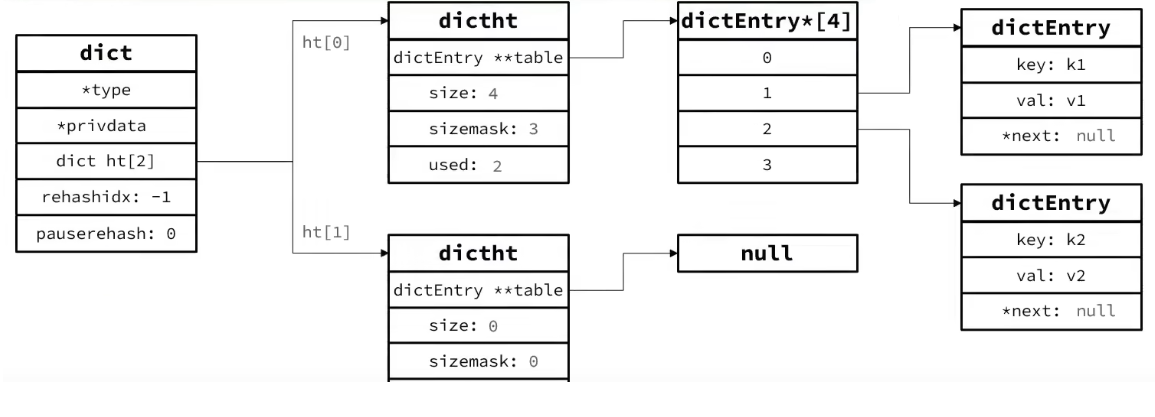

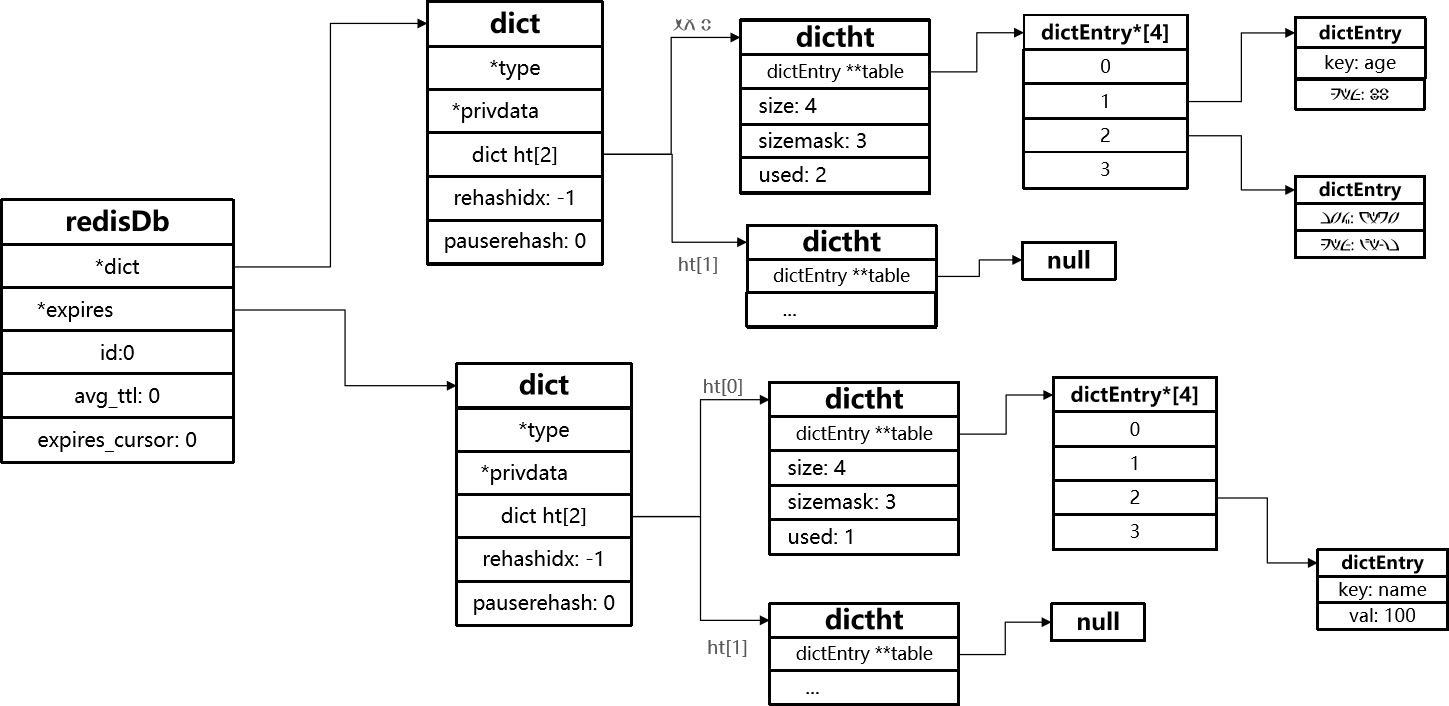

Hash 类型采用的数组+链表的形式存储的。但是 Redis 的字典的值只能是字符串。

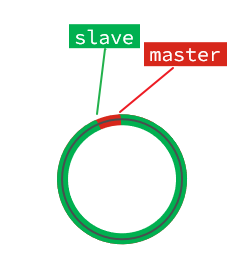

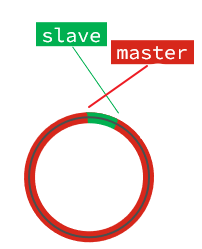

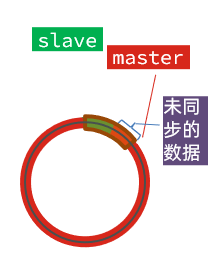

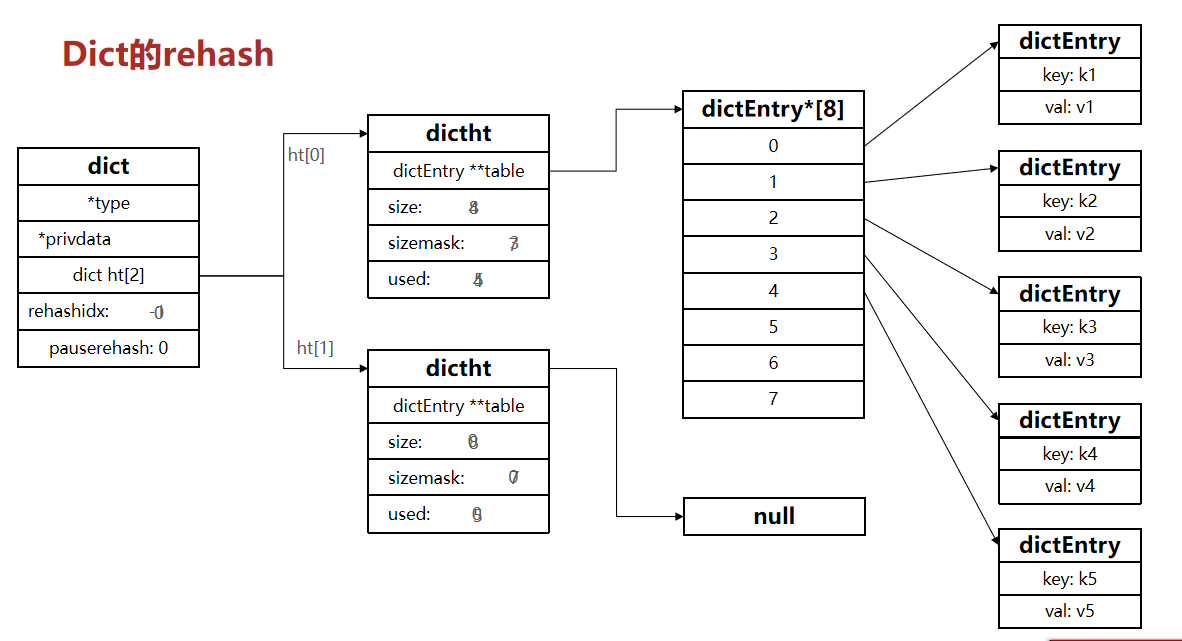

Java 的 Hash Map 在字典很大时,rehash 是个耗时的操作,需要一次性全部 rehash。Redis 为了追求高性能,不能堵塞服务,所以采用了渐进式 rehash 策略。渐进式 rehash 会在 rehash 的同时,保留新旧两个 hash 结构,查询时会同时查询两个 hash 结构,然后在后续的定时任务以及hash操作指令中,循序渐进地将旧 hash 的内容一点点地迁移到新的 hash 结构中。当搬迁完成了,就会使用新的 hash 结构取而代之。

当 hash 移除了最后一个元素之后,该数据结构被自动删除,内存被回收。

hash 可以对用户结构中的每个字段单独存储。这样当我们需要获取用户信息时可以进行部分获取。但是 hash 结构的存储消耗要高于单个字符串。

List类型

Redis 中的 List 类型与 Java 中的 LinkedList 类似,可以看做是一个双向链表结构。既可以支持正向检索和也可以支持反向检索。

特征也与 LinkedList 类似

- 有序

- 元素可以重复

- 插入和删除快

- 查询速度一般

常用来存储一个有序数据,例如:朋友圈点赞列表,评论列表等。

| List 的常见命令 | 说明 |

|---|---|

| LPUSH key element … | 向列表左侧插入一个或多个元素 |

| LPOP key | 移除并返回列表左侧的第一个元素,没有则返回 nil |

| RPUSH key element … | 向列表右侧插入一个或多个元素 |

| RPOP key | 移除并返回列表右侧的第一个元素 |

| LRANGE key star end | 返回一段角标范围内的所有元素 |

| BLPOP 和 BRPOP | 与 LPOP 和 RPOP 类似,只不过在没有元素时会等待指定的时间,而不是直接返回 nil。 有点类似于阻塞队列。Timeout 时间是以秒为单位 |

| LTRIM key star end | 保留区间内的值,区间之外的则统统删除。 |

可以用 List 结构模拟 stack、queue 和 BlockingQueue。

# lpush key value: 将元素加入列表左表 把value加入名为key的链表中

# rpush key value:将元素加入列表右边

127.0.0.1:6379> lpush myList a

(integer) 1

127.0.0.1:6379> lpush myList b

(integer) 2

127.0.0.1:6379> rpush myList c

(integer) 3

# lrange key start end :范围获取

127.0.0.1:6379> lrange myList 0 -1

1) "b"

2) "a"

3) "c"

存储结构

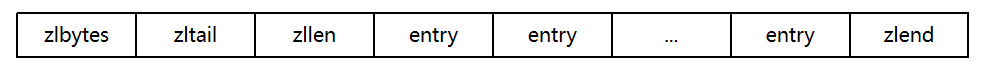

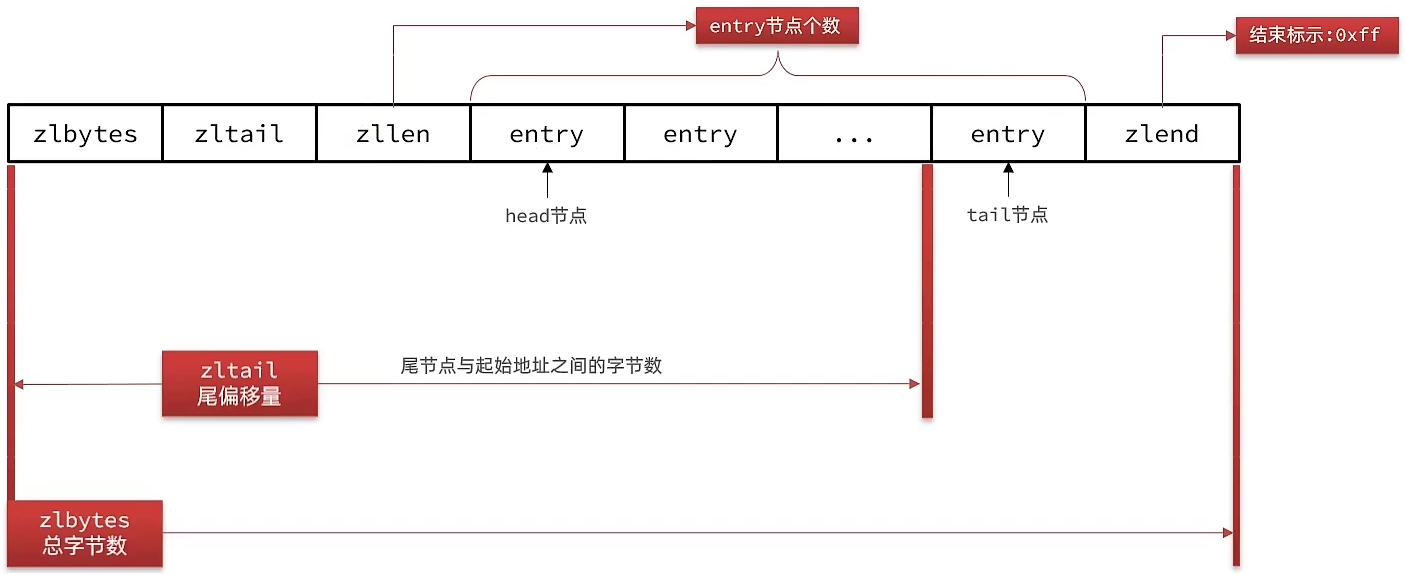

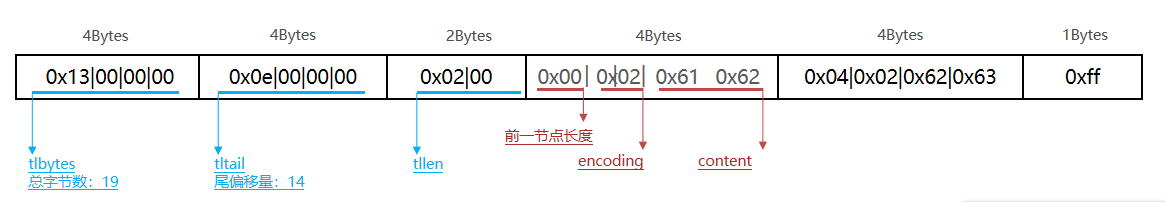

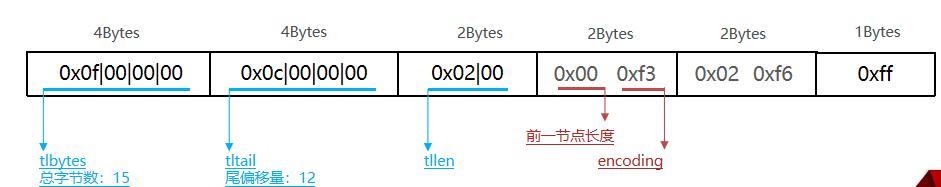

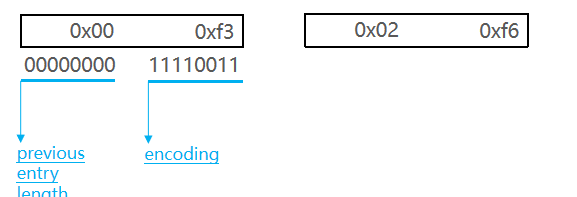

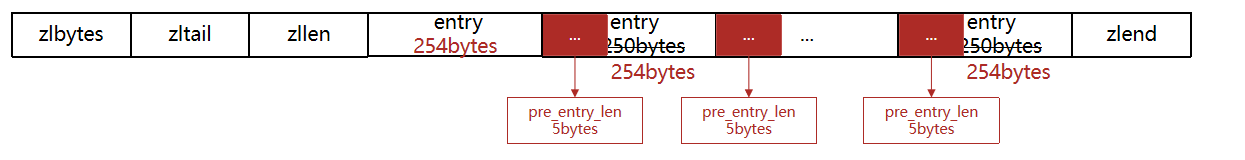

列表元素较少的情况下,会使用一块连续的内存存储,这个结构是 ziplist,即压缩列表。它将所有的元素彼此紧挨着一起存储,分配的是一块连续的内存。当数据量比较多的时候才会改成 quicklist。因为普通的链表需要的附加指针空间太大,会浪费空间,还会加重内存的碎片化,比如某普通链表里存的只是 int 类型的数据,结构上还需要两个额外的指针 prev 和 next 。所以 Redis 将链表和 ziplist 结合起来组成了quicklist,也就是将多个 ziplist 使用双向指针串起来使用。

flowchart LR

ziplist1<--> ziplist2 <--> ziplist3 <--> ziplist4

Set类型

Redis 的 Set 结构与 Java 中的 HashSet 类似,可以看做是一个 value 为 null 的 HashMap。因为也是一个 hash 表,因此具备与 HashSet 类似的特征。

- 无序

- 元素不可重复

- 查找快

- 支持交集、并集、差集等功能(寻找共同好友)

| Set 常见命令 | 说明 |

|---|---|

| SADD key member … | 向 set 中添加一个或多个元素 |

| SREM key member … | 移除 set 中的指定元素 |

| SCARD key | 返回 set 中元素的个数 |

| SISMEMBER key member | 判断一个元素是否存在于 set 中 |

| SMEMBERS | 获取 set 中的所有元素 |

| lSINTER key1 key2 … | 求 key1 与 key2 的交集 S1,S2 的交(B、C) |

| lSDIFF key1 key2 … | 求 key1 与 key2 的差集,S1,S2 的差(A) |

| lSUNION key1 key2 .. | 求 key1 和 key2 的并集,S1,S2 的并(A、B、C、D) |

127.0.0.1:6379> sadd myset a

(integer) 1

127.0.0.1:6379> sadd myset a

(integer) 0

# 获取:smembers key ==> 获取 set 集合中所有元素

127.0.0.1:6379> smembers myset

1) "a"

# srem key value ==> 删除 set 集合中的某个元素

127.0.0.1:6379> srem myset a

(integer)

练习

将下列数据用 Redis 的 Set 集合来存储

- 张三的好友有:李四、王五、赵六

- 李四的好友有:王五、麻子、二狗

利用 Set 的命令实现下列功能

- 计算张三的好友有几人

- 计算张三和李四有哪些共同好友

- 查询哪些人是张三的好友却不是李四的好友

- 查询张三和李四的好友总共有哪些人

- 判断李四是否是张三的好友

- 判断张三是否是李四的好友

- 将李四从张三的好友列表中移除

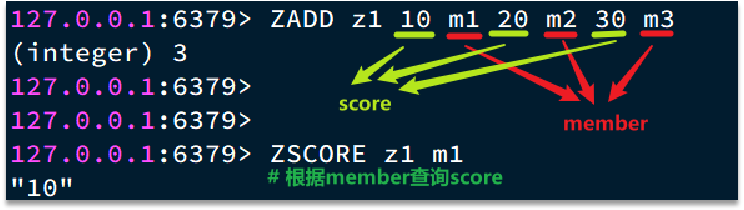

SortedSet类型

Redis 的 SortedSet 是一个可排序的 set 集合,与 Java 中的 TreeSet 有些类似,但底层数据结构却差别很大。SortedSet 中的每一个元素都带有一个 score 属性,可以基于 score 属性对元素排序,底层的实现是一个跳表(SkipList,用来排序的)+ hash 表。

SortedSet 具备下列特性

- 可排序

- 元素不重复

- 查询速度快

因为 SortedSet 的可排序特性,经常被用来实现排行榜这样的功能。

| SortedSet 的常见命令 | 默认都是升序排名 |

|---|---|

| ZADD key score membe | 添加一个或多个元素到 sorted set ,如果已经存在则更新其 score 值 |

| ZREM key member | 删除 sorted set 中的一个指定元素 |

| ZSCORE key member | 获取 sorted set 中的指定元素的 score 值 |

| ZRANK key member | 获取 sorted set 中的指定元素的排名 |

| ZCARD key | 获取 sorted set 中的元素个数 |

| ZCOUNT key min max | 统计 score 值在给定范围内的所有元素的个数 |

| ZINCRBY key increment member | 让 sorted set 中的指定元素自增,步长为指定的 increment 值,比如自增 increment(自增 1) |

| ZRANGE key min max | 按照 score 排序后,获取指定排名范围内的元素 (zrange age 0 9 ,取排名前 10 的元素) |

| ZRANGEBYSCORE key min max | 按照 score 排序后,获取指定 score 范围内的元素 |

| ZDIFF、ZINTER、ZUNION | 求差集、交集、并集 |

注意:所有的排名默认都是升序,如果要降序则在命令的 Z 后面添加 REV 即可:ZREVRange 就是降序了

# 存储:zadd key score value 把 value 加入到键值为 key 的集合中,

# 并规定分数 score,根据 score 进行排序【从小到大】

127.0.0.1:6379> zadd mysort 60 zhangsan

(integer) 1

127.0.0.1:6379> zadd mysort 50 lisi

(integer) 1

127.0.0.1:6379> zadd mysort 80 wangwu

(integer) 1

# 获取:zrange key start end [withscores]

127.0.0.1:6379> zrange mysort 0 -1

1) "lisi"

2) "zhangsan"

3) "wangwu"

127.0.0.1:6379> zrange mysort 0 -1 withscores

1) "zhangsan"

2) "60"

3) "wangwu"

4) "80"

5) "lisi"

6) "500"

# 删除:zrem key value

127.0.0.1:6379> zrem mysort lisi

(integer) 1

存储结构

SortedSet 也可称为 zset,其内部的排序功能是通过“跳跃列表”数据结构来实现的。用 SkipList 实现排序,用 HT 来实现根据 key 快速查找 value。

- SkipList:可以排序,并且可以同时存储 score 和 ele 值(member),但是查找效率没哈希表高。

- HT(Dict):可以键值存储,并且可以根据 key 找 value,但是不能做排序。

练习

将班级的下列学生得分存入 Redis 的 SortedSet 中:

- Jack 85, Lucy 89, Rose 82, Tom 95, Jerry 78, Amy 92, Miles 76

并实现下列功能:

- 删除 Tom 同学

- 获取 Amy 同学的分数

- 获取 Rose 同学的排名

- 查询 80 分以下有几个学生

- 给 Amy 同学加 2 分

- 查出成绩前 3 名的同学

- 查出成绩 80 分以下的所有同学

通用知识

容器型数据结构的通用规则

list、set、hash、zset 这四种数据结构是容器型数据结构,它们共享下面两条通用规则。

- create if not exists:如果容器不存在,那就创建一个,再进行操作。比如 rpush 操作刚开始是没有列表的,Redis 就会自动创建一个,然后再 rpush 进去新元素。

- drop if no elements:如果容器里的元素没有了,那么立即删除容器,释放内存。这意味着 lpop 操作到最后一个元素,列表就消失了。

过期时间

Redis 所有的数据结构都可以设置过期时间,时间到了,Redis 会自动删除相应的对象(但是该对象的内存不一定会立马归还给操作系统)。需要注意的是,过期是以对象为单位的,比如一个 hash 结构的过期是整个 hash 对象的过期,而不是其中的某个子 key 的过期。

有一个需要特别注意的地方,如果一个字符串已经设置了过期时间,然后你调用 set 方法修改了它,它的过期时间会消失。

内存回收

Redis 并不总是立即将空闲内存归还给操作系统。

如果当前 Redis 占用的内存有 10G,删除 1GB 的 key 后,再去观察 Redis 内存的占用情况会发现内存变化不会太大。因为 OS 是以页为单位回收内存(内存默认是段页式存储?)的,这个页面上只要还有一个 key 在使用就不会被回收。虽然删除了 1GB 的 key,但是这些 key 分散在了很多页面中,如果每个页面都有其他 key 存在,内存就不会被回收!

内存分配

内存分配需要考虑使用何种算法划分内存页,如何处理内存碎片。Redis 则是直接采用现成的内存分配库。可以使用 jemalloc (facebook)、tcmalloc (google)。jemalloc 的性能比 tcmalloc 稍好,因此 Redis 默认用的 jemalloc。

分布式锁

分布在不同机器上的应用需要操作同一个资源,如修改用户状态,需要多个步骤,如先读取再修改,如果不施加访问条件,多个机器同时尝试修改就会出现并发问题。这是可以使用 Redis 的 setnx 来实现分布式锁(理论上,自己写个服务,部署在一台机器上也可以实现分布式锁的功能)。

使用分布式锁

分布式锁本质上要实现的目标就是在 Redis 里面占一个“坑”,当别的进程也要来占坑时,发现那里已经有一根“大萝卜”了,就只好放弃或者稍后再试。

占坑一般使用 setnx(set if not exists) 指令,只允许被一个客户端占坑。先来先占,用完了,再调用 del 指令释放“坑”。

但是有个问题,如果逻辑执行到中间出现异常了,可能会导致 del 指令没有被调用,这样就会陷入死锁,锁永远得不到释放。我们可以在拿到锁之后,再给锁加上一个过期时间,比如 5s,这样即使中间出现异常也可以保证 5s 之后锁会自动释放。

但是,如果在 setnx 和 expire 之间服务器进程突然挂掉了,可能是因为机器掉电或者是人为造成的,就会导致 expire 得不到执行,也会造成死锁。

flowchart LR

set-->|竞争|setnx--x|过期|expire

Redis 2.8 加入了 set 指令的扩展参数,使得 setnx 和 expire 指令可以一起执行,解决了该问题。

# 不存在才设置,设置过期时间为 10s

set key value nx ex 10

# 获取剩余的过期时间

ttl key

# 毫秒级别的获取

pttl key

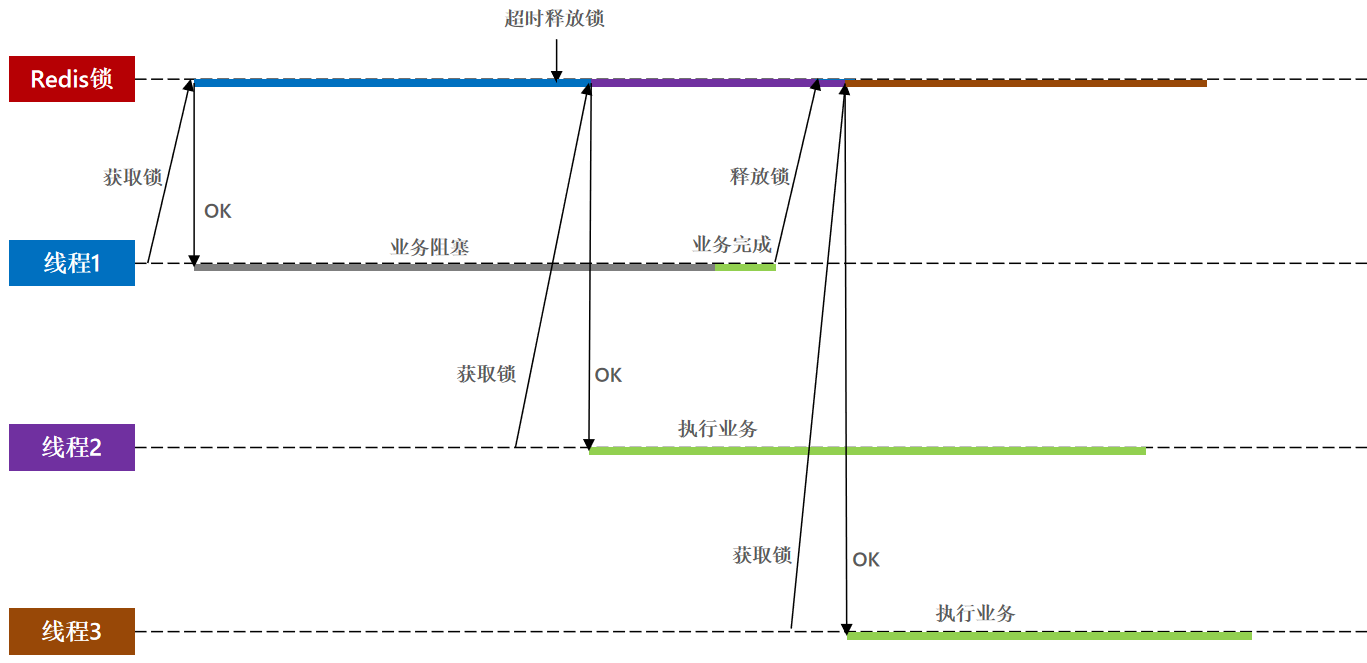

超时问题

Redis 的分布式锁不能解决超时问题,如果在加锁和释放锁之间的逻辑执行得太长,以至于超出了锁的超时限制,就会出现问题。因为这时候第一个线程持有的锁过期了,临界区的逻辑还没有执行完,而同时第二个线程就提前重新持有了这把锁,导致临界区代码不能得到严格串行执行。

为了避免这个问题,Redis 分布式锁不要用于较长时间的任务。如果真的偶尔出现了问题,造成的数据小错乱可能需要人工介入解决。

稍微安全一点的方案是将 set 指令的 value 参数设置为一个随机数,释放锁时先匹配随机数是否一致,然后再删除 key,这是为了确保当前线程占有的锁不会被其他线程释放,除非这个锁是因为过期了而被服务器自动释放的。

但是由于查找 value 和删除 key 不是原子性的,需要使用 lua 脚本保证连续多个指令的原子性执行。

但是如果真的超时了,当前线程的逻辑没有执行完,其他线程也会乘虚而入。

可重入锁

可参考 Java 的 ReentrantLock 来编写基于 Redis 的可重入分布式锁。也可采用 Redssion 这个三方库。

延时队列

如果在某个场景我们需要用到延迟队列,且场景比较简单,对消息的可靠性要求也不好高,此时可以用 Redis 的延迟队列。

Redis 的消息队列不是专业的消息队列,它没有非常多的高级特性,没有 ack 保证,如果对消息的可靠性有着极高要求,那么它就不适合使用。

异步消息队列

Redis 的 list(列表)数据结构常用来作为异步消息队列使用,用 rpush 和 lpush 操作入队列, lpop 和 rpop 操作出队列。但是如果队列为空了,消费者仍会不断执行 lpop/rpop,这种空轮询会拉高客户端的 CPU 消耗,也会拉高 Redis 的 QPS,降低 Redis 的性能。

上述问题可以用线程定期 sleep 来解决,但是这种方式不是最佳的。比较合理的是利用 list 的阻塞读取 blpop/brpop。有数据则读取,无数据则阻塞住。但是,如果线程一直阻塞在那里,Redis 的客户端连接就成了闲置连接,闲置过久,服务器一般会主动断开连接,减少闲置资源占用。这个时候 blpop/brpop 会抛出异常。因此,在编写阻塞获取这类方法的时候要小写,如果捕获到异常需要重试,指定时间范围内重试失败后再放弃。

延迟队列

先前提到了分布式锁请求加锁失败的问题。遇到加锁失败,可以用以下三种策略

- 直接抛出异常,通知用户稍后重试。

- sleep 一会儿,然后再重试。

- 将请求转移至延时队列,过一会儿再试。

直接抛出异常

这种方式适合用户发起请求出现异常的情况。返回给用户错误提示,让他稍后再试。

sleep 一会

sleep 会阻塞当前的消息处理线程,会导致队列的后续消息处理出现延迟。如果碰撞得比较频繁或者队列里消息比较多,sleep 可能并不合适。如果因为个别死锁的 key 导致加锁不成功,线程会彻底堵死,导致后续消息永远得不到及时处理。

延迟队列

这种方式比较适合异步消息处理,将当前冲突的请求扔到另一个队列延后处理以避开冲突。

Redis 实现延迟队列

Redis 可以使用 SortedSet 来模拟延时队列。消息本身作为 key,到期处理时间作为 score。然后多线程轮询 SortedSet 获取到期的任务进行处理。使用多线程处理可以保证服务的可用性,避免某些线程挂调无法及时处理。

多线程争用一个延迟队列的话需要考虑并发安全问题。Redis 处理命令是单线程的,因此是线程安全的。可能出现并发问题的是多个线程拿到了同一个待处理的消息,要确保只有一个线程消费。

def loop():

while True:

values = redis.zrangebyscore("delay-queue", 0, time.time(), start=0, num=1)

if not values:

time.sleep(1) # 没有数据就休眠一秒

continue

value = values[0]

success = redis.zrem("delay-queue",value)

if success:

msg = json.loads(value) # 反序列化为对象

hande_msg(msg) # 消费消息的函数

消费前先尝试移除,如果移除成功,则说明自己是第一个删除的人,有权执行,正常执行。如果移除失败,说明有人先一步移除了,就不消费消息。

同一个任务可能会被多个消费端获取后再使用 zrem 进行争抢,那些没抢到的都白取了一次任务。可以考虑使用 lua scripting 来优化一下这个逻辑,将 zrangebyscore 和 zrem 一同挪到服务器端进行原子化操作,这样就不会出现这种浪费了。

位图

位图,bitmap,就是用一个 bit 位来标记某个元素对应的 Value,而 Key 即是该元素。由于采用了 Bit 为单位来存储数据,因此在存储空间方面,可以大大节省。典型的场景有:记录用户一年的签到记录,签到了是 1,没签到是 0。

基本用法

setbit key offset value

时间复杂度:O(1),offset 从 0 开始计数。

> setbit name 0 1

0

> get name

"\x80"

如果对应位的字节是不可打印字符,redis-cli 会显示该字符的十六进制形式。

统计和查找

Redis 提供了位图统计指令 bitcount 和位图查找指令 bitpos。bitcount 用来统计指定位置范围内 1 的个数,bitpos 用来查找指定范围内出现的第一个 0 或 1。

可以通过 bitcount 统计用户一共签到了多少天,通过 bitpos 指令查找用户从哪一天开始第一次签到。这两个命令的范围参数 [start, end] 是字节索引,而非 bit 位。因此,如果我们想统计某个月内用户签到了几天,必须将这个月所覆盖的字节内容全部取出来,然后在内存里进行统计。

# E 的 ASCII 69, 二进制为 0100,0101

# G 的 ASCII 71, 二进制为 0100,0111

# 设置某个 bit 位为 1

> setbit name 0 1

# 直接设置整个字符串

> set name EEGG

OK

> bitcount name

(integer) 14

> bitcount name 0 0 # 第 0 个字符为 1 的 bit 的个数

(integer) 3

> bitcount name 0 1 # 0~1 字符(第 0 个和第 1 个)字符的 bit 的个数

(integer) 6

#====================================

> bitpos name 0 # 第一个 0 位

(integer) 0

> bitpos name 1 # 第一个 1 位

(integer) 1

> bitpos name 1 2 2 # 从第三个字符算起,第一个 1 位,都是从 0 开始计数的

(integer) 17

bitfield

bitfield,无需使用管道便可一次进行多个位的操作。bitfield 有三个子指令,分别是 get、set、incrby,它们都可以对指定位片段进行读写,但是最多只能处理 64 个连续的位,如果超过 64 位,就得使用多个子指令, bitfield 可以一次执行多个子指令。

# 从第 0 位开始取 4 位,结果是无符号。

> BITFIELD name get u4 0

1) (integer) 4

# 从第 8 位开始取 8 位,结果是无符号。正好和 E 的 ASCII 对上了

> BITFIELD name get u8 8

1) (integer) 69

一次执行多个子指令

# 从第 0 位开始取 4 位,结果是无符号。

# 从第 0 位开始取 3 位,结果是无符号。

> bitfield name get u4 0 get u3 0

1) (integer) 4

2) (integer) 2

incrby,对指定范围的位进行自增操作。

# 从第三个位开始,对接下来的 4 位无符号数 +1

> bitfield name incrby u4 2 1

1) (integer) 2

HyperLogLog

HyperLogLog 提供了不精确的去重计数方案,标准误差是 0.81%,经可以满足常用的 UV 统计需求。

基本用法

HyperLogLog 提供了两个指令 pfadd 和 pfcount,一个是增加计数,一个是获取计数。pfadd 和 set 集合的 sadd 的用法是一样的,来一个用户 ID,就将用户 ID 放进去就是。pfcount 和 scard 的用法是一样的,直接获取计数值。

除了计数外还提供了合并多个数据的指令,pfmerge。

> pfadd uv user1

(integer) 1

> pfadd uv user2

(integer) 1

> pfadd uv user3

(integer) 1

> pfadd uv user4

(integer) 1

> pfcount uv

(integer) 4

用 Python 脚本模拟大量用户的 UV 请求。

# python 简单方便,因此用 python 测试

import redis

def test_uv():

client = redis.StrictRedis()

for item in range(100000):

client.pfadd("uv", "user%d" % item)

total = client.pfcount("uv")

# 99725

print(total)

if __name__ == '__main__':

test_uv()

执行了 10w 次,但是最后的结果是 9.9725w,误差不大。

pfmerge 将多个 key 的数据进行合并

> pfadd u1 a b c

(integer) 1

> pfadd u2 a1 b1 c1

(integer) 1

> pfmerge new_u u1 u2

OK

> pfcount new_u

(integer) 6

基本原理

HyperLogLog 实际上不会存储每个元素的值,它使用的是概率算法,通过存储元素的 hash 值的第一个 1 的位置,来计算元素数量。

(28条消息) HyperLogLog 使用及其算法原理详细讲解_李子捌的博客-CSDN博客_hyperloglog

pf 的内存占用

Redis 的 HyperLogLog 实现中用的是 16384 个桶,也就是 $2^{14}$,每个桶的 maxbits 需要 6 个 bit 来存储,最大可以表示 maxbits=63,于是总共占用内存就是 $2^{14}*6/8$”,算出来的结果即是 12KB。

不过 Redis 对 HyperLogLog 的存储进行了优化,在计数比较小时,它的存储空间采用稀疏矩阵存储,空间占用很小,仅仅在计数慢慢变大、稀疏矩阵占用空间渐渐超过了阈值时,才会一次性转变成稠密矩阵,才会占用 12KB 的空间。

布隆过滤器

用于在大量数据下的去重。它在起到去重作用的同时,在空间上还能节省 90% 以上。Redis 4.0 的时候开始提供布隆过滤器的插件。

基本用法

从 docker 中拉取带有布隆过滤器插件的 redis

docker pull redislabs/rebloom

docker run -p6379:6379 redislabs/rebloom

redis-cli

布隆过滤器有两个基本指令,bf.add 和 bf.exists。

基本原理

布隆过滤器的原理也和概率相关:每个布隆过滤器对应到 Redis 的数据结构里面就是一个大型的位数组和几个不一样的无偏 hash 函数。无偏就是能够把元素的 hash 值算得比较均匀,让元素被 hash 映射到位数组中的位置比较随机。

判断数据是否存在时也是根据数据计算出这个数据应该在那几个 bit 位上,然后查找对应的几个 bit 是否为 1,都为 1 说明存在了,有不为 1 的说明不存在。

空间占用估计

布隆过滤器的空间占用计算的公式如下 \(k=0.7*(1/n) -- 约等于\\ f=0.6185^{1/n}\)

- n:预计元素的数量

- f:错误率

- k:hash 函数的最佳数量,hash 函数的个数会影响错误率

从上述表述可以看出,位数组相对越长 $\frac{1}{n}$,错误率 f 越低。

- 当一个元素平均需要 1 个字节(8bit)的指纹空间时($\frac{1}{n}=8$),错误率大约为 2%。

- 错误率为 10% 时,一个元素需要的平均指纹空间为 4.792 个 bit,大约为 5bit。

- 错误率为 1% 时,一个元素需要的平均指纹空间为 9.585 个 bit,大约为 10bit。

- 错误率为 0.1% 时,一个元素需要的平均指纹空间为 14.377 个 bit,大约为 15bit。

如果元素的内容长,如十几甚至是上百字节,除此之外还要一个指针指向元素,这个指针又会占 4 个字节或 8 个字节。而布隆过滤器在错误率为 0.1% 时,仅仅需要 2 个字节,空间优势非常明显。

count=900000000

error=0.001

functions=9.96

size=1579568.94kb

https://krisives.github.io/bloomcalculator

当实际元素超出预计元素时,错误率的变化可用该公式进行计算. \(f=(1-0.5^t)^k \ \ \ k \ 为 \ hash \ 函数的最佳数量,\ t \ 为倍数比\) 错误率为 0.1% 时,倍数比为 2 时,错误率会升至 5%。

限流

5种常见限流算法! - Java填坑笔记 - 博客园 (cnblogs.com)

当系统处理能力有限时,可以限制请求的数量,阻止执行计划以外的请求。简单的单机限流可以用信号量、guava 库。如果是分布式场景下限定了某个用户在指定时间内只能点击多少次,可以用 Redis 来做限流。

固定窗口限流算法

首先维护一个计数器,将单位时间段当做一个窗口,计数器记录这个窗口接收请求的次数。

- 当次数少于限流阀值,就允许访问,并且计数器 +1;

- 当次数大于限流阀值,就拒绝访问;

- 当前的时间窗口过去之后,计数器清零。

具体做法:设置一个 key-value,value 为请求的次数,并设置 ttl。第一次请求没有数据时就初始化,后面请求时,如果发现 key 的有效期内容请求次数超过了限定的次数,则不再允许调用对应的方法。这是最简单粗暴的方法,限流的方式不够平稳。

滑动窗口限流算法

滑动窗口限流解决固定窗口临界值的问题。它将单位时间周期分为 n 个小周期,分别记录每个小周期内接口的访问次数,并且根据时间滑动删除过期的小周期。如限定了 1s 可以执行 10 次,那么 0~100ms 的时候可以执行一次,100~200ms 的时候可以执行一次。这种限流方式更为平稳。滑动窗口算法虽然解决了固定窗口的临界问题,但是一旦到达限流后,请求都会直接暴力被拒绝。

思考下,利用 Redis 应该怎么做呢?如何维护这个时间窗口呢?既要可以维护时间窗口,又能知道对应窗口内执行了多少次,用什么数据结构合适?SortedSet!

SortedSet 记录时间戳,获取的时候获取 [now-period, now] 范围内的数据(zcount key now-period, now)没超过阈值就放行,同时记得删除时间窗口之前的记录。

import time

import redis

client = redis.StrictRedis()

def is_action_allowed(user_id, action_key, period, max_count):

key = "times: %s:%s" % (user_id, action_key)

now_ts = int(time.time() * 1000)

with client.pipeline() as pipe:

# value 和 score 都用时间戳

pipe.zadd(key, now_ts, now_ts)

# 移除时间窗口之前的行为记录

pipe.zremrangebyscore(key, 0, now_ts - period * 1000)

# 获取窗口内的行为数量

pipe.zcard(key)

# 设置 zset 过期时间,避免冷用户持续占用内存

pipe.expire(key, period+1)

# 批量执行

_,_,current_count <= pipe.execute()

return current_count<=max_count

for item in range(20):

print(is_action_allowed("test", "reply", 60 ,10))

漏桶算法

漏桶算法面对限流,就更加的柔性,不存在直接的粗暴拒绝。可以往漏桶中以任意速率流入水,以固定的速率流出水。只有当水超过桶的容量时,请求才会被溢出,也就是被丢弃。

- 流入的水滴,可以看作是访问系统的请求,这个流入速率是不确定的。

- 桶的容量一般表示系统所能处理的请求数。

- 如果桶的容量满了,就达到限流的阀值,就会丢弃水滴(拒绝请求)

- 流出的水滴,是恒定过滤的,对应服务按照固定的速率处理请求。

在正常流量的时候,系统按照固定的速率处理请求,是我们想要的。但是面对突发流量的时候,漏桶算法还是循规蹈矩地处理请求,这就不是我们想看到的啦。流量变突发时,我们肯定希望系统尽量快点处理请求,提升用户体验。

Redis 4.0 提供了一个限流 Redis 模块,它叫 Redis-Cell。该模块也使用了漏斗算法,并提供了原子的限流指令。

分布式限流 redis-cell - 简书 (jianshu.com)

令牌桶算法

面对突发流量的时候,我们可以使用令牌桶算法限流。

- 有一个令牌管理员,根据限流大小,定速往令牌桶里放令牌。

- 如果令牌数量满了,超过令牌桶容量的限制,那就丢弃。

- 系统在接受到一个用户请求时,都会先去令牌桶要一个令牌。如果拿到令牌,那么就处理这个请求的业务逻辑;

- 如果拿不到令牌,就直接拒绝这个请求。

如果令牌发放的策略正确,这个系统即不会被拖垮,也能提高机器的利用率。Guava 的 RateLimiter 限流组件,就是基于令牌桶算法实现的。

Java 的 Semaphore 可以实现该功能,利用定时器定期向 Semaphore 中投放许可证即可。Redis 的话,可以用 String 类型的结构 lock-time,一个线程专门用来定期为 time++,其他请求执行时利用 lua 对 lock 做出判断和自减操作,自减成功则可执行,失败则说明限流了。

GeoHash

GeoHash 算法是业界比较通用的地理位置距离排序算法,Redis 也使用 GeoHash 算法。GeoHash 算法将二维的经纬度数据映射到一维的整数,这样所有的元素都将挂载到一条线上,距离靠近的二维坐标映射到一维后的点之间距离也会很接近。当我们想要计算“附近的人”时,首先将目标位置映射到这条线上,然后在这个一维的线上获取附近的点即可。

注意事项

在一个地图应用中,车的数据、餐馆的数据、人的数据可能会有几百万条甚至几千万条,如果使用 Redis 的 Geo 数据结构,它们将被全部放在一个 zset 集合中。在 Redis 的集群环境中,集合可能会从一个节点迁移到另一个节点,如果单个 key 的数据过大,会对集群的迁移工作造成较大的影响,在集群环境中单个 key 对应的数据量不宜超过 1MB,否则会导致集群迁移出现卡顿现象,影响线上服务的正常运行。

所以,建议 Geo 的数据使用单独的 Redis 实例部署,不使用集群环境。

如果数据量过亿个,甚至更大,就需要对 Geo 数据进行拆分,按国家拆分、按省拆分、按市拆分,在人口特大城市甚至可以按区拆分。这样就可以显著降低单个 zset 集合的大小。

Scan

在平时线上 Redis 维护工作中,有时候需要从 Redis 实例的成千上万个 key 中找出特定前缀的 key 列表来手动处理数据,可能是修改它的值,也可能是删除 key。这里就有一个问题,如何从海量的 key 中找出满足特定前缀的 key 列表?

Redis 提供了一个简单粗暴的指令 keys 用来列出所有满足特定正则字符串规则的 key。但是 keys 不能分页。而且 keys 算法是遍历算法,复杂度是 O(n),如果实例中有千万级以上的 key,这个指令就会导致 Redis 服务卡顿,所有读写 Redis 的其他指令都会被延后甚至会超时报错。

Redis 在 2.8 版本中加入了指令——scan,解决了上述的问题。

特点

- 复杂度虽然也是 O(n),但它是通过游标分步进行的,不会阻塞线程。

- 提供 limit 参数,可以控制每次返回结果的最大条数。注意 limit 只是一个 hint,返回的结果可多可少。

- 同 keys 一样,它也提供模式匹配功能。

- 服务器不需要为游标保存状态,游标的唯一状态就是 scan 返回给客户端的游标整数。

- 返回的结果可能会有重复,需要客户端去重,这点非常重要。

- 遍历的过程中如果有数据修改,改动后的数据能不能遍历到是不确定的。

- 单次返回的结果是空的并不意味着遍历结束,而要看返回的游标值是否为零。

基本用法

先向 Redis 中插入大量的数据进行测试。仍然是使用 Python 脚本。

import redis

client = redis.StrictRedis()

for item in range(200):

client.set("key%d" % item,item)

利用 scan 获取 key,语法为 scan ooo match kkk count xxx,如 scan 0 match key1* count 10,从 0 开始,查找符合 key1* 匹配规则的 key,查找 10 个(槽位,最后扫描出的元素数量可能少于 10)。

> scan 0 match key1* count 10

1) "48"

2) 1) "key157"

2) "key199"

3) "key148"

4) "key193"

5) "key125"

6) "key181"

> scan 48 match key1* count 10

1) "120"

2) 1) "key111"

2) "key131"

3) "key177"

4) "key129"

5) "key192"

6) "key182"

当游标值为零时,意味着遍历结束了。

槽位

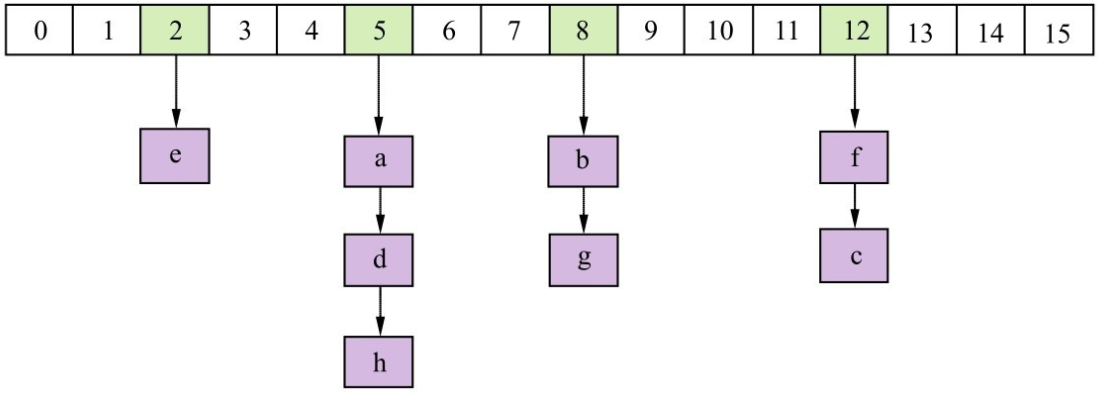

在 Redis 中所有的 key 都存储在一个很大的哈希表中。该哈希表由数组和链表组成。数组的大小总是 $2^n,n ≥0$,每扩容一次数组,大小空间加倍。

scan 指令返回的游标就是第一维数组的位置索引(这个位置索引也称为槽 slot)。如果不考虑字典的扩容缩容,直接按数组下标挨个遍历就行了。

limit 参数就表示需要遍历的槽位数,之所以返回的结果可能多可能少,是因为不是所有的槽位上都有元素/链表,有些槽位可能是空的,有些槽位上挂接的链表上的元素可能会有多个。每一次遍历都会将 limit 数量的槽位上挂接的所有链表元素进行模式匹配过滤后,一次性返回给客户端。

遍历顺序

这块书里写的很模糊,后面查到合适的资料再进行补充。

big key 扫描

有时候会因为业务人员使用不当,在 Redis 实例中形成了很大的对象,比如一个很大的 hash 或一个很大的 zset,都是可能出现的。这样的对象给 Redis 的集群数据迁移带来了很大的问题。

- 在集群环境下,如果某个 key 太大,会导致数据迁移卡顿。

- 在内存分配上,如果一个 key 太大,那么当它需要扩容时,会一次性申请更大的一块内存,这也会导致卡顿。

- 在内存释放上,如果一个大 key 被删除,内存会被一次性回收,卡顿现象也会再次产生。

如果发现 Redis 的内存大起大落,这极有可能是因为大 key 导致的,这时候就需要先定位出具体是哪个 key,再进一步定位出具体的业务来源,然后改进相关业务代码设计。

如果 key 非常多,直接使用 keys 拿到所有的 key 再逐个遍历的话,会给 Redis 带来极大的压力,导致卡顿。为了避免给线上 Redis 带来卡顿,就要用到 scan 指令,对于扫描出来的每一个 key,使用 type 指令获得 key 的类型,然后使用相应数据结构的 size 或者 len 方法来得到它的大小,对于每一种类型,将大小排名的前若干名作为扫描结果展示出来。

上面这样的过程需要编写脚本,比较烦琐,Redis 官方在 redis-cli 指令中提供了这样的扫描功能,我们可以直接拿来使用。

redis-cli -h 127.0.0.1 -p 7001 --bigkeys

如果担心这个指令会大幅抬升 Redis 的 ops 导致线上报警,还可以增加一个休眠参数。

redis-cli -h 127.0.0.1 -p 7001 --bigkeys -i 0.1

命令的执行结果

payphone@cv:/home/redis-6.2.1$ ./bin/redis-cli -h 127.0.0.1 -p 6379 --bigkeys

# Scanning the entire keyspace to find biggest keys as well as

# average sizes per key type. You can use -i 0.1 to sleep 0.1 sec

# per 100 SCAN commands (not usually needed).

[00.00%] Biggest string found so far '"key157"' with 3 bytes

-------- summary -------

Sampled 200 keys in the keyspace!

Total key length in bytes is 1090 (avg len 5.45)

Biggest string found '"key157"' has 3 bytes

0 lists with 0 items (00.00% of keys, avg size 0.00)

0 hashs with 0 fields (00.00% of keys, avg size 0.00)

200 strings with 490 bytes (100.00% of keys, avg size 2.45)

0 streams with 0 entries (00.00% of keys, avg size 0.00)

0 sets with 0 members (00.00% of keys, avg size 0.00)

0 zsets with 0 members (00.00% of keys, avg size 0.00)

设计KEY

Redis 没有类似 MySQL 中的 Table 的概念,我们该如何区分不同类型的 key 呢?例如,需要存储用户、商品信息到 redis,有一个用户 id 是1,有一个商品 id 恰好也是 1。

可以采用 项目名:业务名:类型:id 这种多个单词形成层级结构,单词间用 ‘:’ 隔开的方式设计 key。

-

user 相关的 key:

project_name:user:1 -

product 相关的 key:

project_name:product:1

在 redis 内部,最后会以层级关系显示这些数据。

如果 value 是一个 Java 对象,如一个 User 对象,则可以将对象序列化为 JSON 字符串后存储。

| key | value |

|---|---|

| user:1 | {“id”:1, “name”: “Jack”, “age”: 21} |

| product:1 | {“id”:1, “name”: “小米11”, “price”: 4999} |

Redis 的 key 的格式==>[项目名]:[业务名]:[类型]:[id]

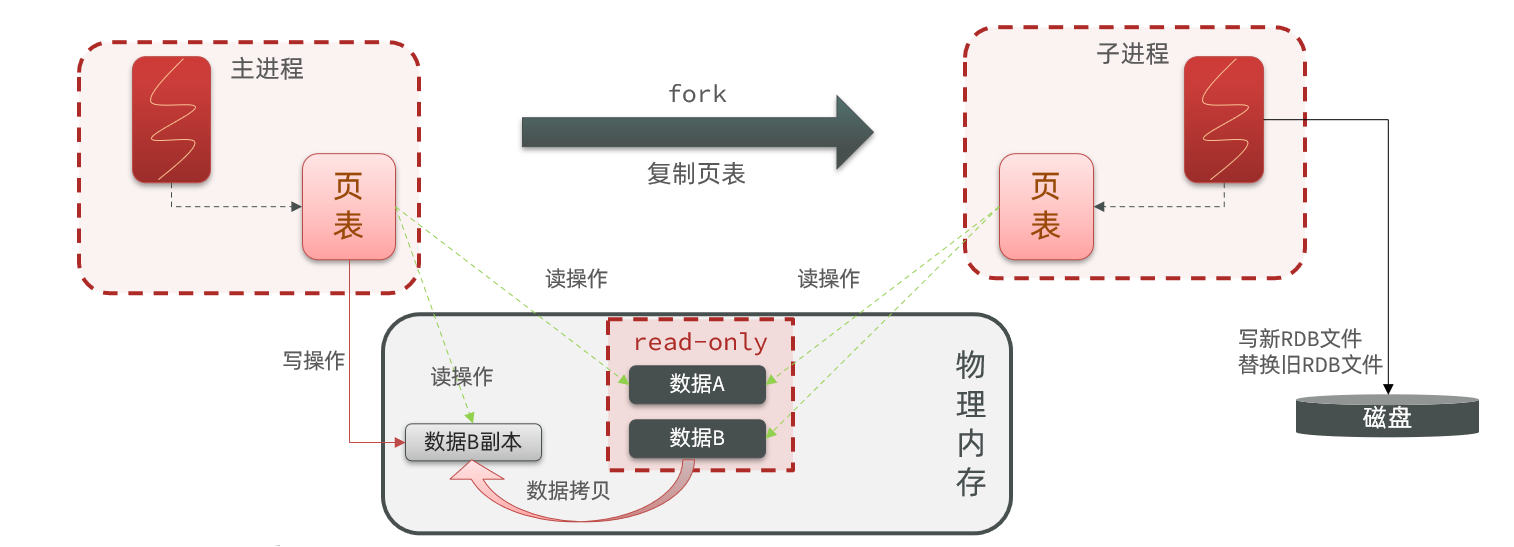

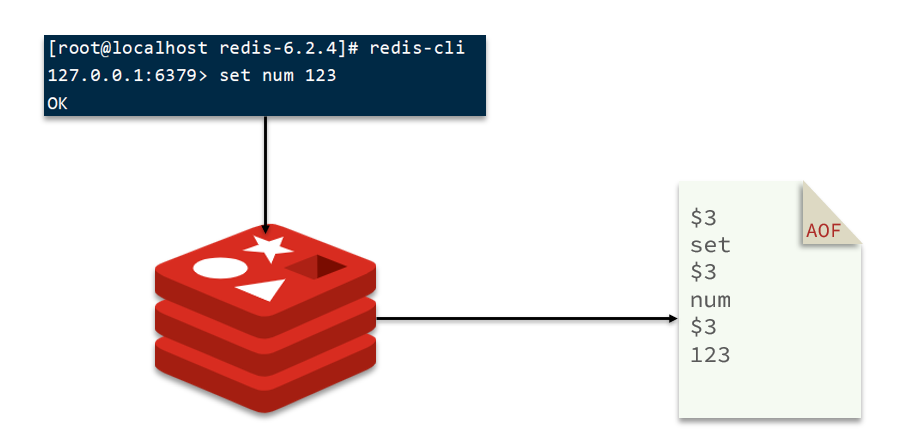

持久化

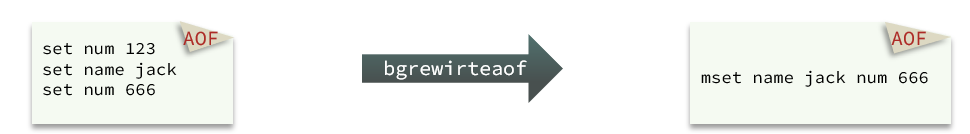

Redis 持久化机制有两种方式:RDB 和 AOF,而持久化策略有四种。

RDB:默认方式,不需要进行配置,默认就使用这种机制。在一定的间隔时间中,检测 key 的变化情况,然后持久化数据。

编辑 redis.windwos.conf 文件

after 900 sec (15 min) if at least 1 key changed

save 900 1

after 300 sec (5 min) if at least 10 keys changed

save 300 10

after 60 sec if at least 10000 keys changed

save 60 10000

重新启动 redis 服务器,并指定配置文件名称

D:\redis\windows-64\redis-2.8.9>redis-server.exe redis.windows.conf

AOF:日志记录的方式,可以记录每一条命令的操作。可以每一次命令操作后,持久化数据。

编辑 redis.windwos.conf 文件

# appendonly no(关闭aof) --> appendonly yes (开启aof)

appendfsync always # 每一次操作都进行持久化

appendfsync everysec # 每隔一秒进行一次持久化

appendfsync no # 不进行持久化

Java客户端

在 Redis 官网中提供了各种语言的客户端,地址:https://redis.io/clients

Jedis

①引入依赖

<!-- jedis 客户端-->

<dependency>

<groupId>redis.clients</groupId>

<artifactId>jedis</artifactId>

</dependency>

②建立连接

jedis = new Jedis("192.168.160.44", 6379);

③使用 Jedis

jedis.set("name", "hahah");

④释放资源

jedis.close();

完整代码

import org.junit.After;

import org.junit.Before;

import org.junit.Test;

import org.springframework.boot.test.context.SpringBootTest;

import redis.clients.jedis.Jedis;

@SpringBootTest

public class TestJedis {

private Jedis jedis;

@Before

public void setUp() {

jedis = new Jedis("192.168.160.44", 6379);

}

@Test

public void test() {

jedis.set("name", "hahah");

}

@Test

public void connection(){ // 测试连接

jedis.set("111","1");

// 设置超时时间

jedis.expire("1111",30);

jedis.close();

Client client = jedis.getClient();

}

@Test

public void saveString() throws JsonProcessingException { // 存储String

Person p1 = new Person("kkl1", "18", "nan", 88, "1997-11-11");

Person p2 = new Person("kkl2", "18", "nan", 88, "1997-11-11");

Person p3 = new Person("kkl3", "18", "nan", 88, "1997-11-11");

ArrayList<Person> list = new ArrayList<>();

list.add(p1);

list.add(p2);

list.add(p3);

ObjectMapper obj = new ObjectMapper();

String json = obj.writeValueAsString(list);

jedis.set("data",json);

jedis.expire("data",300);

String data = jedis.get("data");

System.out.println(data);

jedis.close();

}

@Test

public void saveList(){ // 操作List

jedis.lpush("mylist","a");

jedis.lpush("mylist","aa");

jedis.lpush("mylist","aaa");

jedis.lpush("mylist","aaaa");

List<String> mylist = jedis.lrange("mylist", 0, -1);

mylist.stream().forEach(System.out::println);

jedis.close();

}

@Test

public void saveSet(){ // 操作set,不包括重复元素

jedis.sadd("setdemo","1","2","3","4");

jedis.sadd("setdemo","1","5","7","1");

Set<String> setdemo = jedis.smembers("setdemo");

setdemo.stream().forEach(System.out::println);

jedis.srem("setdemo","1","2","3","4","5");

jedis.close();

}

@After

public void close() {

jedis.close();

}

}

Jedis 连接池

Jedis 本身是线程不安全的,并且频繁的创建和销毁连接会有性能损耗,因此推荐使用 Jedis 连接池代替 Jedis 的直连方式。而 JedisPool 连接池是 Redis 自带的。

- 创建 JedisPool 连接池对象

- 调用方法 getResource() 方法获取 Jedis 连接

- JedisPoolConfig config = new JedisPoolConfig();

- config.setMaxTotal(50);

- config.setMaxIdle(10);

- 创建 Jedis 连接池对象,JedisPool jedisPool = new JedisPool(config,”localhost”,6379);

- 获取连接,Jedis jedis = jedisPool.getResource();

- 使用

- 关闭连接

// Jedis 连接池

import redis.clients.jedis.Jedis;

import redis.clients.jedis.JedisPool;

import redis.clients.jedis.JedisPoolConfig;

public class JedisUtils {

private static final JedisPool jedisPool;

static {

JedisPoolConfig config = new JedisPoolConfig();

config.setMaxIdle(10);

config.setMinIdle(5);

config.setMaxTotal(20);

config.setMaxWaitMillis(1000);

jedisPool = new JedisPool(config, "192.168.2.240");

}

public static Jedis getJedis() {

return jedisPool.getResource();

}

public static void close(Jedis jedis){

jedis.close(); // 有连接池则归还到池中,没有则直接关闭

}

}

@SpringBootTest

public class TestJedis {

private Jedis jedis;

@Before

public void setUp() {

jedis = JedisUtils.getJedis();

}

@Test

public void test() {

jedis.set("name", "hahah");

String name = jedis.get("name");

System.out.println(name);

}

@After

public void close() {

jedis.close();

}

}

这里解释下为什么说 Jedis 是线程不安全的。

简单说就是,Jedis 共享了 Socket。Jedis 类中有 RedisInputStream 和 RedisOutputStream 两个属性,而发送命令和获取返回值都是使用这两个成员变量,这很容易引发多线程问题。Jedis 执行命令前需要创建一个 conneciton 连接:

public void connect() {

// 如果 socket 连接关闭了的话,创建一个新的连接。

if (!this.isConnected()) {

try {

this.socket = this.jedisSocketFactory.createSocket();

this.outputStream = new RedisOutputStream(this.socket.getOutputStream());

this.inputStream = new RedisInputStream(this.socket.getInputStream());

} catch (IOException var2) {

this.broken = true;

throw new JedisConnectionException("Failed connecting to " + this.jedisSocketFactory.getDescription(), var2);

}

}

}

可能两个线程出现这种情况:

sequenceDiagram

participant T1 as 线程1

participant T2 as 线程2

participant S as Socket

T1->>S:进入了 if ( !this.isConnected() ) 花括号里

T1-->>T2:线程上下文切换,线程2开始执行

T2->>S:也进入了 if ( !this.isConnected() ) 花括号里

T2-->>T1:线程上下文切换,线程1继续执行

T1->>S:创建了 socket,准备执行InputStream方法,接收redis的响应了

T1-->>T2:线程上下文切换,线程2开始执行

T2->>S:创建了socket,但是还没有初始化连接

T2-->>T1:线程上下文切换,线程1继续执行

T1-->S:线程1用未connection的连接获取InputStream出错

SpringDataRedis

SpringDataRedis 介绍

SpringData 是 Spring 中数据操作的模块,包含对各种数据库的集成,其中对 Redis 的集成模块就叫做 SpringDataRedis

官网地址:https://spring.io/projects/spring-data-redis

- 提供了对不同 Redis 客户端的整合(Lettuce 和 Jedis)

- 提供了 RedisTemplate 统一 API 来操作 Redis

- 支持 Redis 的发布订阅模型

- 支持 Redis 哨兵和 Redis 集群

- 支持基于 Lettuce 的响应式编程

- 支持基于 JDK、JSON、字符串、Spring 对象的数据序列化及反序列化

- 支持基于 Redis 的 JDKCollection 实现

快速入门

SpringDataRedis 中提供了 RedisTemplate 工具类,其中封装了各种对 Redis 的操作。并且将不同数据类型的操作 API 封装到了不同的类型中:

| API | 返回值类型 | 说明 |

|---|---|---|

| redisTemplate.opsForValue() | ValueOperations | 操作 String 类型数据 |

| redisTemplate.opsForHash() | HashOperations | 操作 Hash 类型数据 |

| redisTemplate.opsForList() | ListOperations | 操作 List 类型数据 |

| redisTemplate.opsForSet() | SetOperations | 操作 Set 类型数据 |

| redisTemplate.opsForZSet() | ZSetOperations | 操作 SortedSet 类型数据 |

| redisTemplate | ——— | 通用的命令 |

①引入依赖,redis 启动的坐标和连接池依赖

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-data-redis</artifactId>

</dependency>

<dependency>

<groupId>org.apache.commons</groupId>

<artifactId>commons-pool2</artifactId>

</dependency>

②redis 相关配置文件

spring:

redis:

host: 192.168.160.44

port: 6379

lettuce:

pool:

max-active: 10

max-idle: 10

min-idle: 1

time-between-eviction-runs: 10s

③注入 RedisTemplate

@Autowired // 也可以用 @Resource JSR 的标准注解,不过 @Resource 默认安装名称进行注入的

RedisTemplate redisTemplate;

④测试

@SpringBootTest(classes = HmDianPingApplication.class)

@SuppressWarnings("all")

@RunWith(SpringRunner.class) // JUnit4 需要加这句

public class RedisTemplateTest {

@Autowired

RedisTemplate redisTemplate;

@Test

public void test() {

// 插入一条string类型数据,如果采用默认的序列化机制的话,

// name 会被当成一个 Java 对象进行序列化,

// 默认采用 JDK 序列化,序列化为字节形式。

redisTemplate.opsForValue().set("name", "hello-world");

redisTemplate.opsForValue().setIfAbsent("name", "hello");

}

}

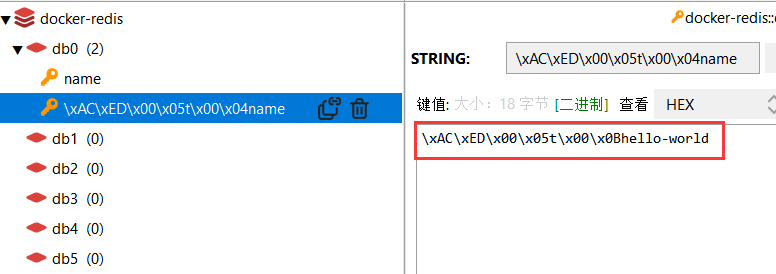

序列化方式

RedisTemplate 可以接收任意 Object 作为 key 和 value 写入 Redis,只不过写入前会把 Object 序列化为字节形式,默认是采用 JDK 序列化(RedisTemplate#defaultSerializer 默认初始化为 JDK 序列化),得到的结果是这样的

设置 RedisTemplate 的序列化方式,存取的时候都会自动转 JSON。

@Configuration

@SuppressWarnings("all")

public class RedisConfig {

@Bean

public RedisTemplate<String, Object> redisTemplate(RedisConnectionFactory connectionFactory) {

RedisTemplate<String, Object> template = new RedisTemplate<>();

template.setConnectionFactory(connectionFactory);

GenericJackson2JsonRedisSerializer jackson2JsonRedisSerializer = new GenericJackson2JsonRedisSerializer();

// 设置 key 的序列化方式

template.setKeySerializer(RedisSerializer.string());

template.setHashKeySerializer(RedisSerializer.string());

template.setHashValueSerializer(jackson2JsonRedisSerializer);

template.setValueSerializer(jackson2JsonRedisSerializer);

return template;

}

}

// redisTemplate.OpsForValue("name",new User(1,"123")); 会自动序列化成字符串

但是在存数据的时候会存入 “@class” 这个属性,表明是什么类型的数据,会占据一些内存空间,如果想节省内存空间就不能用 JSON 序列化器。

{

"@class":"com.ex.User",

"name":"Jack"

}

直接使用 Spring 提供的 StringRedisTemplate,先将 key 和 value 统一转成 String 字符串,再存储,这样就不会存储 “@class” 属性,节省内存空间。

@SpringBootTest

@RunWith(SpringRunner.class) // JUnit4 需要加这句

public class RedisTemplateTest {

@Resource // Resource 按名字注入,变量的名称要为 stringRedisTemplate

private StringRedisTemplate stringRedisTemplate;

@GetMapping("/get")

public String get() throws JsonProcessingException {

// Spring 默认的 JSON 处理工具。

// 还是不用 fastjson,一堆 bug。

ObjectMapper objectMapper = new ObjectMapper();

String jack = objectMapper.writeValueAsString(new User("Jack"));

//

stringRedisTemplate.opsForValue().set("user:1000", jack);

String s = stringRedisTemplate.opsForValue().get("user:1000");

User user = objectMapper.readValue(s, User.class);

return user.toString();

}

}

// ====================== user ======================

public class User {

public String name;

public User(String name) {

this.name = name;

}

@Override

public String toString() {

return "User{" + "name='" + name + '\'' + '}';

}

}

踩坑,在使用 JSON 转换工具时,需要为非 public 字段设置 set/get 方法,不然会报错。

com.fasterxml.jackson.databind.exc.InvalidDefinitionException:

No serializer found for class

Spring 默认提供的 StringRedisTemplate 类,它的 key 和 value 的序列化方式默认就是 String 方式。

public class StringRedisTemplate extends RedisTemplate<String, String> {

public StringRedisTemplate() {

setKeySerializer(RedisSerializer.string());

setValueSerializer(RedisSerializer.string());

setHashKeySerializer(RedisSerializer.string());

setHashValueSerializer(RedisSerializer.string());

}

public StringRedisTemplate(RedisConnectionFactory connectionFactory) {

this();

setConnectionFactory(connectionFactory);

afterPropertiesSet();

}

protected RedisConnection preProcessConnection(RedisConnection connection, boolean existingConnection) {

return new DefaultStringRedisConnection(connection);

}

}

序列化方案

方案一

- 自定义 RedisTemplate

- 修改 RedisTemplate 的序列化器为 GenericJacksonJsonRedisSerializer

- 不过会有额外的 @class 字段,有多余的空间消耗

方案二

- 使用 StringRedisTemplate

- 写入 Redis 时,手动把对象序列化为 JSON

- 读取 Redis 时,手动把读取到的 JSON 反序列化为对象

场景实战

黑马程序员Redis入门到实战教程,全面透析redis底层原理+redis分布式锁+企业解决方案+redis实战_哔哩哔哩_bilibili

内容概述

学会利用 Redis 解决下面这些场景的问题。

- 短信登录:Redis 共享 session 的应用;

- 商品缓存查询:缓存使用技巧;缓存雪崩、穿透等问题;

- 优惠券秒杀:Redis 计数器、Lua 脚本实现 Redis 分布式锁、Redis 的三种消息队列;

- 达人探店:基于 List 的点赞列表、基于 SortedSet 的点赞排行榜;

- 好友关注:基于 Set 集合的关注、取关、共同关注、消息推送等功能;

- 附件的商户:Redis 的 GenHash 的应用;

- 用户签到:Redis 的 BitMap 数据统计功能;

- UV 统计:Redis 的 HyperLogLog 的统计功能(一般大数据量下的话不会用这个,如果要求不高,又不想加其他中间件,可以考虑用它)

导入 SQL 文件 comments.sql,SQL 中包含如下的表

- tb_user:用户表,用户基本信息

- tb_user_info:用户详情表

- tb_shop:商户信息表

- tb_shop_type:商户类型表

- tb_blog:用户日记表(达人探店日记)

- tb_follow:用户关注表

- tb_voucher:优惠券表

- tb_voucher_order:优惠券的订单表

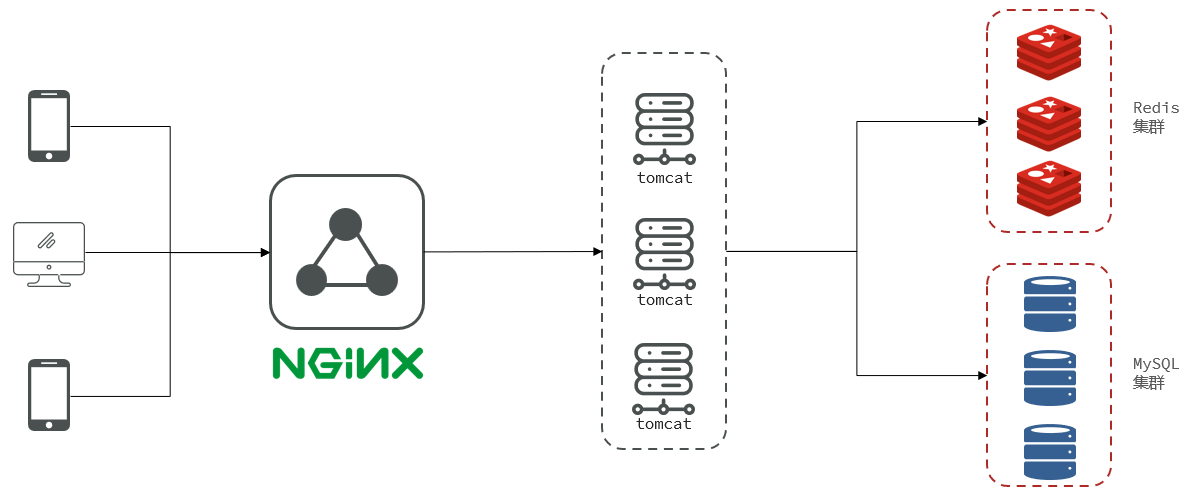

这是一个前后端分离的项目,用 ngnix 进行方向代理,访问 tomcat 集群。Redis 和 MySQL 也有相应的集群。

项目的访问路径是:http://localhost:8081/shop-type/list,如果可以看到数据则证明运行没有问题。

PS:需要修改 application.yaml 文件中的 MySQL、Redis 的地址信息。资料中提供了一个 nginx,复制到任意目录,在控制台输入 start nginx.exe 启动 nginx。然后访问 http://127.0.0.1:8080,即可看到页面。

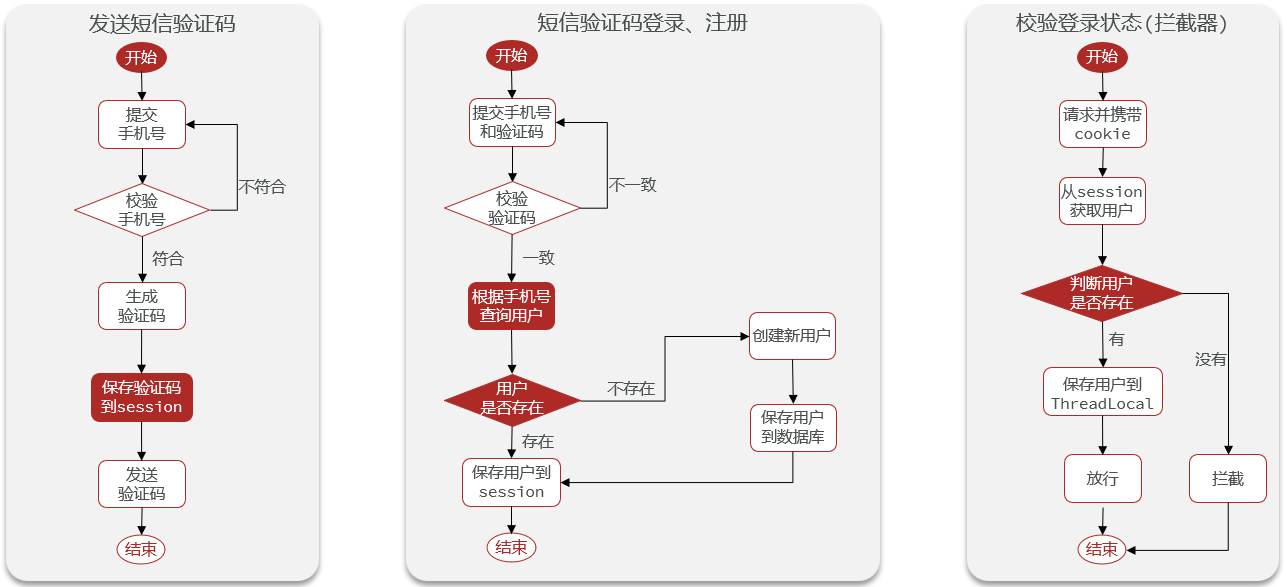

短信登录

短信登录功能的代码是一步一步迭代,改进的。仔细分析这个迭代改进的过程。

基于Session实现登录

具体的流程:发送验证码,回传验证码给用户,用户填写验证码登录时判断用户是否注册,注册了则直接登录,没注册则先注册然后再跳转到首页。

另一个需要考虑的是,我们需要在一些操作上判断用户是否登录。

- 一种方式是在特定的操作上加判断。

- 另一种方式是写一个过滤器,当访问特定的 url 路径时,判断是否登录。

显然,用过滤器的方式更好。我们可以把拦截器中获取到的用户信息传递到 Controller 里去,便于后期使用,且要保证使用时的线程安全,这里可以用 ThreadLocal 确保线程之间安全的使用自己线程中的数据。

说明:一条完整的 HTTP 请求对应一个线程,每一个进入 tomcat 的请求都是由一个独立的线程来处理的,如果单例对象在多线程下共享数据,如用同一个 ArrayList 存储,会出现并发安全问题;ThreadLocal 可以保证不同线程之间用的是自己的数据。

使用 ThreadLocal 保存用户信息的必要性:后面不少操作代码都需要获取到用户的信息,然后一个 HTTP 请求是在一个线程中完成的,因此这里先用 ThreadLocal 缓存用户信息,避免后面频繁的从 Session 中取出数据,后面改成 Redis 的话,可以避免频繁的从 Redis 中取出数据。而且,在最后请求处理完毕后,需要将用户从 ThreadLocal 中移除,拦截器的 afterCompletion 恰好是请求处理完毕之后执行

拦截器的两个方法

- preHandler 在业务处理器处理请求之前被调用。

- afterCompletion 完全处理请求之后被调用,可用于清理资源。

graph LR

subgraph 拦截器执行流程

拦截器--拦截所有请求-->用户是否登录--登录-->存入ThreadLocal, 存UserDTO中存在的字段信息而非User-->放行

用户是否登录--未登录-->提示未登录,无访问权限

end

graph LR

subgraph 发送验证码执行流程

发送短信验证码 /user/code-->调用 sendCode 方法,具体逻辑自己思考-->返回结果.

end

subgraph 登录执行流程

发送数据到 /user/login-->做好数据校验,判断好登录还是注册-->存储用户信息,返回结果.

end

集群的session共享问题

session 共享问题:多台 Tomcat 并不共享 session 存储空间,当请求切换到不同 Tomcat 服务时会出现无法找到 session 数据的问题。Tomcat 后面虽然提供了 session 拷贝的解决办法,但是太浪费内存空间了,而且数据拷贝是有延迟的。

session 的替代方案应该满足

- 数据共享

- 内存存储

- key、value 结构

- —> Redis

这里,可以使用 Redis 充当缓存,解决 Session 共享问题。也可以采用 JWT 作为解决方案。

采用 JWT 的话,用户登录后返回给前端 JWT,每次访问页面时携带 JWT,后端解析 JWT 获取用户信息,如果可以正常获取到用户信息说明用户已经登录了。Spring Boot2 系列教程(三十七)Spring Security 整合 JWT - 腾讯云开发者社区-腾讯云 (tencent.com)

采用 Redis 的话,用户登陆后以随机 token 为 key 将用户信息存入 Redis,后面前端访问后端时,携带 token,后端依据 token 从 Redis 中查询数据判断用户是否登录。

如果是 Redis+JWT 的组合就有些不三不四的。如非必要,二者选其一即可。

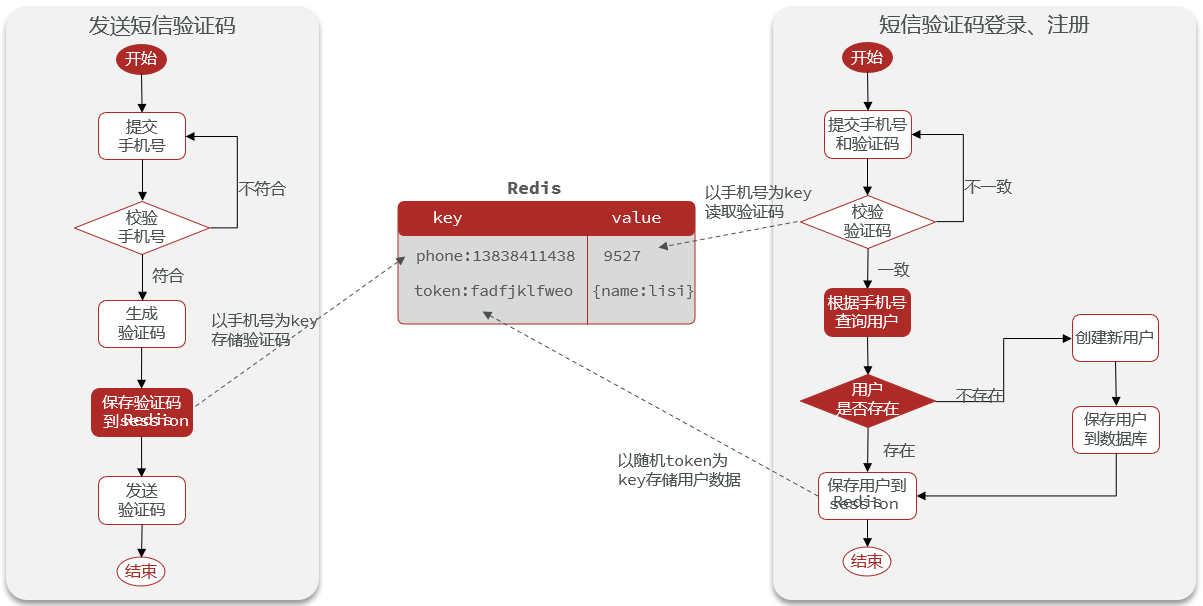

基于Redis实现共享session登录

创建 session 时会自动创建 session id,写到用户浏览器的 cookie 中,每发一次请求就会带着 cookie(session id),这样就可以根据 session id 找到 session,从 session 中取数据。而 session id 客户端自己会维护好。使用 Redis 替代 session 的话,也需要我们自己从 Redis 中查询出是否有该用户的信息(成功登录),需要让客户端维护一个 Redis 的 key 用于查找数据。

存入 Redis 的话需要思考用什么数据类型来保存,用什么作为 key。

- 数据类型可以选择 String 或 Hash。对比 String,Hash 可以方便的存取/修改部分字段,此处选择 Hash。

- key 的话需要保证唯一性,可以使用电话号码作为 key,但是这样不太好,因为前端要存储这个 key,用手机号的话不安全(如数据泄漏),建议使用一个随机字符串,且字符串的长度不要超过 44 字节,因为 Redis 中的 String 类型,当 key 不超过 44 字节时用的是 embstr 更节省内存。

前端 token 的格式是 authorization=xxx ,后端可以通过获取 authorization 字段的信息得到 token。

graph LR

subgraph 发送验证

验证码数据存入 Redis 并设置有效期-->key:LOGIN_CODE_KEY+phone

end

graph LR

subgraph 登录

Redis 中获取验证码-->从数据库中查询用户

从数据库中查询用户-->|存在|用户信息转 Hash 存入 Redis-->key 的设计:随机字符串

从数据库中查询用户-->|不存在|返回错误信息,提示用户不存在

end

// 用户登录 controller

public Result login(){

// 用户信息转 Hash,可以用 hutool 这个工具类

// 将 UserDTO 转为 Hash 存储

String token = UUID.randomUUID().toString(true);

UserDTO userDTO= BeanUtil.copyProperties(user, UserDTO.class);

// 对象转 map 时要确保值都是 string 的。

Map<String, Object> userMap = BeanUtil.beanToMap(user, new HashMap<>(),

CopyOptions.create().

setIgnoreNullValue(true).

setFieldValueEditor((key, value) -> value.toString()));

// Map<Sring, Object> userMap = BeanUtil.beanToMap(userDTO);

String loginKey = "login:token:"+token; // 重构到 RedisConstants 中

stringRedisTemplate.opsForHash().putAll(loginKey, userMap);

// 设置时间的有效期

stringRedisTemplate.expire(loginKey, 30,TimeUnit.MINUTES);

return Result.ok(token);

}

注意,拦截器类是我们手动 new 出来放到 IOC 里面的,所以拦截器里注入 StringRedisTemplate 需要用构造函数手动给对象赋值。然后添加自定义的拦截器又是在 Configurate 类中做的, StringRedisTemplate 可以通过依赖注入实例化。

public class LoginInterceptor implements HandlerInterceptor{

private StringRedisTemplate stringRedisTemplate;

public LoginInterceptor(StringRedisTemplate stringRedisTemplate){

this.stringRedisTemplate = stringRedisTemplate;

}

public boolean preHandle(xxx){

// some code...

// map 转对象

UserDTO userDTO = BeanUtil.fillBeanWithMap(userMap, new UserDTO(), false);

// some code...

}

}

@Configuration

public class MvcConfig implements WebMvcConfigurer{

@Autowired

private StringRedisTemplate stringRedisTemplate;

public void addInterceptors(InterceptorRegistry registry){

registry.addInterceptor(new LoginInterceptor()).excludePathPatterns(xxx);

}

}

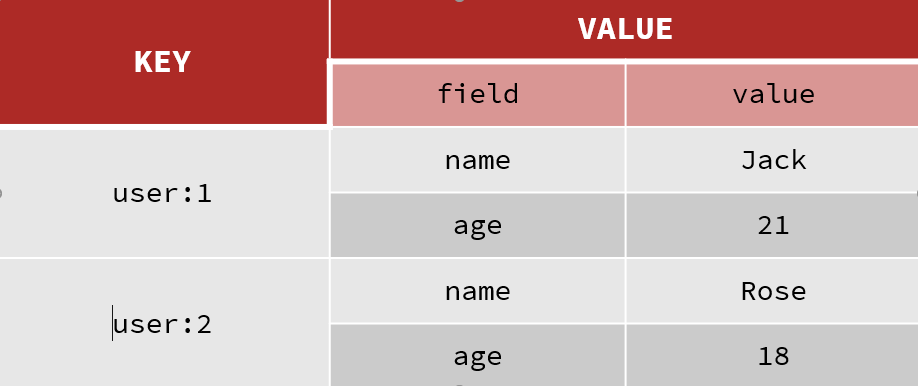

为什么选择用 Hash 存储用户数据而非 String?

保存登录的用户信息,可以用 String 结构,以 JSON 字符串来保存,比较直观。

| key | value |

|---|---|

| shop:user:1 | {name: “Jack”, age: 21} |

| shop:user:2 | {name: “Pose”, age: 18} |

哈希结构可以将对象中的每个字段独立存储,可以针对单个字段做 CRUD,并且内存占用更少

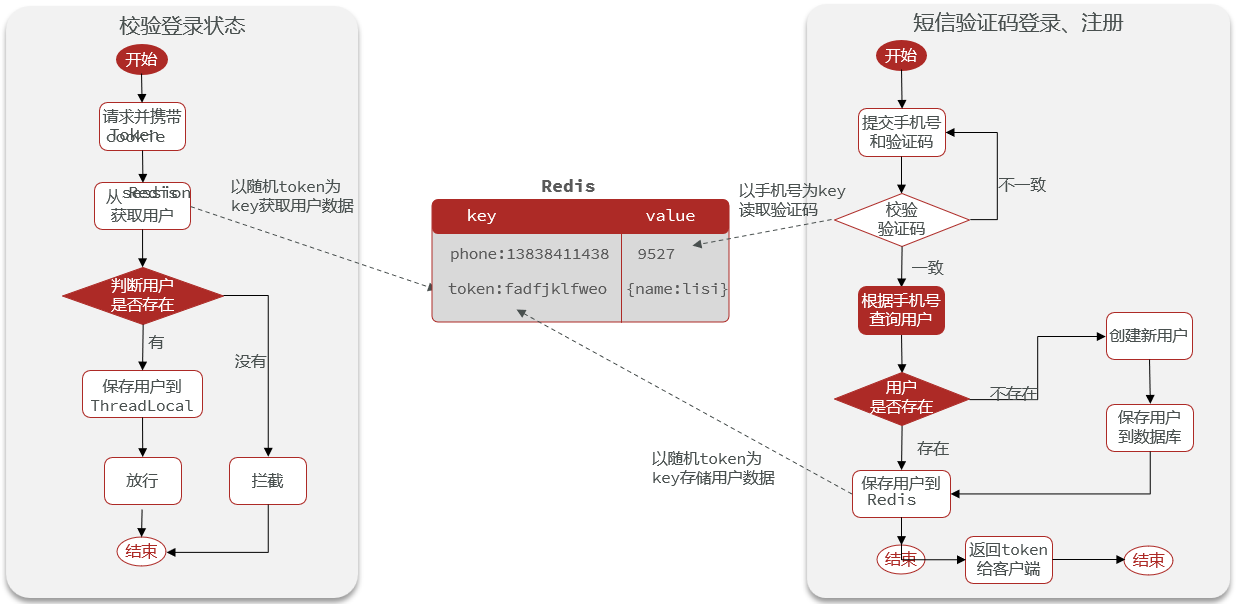

为什么要用 ThreadLocal 暂存用户信息?

用户每次操作界面时,都需要重新计算用户 token 在 Redis 中的有效期。在拦截器中每次从 Redis 中获取用户数据,如果存在,则重新设置有效期,然后存入 ThreadLocal。后面的操作如果还要用到用户信息,就直接从 ThreadLocal 中取,无需再次请求 Redis(一个用户的请求可能涉及若干操作,而这些若干操作都是在一个线程中完成的,如果这若干操作中都需要用到用户信息,此时可以直接从 ThreadLocal 中取,无需多次访问 Redis,减小了网络开销,内存消耗也不大,用户请求结束后就会从 ThreadLocal 中移除数据)。

总结

Redis 代替 session 需要考虑的问题

- 选择合适的数据结构

- 选择合适的 key

- 选择合适的存储粒度

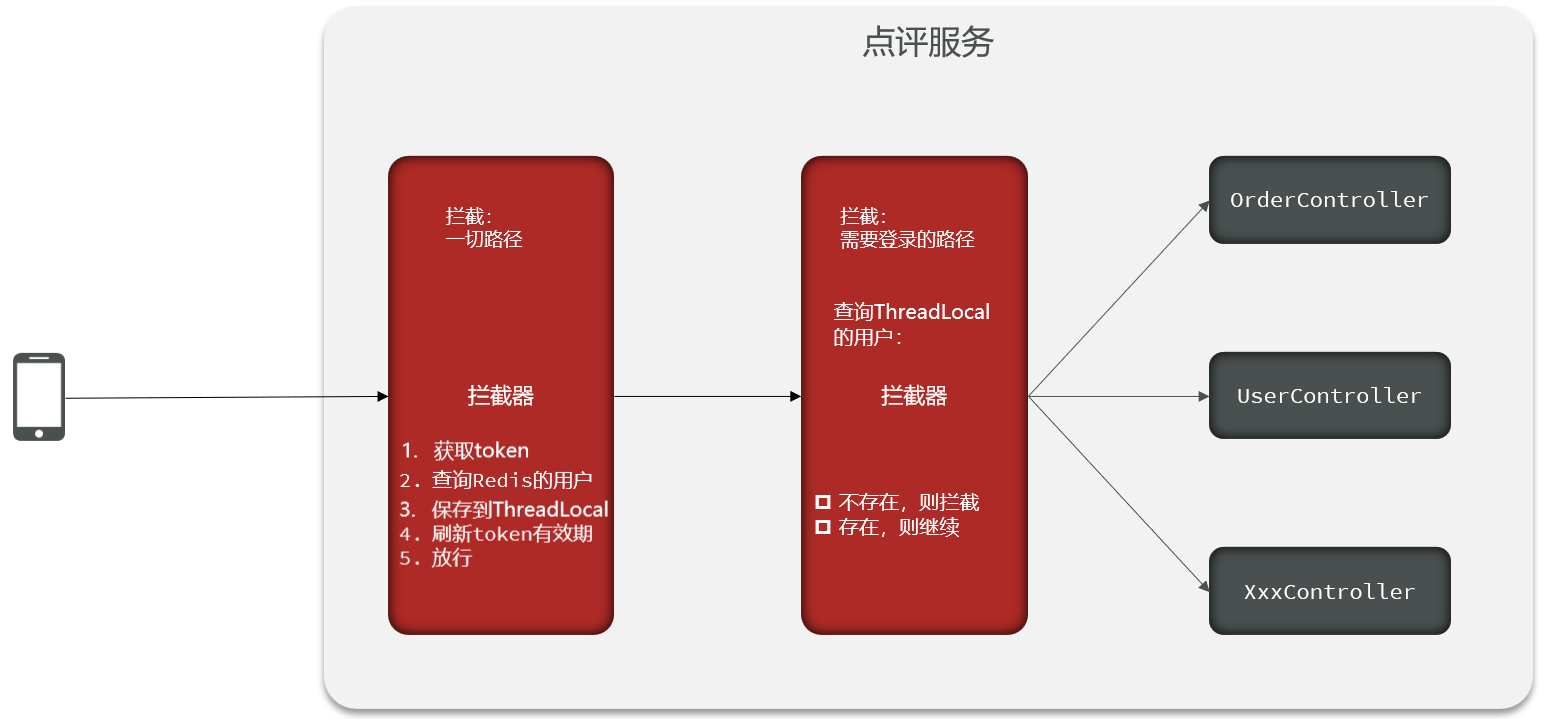

登录拦截器的优化,先前的拦截器拦截的只是需要做登录校验的路径,有些路径不需要检验但是也需要刷新 token,所有拦截器部分需要做一个优化。

- 设置多个拦截器,一个拦截一切路径,并在该拦截器中做 token 的刷新,将用户信息存入 ThreadLocal,放行请求。

- 一个只拦截登录请求,查询 ThreadLocal 是否有用户,不存在则拦截,存在则继续。

拦截器的执行顺序有个先后关系,可以通过 Order 来设置。Order 的值越小,执行计划等级越高。

// 负责判断是否登录

public class LoginInterceptor implements HandlerInterceptor{

public boolean preHandle(xxx){

// some code...

// map 转 对象

UserDTO userDTO = BeanUtil.fillBeanWithMap(userMap, new UserDTO(), false);

// some code...

}

}

// 负责刷新 token

public class RefreshTokenInterceptor implements HandlerInterceptor{

private StringRedisTemplate stringRedisTemplate;

public RefreshTokenInterceptor(StringRedisTemplate stringRedisTemplate){

this.stringRedisTemplate = stringRedisTemplate;

}

public boolean preHandle(xxx){

// some code...

// map 转 对象

UserDTO userDTO = BeanUtil.fillBeanWithMap(userMap, new UserDTO(), false);

// some code...

}

}

@Configuration

public class MvcConfig implements WebMvcConfigurer{

@Autowired

private StringRedisTemplate stringRedisTemplate;

public void addInterceptors(InterceptorRegistry registry){

registry.addInterceptor(new RefreshTokenInterceptor(stringRedisTemplate))

.excludePathPatterns(xxx).order(0); // 数字越小,越先执行。

}

}

商品查询缓存

- 添加 Redis 缓存

- 缓存更新策略

- 缓存穿透

- 缓存雪崩

- 缓存击穿

- 缓存工具封装

缓存介绍

缓存是数据交换的缓冲区(称作 Cache [ kæʃ ] ),是存贮数据的临时地方,一般读写性能较高。

graph LR

浏览器缓存-->应用层缓存-->数据库缓存-->CPU缓存

| 缓存的作用 | 缓存的成本 |

|---|---|

| 降低后端负载 | 数据一致性成本 |

| 提高读写效率,降低响应时间 | 代码维护成本 |

| - | 运维成本 |

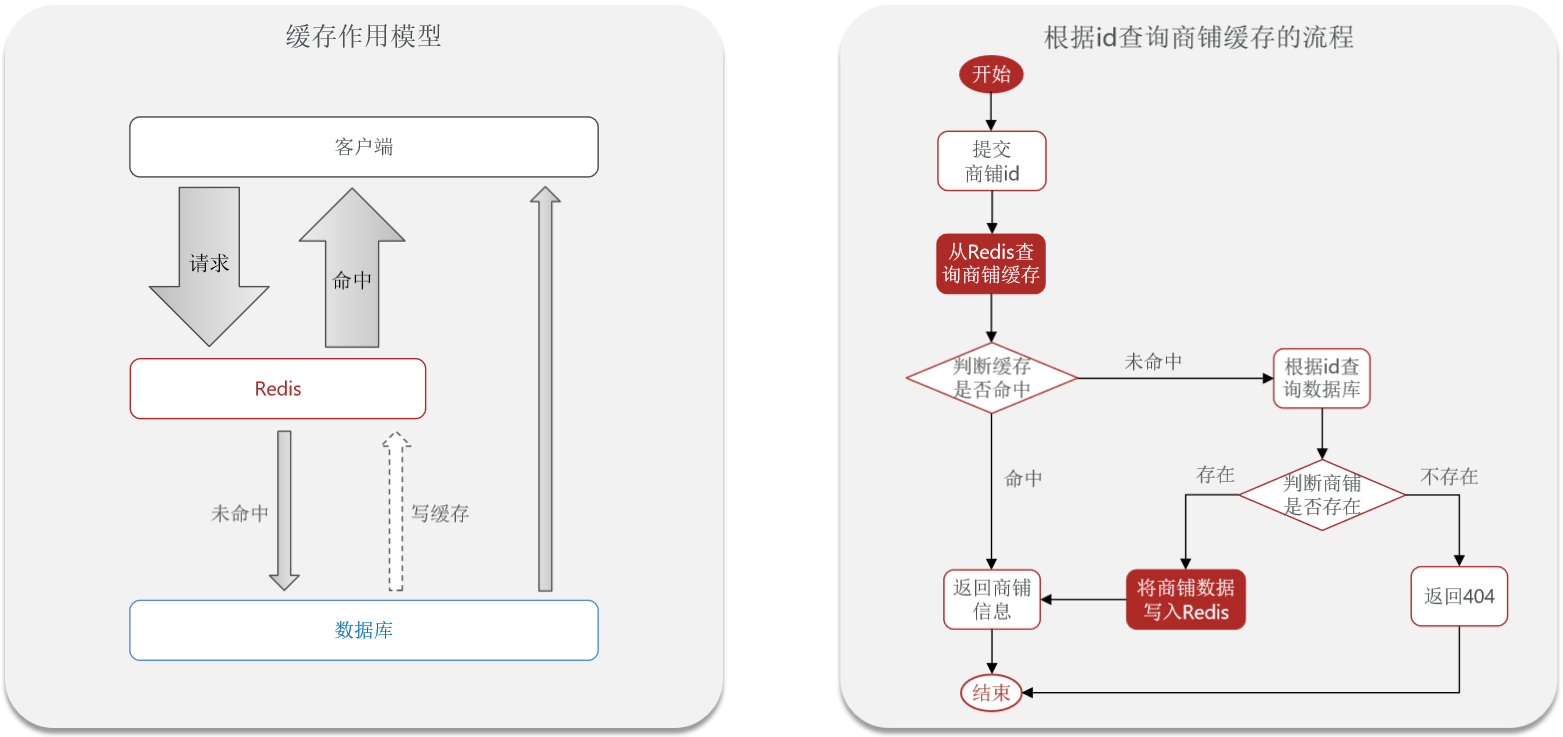

添加Redis缓存

查询商铺缓存

key 设计为 cache:shop:+id,因为店铺的信息都是需要用到的,因此这里用 String。

@RestController

@RequestMapping("/shop")

public class ShopController{

// some code

@GetMapping("/{id}")

public Result queryShopById(@PathVariable("id") Long id) {

return Result.ok(shopService.getById(id));

}

}

@Service

public class ShopServiceImpl extends ServiceImpl<ShopMapper, Shop> implements IShopService {

@Resource

public IShopService shopService;

public Result queryShopById(Long id) {

// 1. 从 Redis 查询商铺缓存

// 2. 判断是否存在

// 3. 存在,直接返回

JSONUtil.toBean(xxx,Shop.class);

// 4. 不存在,根据 id 查询数据库

// 5. 不存在,返回错误

// 6. 存在,写入 Redis

// 7. 返回

}

}

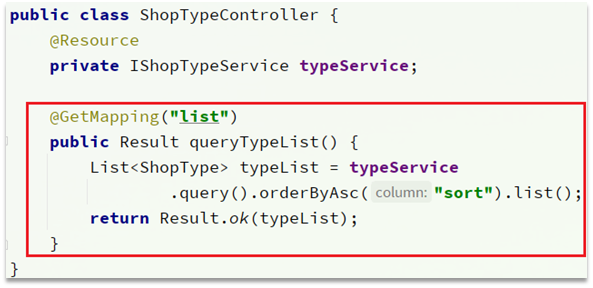

修改 ShopTypeController 中的 queryTypeList 方法,添加查询缓存

key 和 value 的选取,value 可以用 String,也可以用 List。

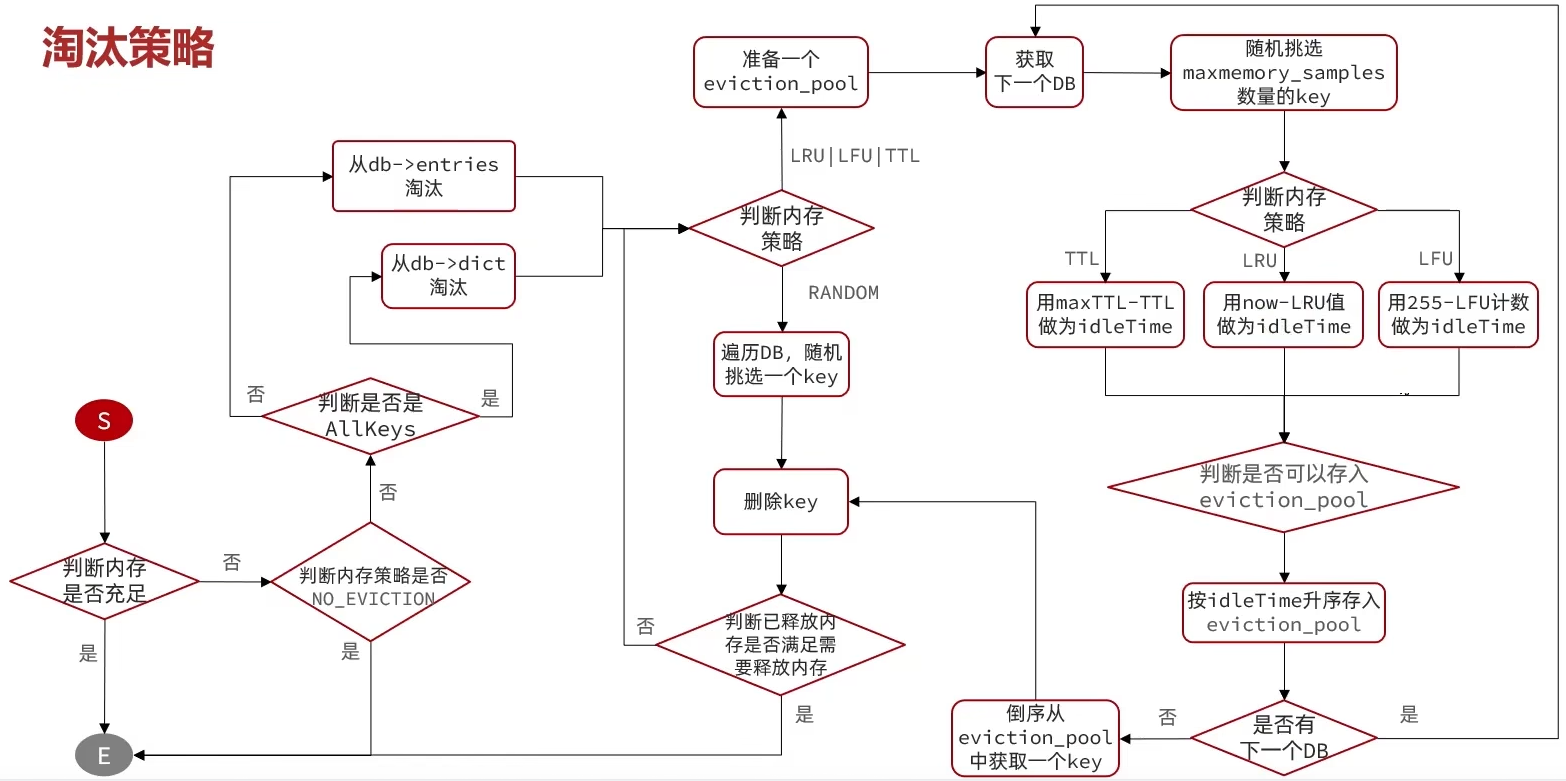

缓存更新策略

| - | 内存淘汰 | 超时剔除 | 主动更新 |

|---|---|---|---|

| 说明 | 不用自己维护,利用 Redis 的内存淘汰机制,当内存不足时自动淘汰部分数据。下次查询时更新缓存。 | 给缓存数据添加 TTL 时间,到期后自动删除缓存。下次查询时更新缓存。 | 编写业务逻辑,在修改数据库的同时,更新缓存。 |

| 一致性 | 差 | 一般 | 好 |

| 维护成本 | 无 | 低 | 高 |

业务场景

- 低一致性需求:使用内存淘汰机制。例如店铺类型的查询缓存。

- 高一致性需求:主动更新,并以超时剔除作为兜底方案。例如店铺详情查询的缓存。

主动更新策略

- Cache Aside Pattern:由缓存的调用者,在更新数据库的同时更新缓存。【推荐这个】

- Read/Write Through Pattern:缓存与数据库整合为一个服务,由服务来维护一致性。调用者调用该服务,无需关心缓存一致性问题。

- Write Behind Caching Pattern:调用者只操作缓存,由其他线程异步的将缓存数据持久化到数据库,保证最终一致性 (一致性很难保存,缓存宕机的话数据就永久丢失了,一致性和可靠性都不太好)。

操作缓存和数据库时有三个问题需要考虑

| 删除缓存还是更新缓存? | 如何保证缓存与数据库的操作的同时成功或失败? | 先操作缓存还是先操作数据库? |

|---|---|---|

| 更新缓存:每次更新数据库都更新缓存,无效写操作较多 | 单体系统,将缓存与数据库操作放在一个事务 | 先删除缓存,再操作数据库❌ |

| 删除缓存:更新数据库时让缓存失效,查询时再更新缓存 | 分布式系统,利用 TCC 等分布式事务方案 | 先操作数据库,再删除缓存✔️ |

缓存更新策略的最佳实践方案

1️⃣低一致性需求:使用 Redis 自带的内存淘汰机制。

2️⃣高一致性需求:主动更新,并以超时剔除作为兜底方案。

| 读操作 | 写操作 |

|---|---|

| 缓存命中则直接返回 | 先写数据库,然后再删除缓存 |

| 缓存未命中则查询数据库,并写入缓存,设定超时时间 | 要确保数据库与缓存操作的原子性 |

给查询商铺的缓存添加超时剔除和主动更新的策略

修改 ShopController 中的业务逻辑,满足下面的需求:

①根据 id 查询店铺时,如果缓存未命中,则查询数据库,将数据库结果写入缓存,并设置超时时间

②根据 id 修改店铺时,先修改数据库,再删除缓存,这个操作需要加入事务,确保操作的一致性(update 方法上加 @Transactional)

思考下,分布式系统下如何保证事务的一致性?TCC 分布式事务框架。

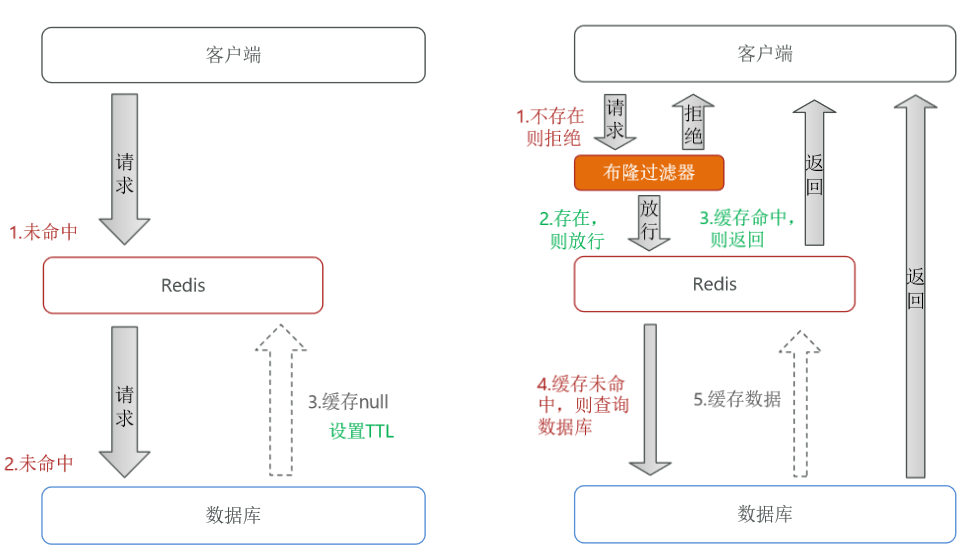

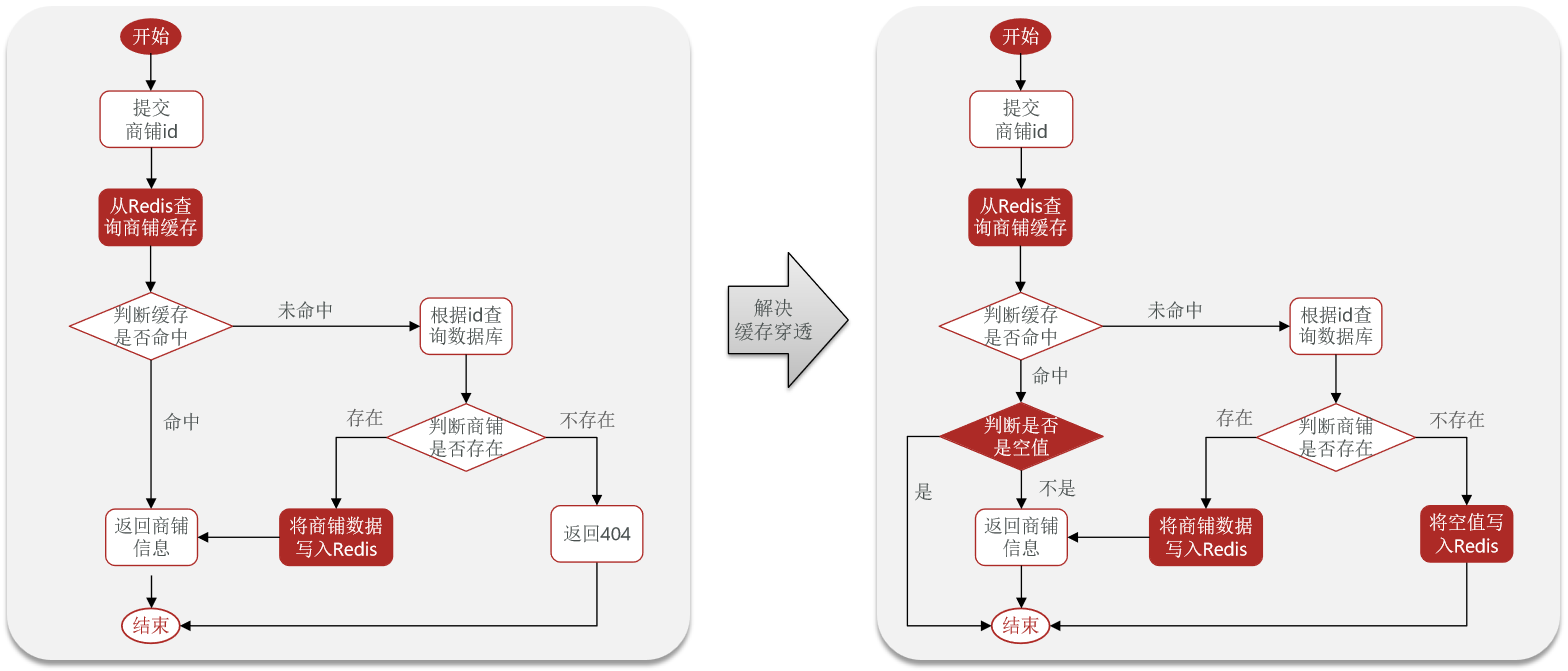

缓存穿透

缓存穿透是指客户端请求的数据在缓存中和数据库中都不存在,这样缓存永远不会生效,这些请求都会打到数据库。

常见的解决方案有两种

| 解决方案 | 优点 | 缺点 |

|---|---|---|

| 缓存空对象 | 优点:实现简单,维护方便 | 缺点:额外的内存消耗;可能造成短期的不一致 |

| 布隆过滤 | 优点:内存占用较少,没有多余 key | 缺点:实现复杂;存在误判可能 |

缓存穿透产生的原因是什么?

用户请求的数据在缓存中和数据库中都不存在,不断发起这样的请求,给数据库带来巨大压力

缓存穿透的解决方案有哪些?

- 缓存 null 值:会带来额外的内存存储压力和短暂的不一致性。

- 布隆过滤:基于布隆算法,准确性无法保证,实现复杂。

- 增强 id 的复杂度,避免被猜测 id 规律

- 做好数据的基础格式校验

- 加强用户权限校验

- 做好热点参数的限流

缓存雪崩

缓存雪崩是指在同一时段大量的缓存 key 同时失效或者 Redis 服务宕机,导致大量请求到达数据库,带来巨大压力。

常见的解决方案有:

1️⃣给不同的 Key 的 TTL 添加随机值,比如原先设置的 20,那么我们再加一个随机的 1~10 的值

2️⃣利用 Redis 集群提高服务的可用性(很严重),尽可能的避免宕机。宕机的话,可以用 redis 的哨兵机制,监控服务。搭建 Redis 服务形成主从,如果有机器宕机(如主宕机了,会随机从一个从机器里选一个替代主)

3️⃣给缓存业务添加降级限流策略

4️⃣给业务添加多级缓存

缓存击穿

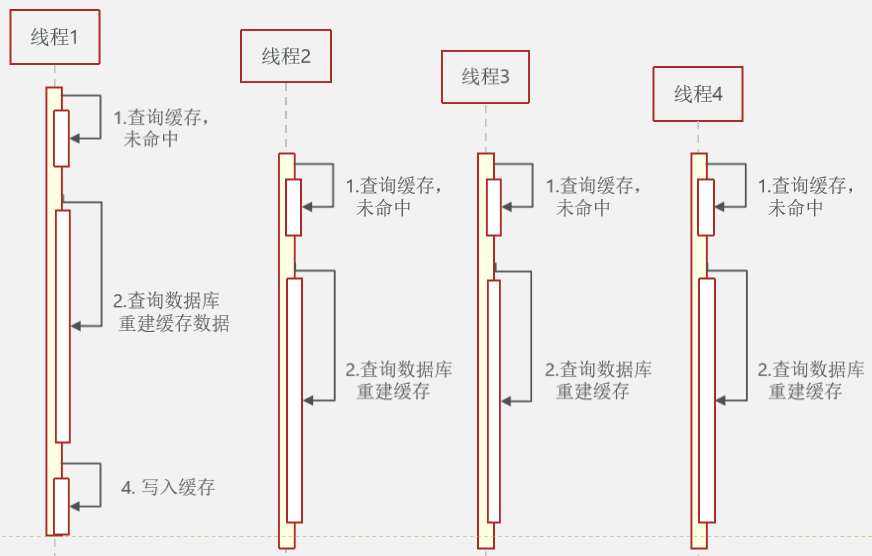

缓存击穿问题也叫热点 Key 问题(少部分 key 失效),就是一个被高并发访问并且缓存重建业务较复杂的 key 突然失效了,无数的请求访问会在瞬间给数据库带来巨大的冲击。确保重建缓存的时候只有一个访问可以重建就行,其他访问获取旧的数据或等待缓存重建成功然后再从缓存中查询数据。

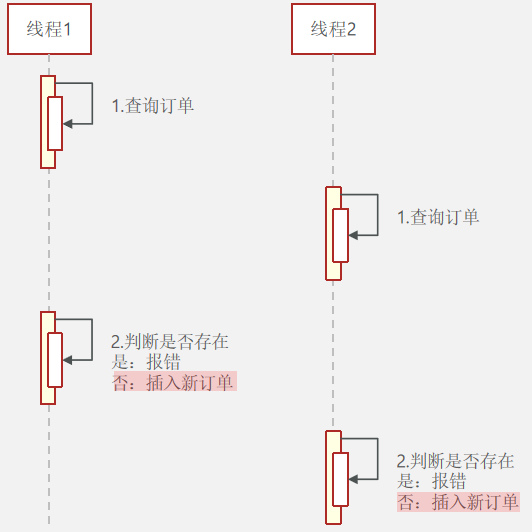

假定有多个线程(1,2,3,4)查询到了一个失效的缓存,线程 1 发现缓存失效了,开始走重建缓存的流程。此时缓存还未重建完毕,线程 2,3,4 也发现缓存失效了,也走了重建缓存的流程(没有必要)。

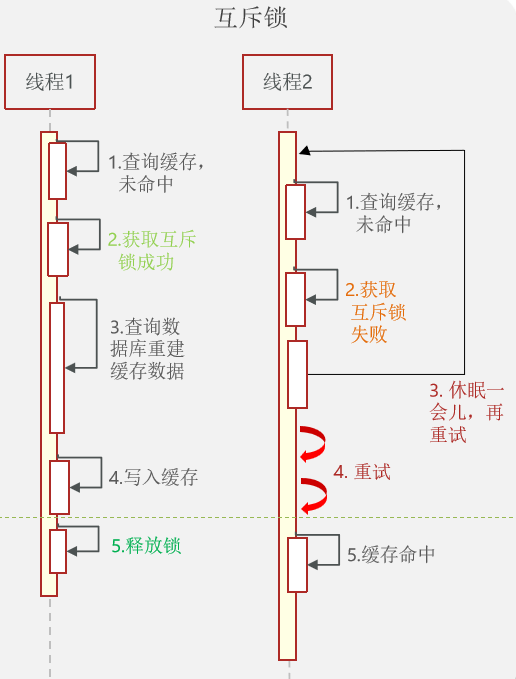

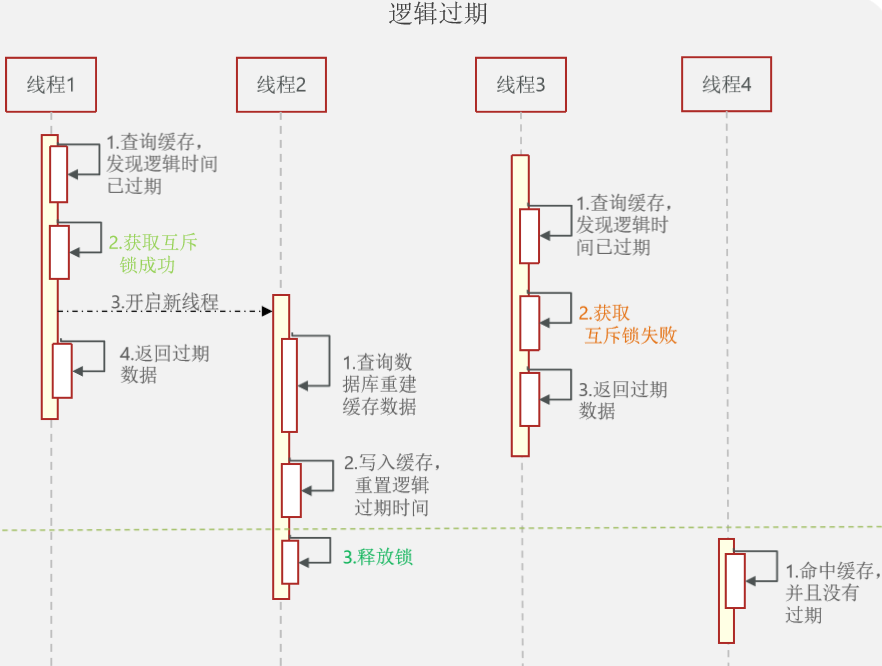

常见的解决方案有:互斥锁和逻辑过期。利用互斥锁,让其中一个线程重建缓存即了。

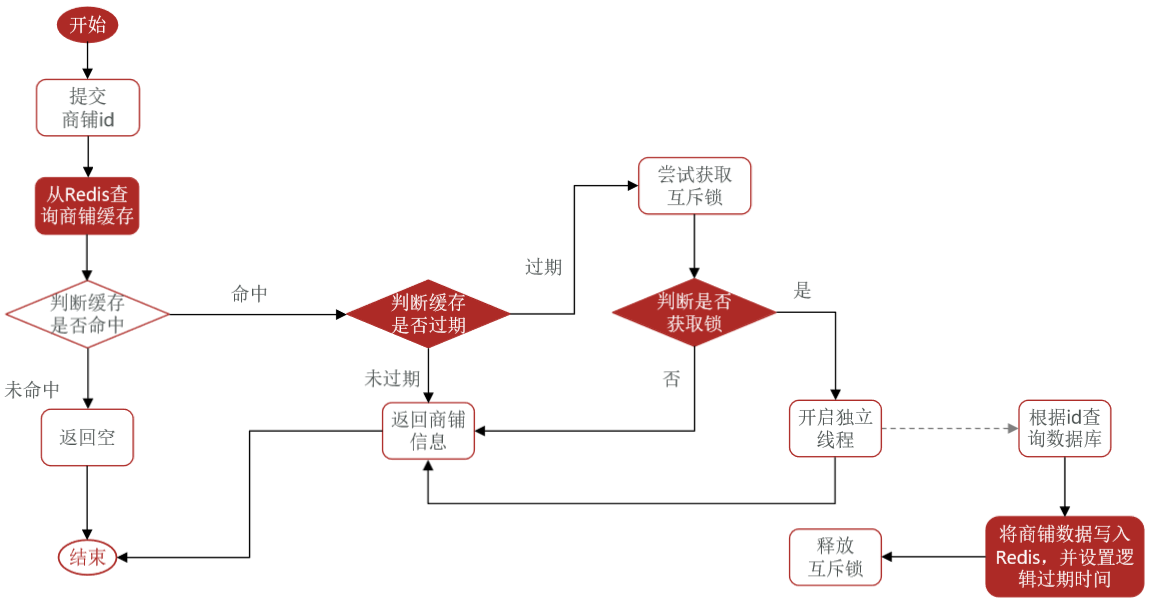

互斥锁需要互相等待,1000 个线程来了,一个负责重建,其他的只能等待。如果重建时间长的话,系统性能会很差。可以为数据设置一个逻辑过期(就是数据永不过期,设置一个逻辑过期时间),解决等待的问题。为了避免多个线程重建缓存,此处也需要获取锁,只让一个线程可以重建缓存。

graph LR

subgraph 逻辑过期

重建缓存-->获取互斥锁

获取互斥锁-->|成功|开启新线程重建缓存

获取互斥锁-->|失败|直接返回过期数据

end

| 解决方案 | 优点 | 缺点 |

|---|---|---|

| 互斥锁 | 没有额外的内存消耗 保证一致性 实现简单 |

线程需要等待,性能受影响 可能有死锁风险 |

| 逻辑过期 | 线程无需等待,性能较好 | 不保证一致性 有额外的内存消耗 实现复杂 |

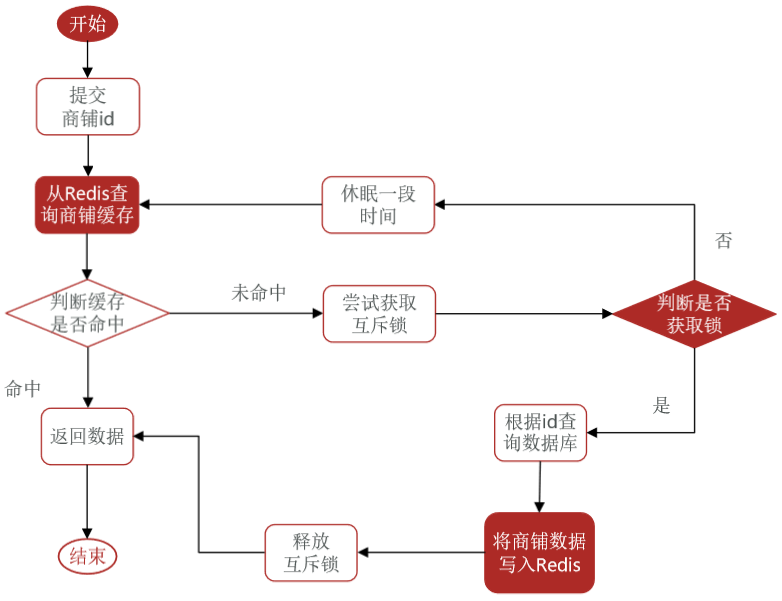

基于互斥锁解决缓存击穿问题

需求:修改根据 id 查询商铺的业务,基于互斥锁(redis 的 setnx)方式来解决缓存击穿问题。如果只是一个单机的系统,可以直接使用语言内置的锁来解决缓存击穿。而 Redis String 类型的 setnx 可以实现这种类似的功能。setnx 只有在 key 不存在是才可以写(返回 1),key 存在的话无法写(返回 -1)。一般都会为 setnx 设置一个有效期。

private boolean tryLock(String key){

Boolean flag = stringRedisTemplate

.opsForValue()

// 设置有效期避免死锁。如果重建失败,其他线程拿到锁发现没有重建

// 成功会继续重建缓存

.setIfAbsent(key,"1",10,TimeUnit.SECONDS);

return flag == null?false:true;

}

private void unlock(String key){

stringRedisTemplate.delete(key);

}

获取锁成功后,应该再次检测 redis 缓存是否存在,做 doubleCheck,如果存在则无需重建缓存。

public ShopQueryWithMutex(Long id){

String key = CACHE_SHOP_KEY+id;

String shopJson = stringRedisTemplate.opsForValue().get(key);

// 判断是否存在

if(StrUtil.isNotBlank(shopJson)){

return JSONUtil.toBean(shopJson, Shop.class)

}

// 判断命中是否是空值

if(shopJson !=null){

// 返回一个错误信息

return null;

}

// some code

// 不存在,查询数据库

Shop shop = getById(id);

// 不存在,返回错误,写入空值

if(shop == null){

stringRedisTemplate.opsForValue().set(key,null);

return null;

}

}

使用 JMeter 进行高并发压力测试。

基于逻辑过期方式解决缓存击穿问题

需求:修改根据 id 查询商铺的业务,基于逻辑过期方式来解决缓存击穿问题。

原先的 POJO 对象(Shop)没有逻辑过期这个字段,但是我们又不能破坏 Shop 类的结构,此时我们可以创建一个 ShopDTO,专门用来数据传输的,在这个类里加上逻辑过期字段。还有一种更通用的方式,定义一个 RedisData,存储传输的对象和逻辑过期时间。

public class RedisData{

private LocalDateTime expireTime;

private Object data;

}

缓存工具封装

基于 StringRedisTemplate 封装一个缓存工具类,满足下列需求:

1️⃣将任意 Java 对象序列化为 json 并存储在 string 类型的 key 中,并且可以设置 TTL 过期时间(针对普通 key 的)

2️⃣根据指定的 key 查询缓存,并反序列化为指定类型,利用缓存空值的方式解决缓存穿透问题(针对普通 key 的)

3️⃣将任意 Java 对象序列化为 json 并存储在 string 类型的 key 中,并且可以设置逻辑过期时间,用于处理缓存击穿问题(针对热点 key 的)

4️⃣根据指定的 key 查询缓存,并反序列化为指定类型,需要利用逻辑过期解决缓存击穿问题(针对热点 key 的)

在更新缓存的时候,不知道数据库查询的具体操作,采用 lambda 由用户传入具体的操作。

@Slf4j

@Component

/*

* 缓存雪崩,设置过期时间时加上一个随机数,避免大量 key 同时过期

* 缓存穿透,查询的数据 Redis 和数据库中都没有,可以通过缓存 null 值来解决。(占用内存,数据不一致)

* 缓存击穿,热点 key 失效。大量用户查询数据,导致大量用户尝试重建缓存,可以采用互斥锁的方式重建缓存;也可以采用逻辑过期的方式。

*/

public class CacheClient{

private final StringRedisTemplate stringRedisTemplate;

public CacheClient(StringRedisTemplate stringRedisTemplate){

this.stringRedisTemplate = stringRedisTemplate;

}

public void set(String key, Object value, Long time, TimeUnit unit){

// cn.hutool.json 工具类中的方法 toJsoonStr

stringRedisTemplate.opsForValue().set(key, JSONUtil.toJsonStr(value), time, unit);

}

// 设置逻辑过期时间

public void setWithLogicalExpore(String key, Object value, Long time, TimeUnit unit){

// cn.hutool.json 工具类中的方法 toJsonStr

RedisData redisData = new RedisData(value, LocalDateTime.now().plusSeonds(unit.toSeconds(time)));

stringRedisTemplate.opsForValue().set(key, JSONUtil.toJsonStr(redisData));

}

// 缓存穿透,通过缓存空值来解决。需要自己判断那些数据会发生缓存穿透问题,然后查询数据的时候使用该方法。(比如,常见的存入 redis 的数据都可以使用这个来进行查询)

public <R, ID> R queryWithPassThrough(String keyPrefix, ID id, Class<R> type,

Function<ID,R> dbFallback, Long Time, TimeUnit unit){

String key = keyPrefix + id;

// 1. 查询缓存

String json = stringRedisTemplate.opsForValue().get(key);

// 2. 判断是否存在,存在直接返回

if(StrUtil.isNotBlank(json)){

// 3.数据不为空,说明存在,直接返回

return JSONUtil.toBean(json, type);

}

// 4. 如果命中的是空值'',说明发生了缓存穿透,直接返回错误信息(如果发现数据库中没有会向 redis 中存入一个空值)

if(json != null){

return null;

}

// 5. 如果数据还未缓存到 Redis, 则查询数据库。

R r = dbFallback.apply(id);

// 6. 不存在,发生错误,并向 Redis 中写入空值

if(r == null){

stringRedisTemplate.opsForValue().set(key, "", CACHE_NULL_TTL, TimeUnit.MINUTES);

return null;

}

// 7.存在,写入数据库

this.set(key, r, time, unit);

return r;

}

// 使用逻辑时间过期解决缓存击穿问题。对于根据业务预判成功热点数据,可以统一采用该方法进行数据的查询。

public <ID,R> R queryWithLogicalExpire(String keyPrefix, ID id, Class<R> type,

Function<ID, R> dbFallBack, Long time, TimeUnit unit){

String key = keyPrefix + id;

String json = stringRedisTemplate.opsForValue().get(key);

// 2. 判断是否存在,不存在直接返回

if(StrUtil.isBlank(json)){

// 3.不存在,直接返回

return null;

}

// 4.命中,把 json 反序列化为对象

RedisData redisData = JSONUtil.toBean(json, RedisData.class);

R r = JSONUtil.toBean((JSONObject) redisData.getData(), type);

LocalDateTime expireTime = redisData.getExpireTime();

// 5. 判断是否逻辑过期

if(expireTime.isAfter(LocalDateTime.now())){

// 未过期

return r;

}

// 过期,缓存重建

// 6. 获取互斥锁

String lockKey = LOCK_SHOP_KEY + id;

boolean getLock = tryLock(lockKey);

if(getLock){

// 成功拿到锁则开启线程重建缓存,这个缓存重建是异步的,所以返回的是 r 而非 r1.

CACHE_REBUILD_EXECUTOR.submit(()->{

try{

// 查询数据

R r1 = dbFallBack.apply(id);

// 写入 redis

this.setWithLogicalExpore(key, r1, time, unit);

}cache(Exception e){

throw new RuntimeException(e);

}finally{

unlock(lockKey);

}

});

}

return r;

}

}

优惠券秒杀

- 全局唯一 ID

- 实现优惠券秒杀下单

- 超卖问题

- 一人一单

- 分布式锁

- Redis 优化秒杀

- Redis 消息队列实现异步秒杀

全局唯一ID

问题

每个店铺都可以发布优惠券。当用户抢购时,就会生成订单并保存到 tb_voucher_order 这张表中,而订单表如果使用数据库自增 ID 就存在一些问题。

- id 的规律性太明显,被发现规律后可能会受到脚本的攻击。

- 受单表数据量的限制。后期表数据可能过大,单张表无法保持,需要多张表。如果多张表采用自增 id 的话,会出现同一个 id 存在于多个表中。无法保证 id 的唯一性。

全局 ID 生成器

全局 ID 生成器,是一种在分布式系统下用来生成全局唯一 ID 的工具,一般要满足下列特性。

- 唯一性,比如订单编号需要唯一;

- 高可用,要确保在任何时候使用它时都能生成正确的 ID;

- 高性能,在高并发情况下要能够快速生成大量 ID;

- 递增性,因为是要用它替代主键,所以要尽量确保递增,加快数据的插入和索引的更新(避免页分裂);

- 安全性。

为了增加 ID 的安全性,我们不直接使用 Redis 自增的数值,而是拼接一些其它信息。

graph

符号位 1bit

时间戳 31bit

序列化 32bit

ID 的组成部分

- 符号位:1bit,永远为 0;

- 时间戳:31bit,以秒为单位,可以使用 69 年;

- 序列号:32bit,秒内的计数器,支持每秒产生 $2^{32}$ 个不同 ID

A << COUNT_BIT | count。

全局唯一 ID 生成策略

- UUID,ID 不自增,数据插入会导致页分裂;

- Redis 自增,Redis 自增+拼接一些其他的数据,让数据没那么有规律;

- snowflake 算法;

- 数据库自增。

Redis 自增 ID 策略

- 每天一个 key,方便统计订单量

- ID 构造是时间戳 + 计数器

案例:生成全局唯一 ID

public class RedisIdWorker{

private static final int COUNT_BIT = 32;

public long nextId(String keyPrefix){

// 1.生成时间戳

LocalDateTime now = LocalDateTime.now();

long nowSecond = new.toEpochSecond(ZoneOffset.UTC);

long timestamp = nowSecond - BEGIN_TIMESTAMP;

// 2.生成序列号

// 2.1 获取当前日期,精确到天

String date = now.format(DateTimeFormatter.ofPattern("yyy:MM:dd"));

// 2.2 自增长(不会存在空指针的,如果key不存在会自动给你重建一个,然后+1返回1给你)

Long count = stringRedisTemplate.opsForValue().increment("icr:"+keyPrefix+":"+date);

// 拼接返回

// 符号位 时间戳 序列化

// 用位运算。timestamp 左移 32 位,然后在 | 上自增的位。count 的自增可以保证 id 的唯一性。

return (timestamp<<COUNT_BIT)|count

}

}

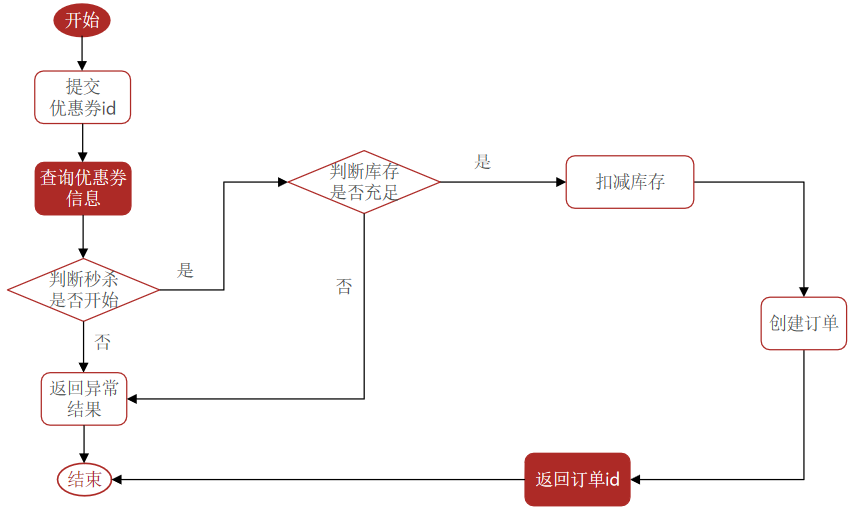

优惠券秒杀下单

每个店铺都可以发布优惠券,分为平价券和特价券。平价券可以任意购买,而特价券需要秒杀抢购:

- tb_voucher:优惠券的基本信息,优惠金额、使用规则等。

- tb_seckill_voucher:优惠券的库存、开始抢购时间,结束抢购时间。特价优惠券才需要填写这些信息。

VoucherController 中提供了一个接口用于添加秒杀优惠券:VoucherController#addSeckillVoucher

秒杀下单的接口

| - | 说明 |

|---|---|

| 请求方式 | POST |

| 请求路径 | /voucher-order/seckill/{id} |

| 请求参数 | id,优惠券 id |

| 返回值 | 订单 id |

下单时需要判断两点:

- 秒杀是否开始或结束,如果尚未开始或已经结束则无法下单

- 库存是否充足,不足则无法下单

注意:涉及到两张表的操作,因此需要加上事务。在添加事务的时候注意事务是否会失效。

超卖问题

问题

超卖问题是典型的多线程安全问题,针对这一问题的常见解决方案就是加锁。

| 类型 | 说明 |

|---|---|

| 乐观锁 | 认为线程安全问题不一定会发生,因此不加锁,只是在更新数据时去判断有没有其它线程对数据做了修改。如果没有修改则认为是安全的, 自己才更新数据。如果已经被其它线程修改说明发生了安全问题,此时可以重试或异常。 |

| 悲观锁 | 认为线程安全问题一定会发生,因此在操作数据之前先获取锁,确保线程串行执行。例如 Synchronized、Lock 都属于悲观锁 |

乐观锁

乐观锁的关键是判断之前查询得到的数据是否有被修改过,常见的方式有两种:版本号法和 CAS。

- 版本号法,加一个版本字段,先查下数据的库存和版本,修改时判断版本是否一致,不一致说明被改过,重新查询库存,修改库存。可以直接用库存作为版本号。直接判断版本号是否一致的话,商品卖出的成功率太低。

- CAS,CAS 是在版本号的基础上做了一些简化,版本号法是用版本标明数据有没有变化(需要维护版本),其实库存和版本做的事都是一样的,在查询的时候查出来,更新的时候判断下查询时的库存和更新时的库存是不是一样的即可。

- 还有一种更简便的方法,更新的时候判断下库存是否大于 0,大于 0 就可以减库存了。这样也不会有太多的失败操作和事务回滚。

- 有时候只能通过数据是否变化来判断是否可以卖出,这种时候为了提高并发度可以采用分段锁的思想。将数据分为多个段,让多个线程可以并发处理。

悲观锁

加重量级锁,如果觉得并发粒度不够,可以采用分段锁的思想。

| 方案 | 优点 | 缺点 |

|---|---|---|

| 悲观锁,添加同步锁,让线程串行执行 | 简单粗暴 | 性能一般 |

| 乐观锁,不加锁,在更新时判断是否有其它线程在修改 | 性能好 | 存在成功率低的问题 |

乐观锁解决超卖问题

# 修改下 sql 语句, 失败率会非常高

update voucherxxx set stock = stock-1 where voucher_id = k and stock = queryStock;

# 再次修改 sql 语句

update voucherxxx set stock = stock-1 where voucher_id = k and stock > 0;

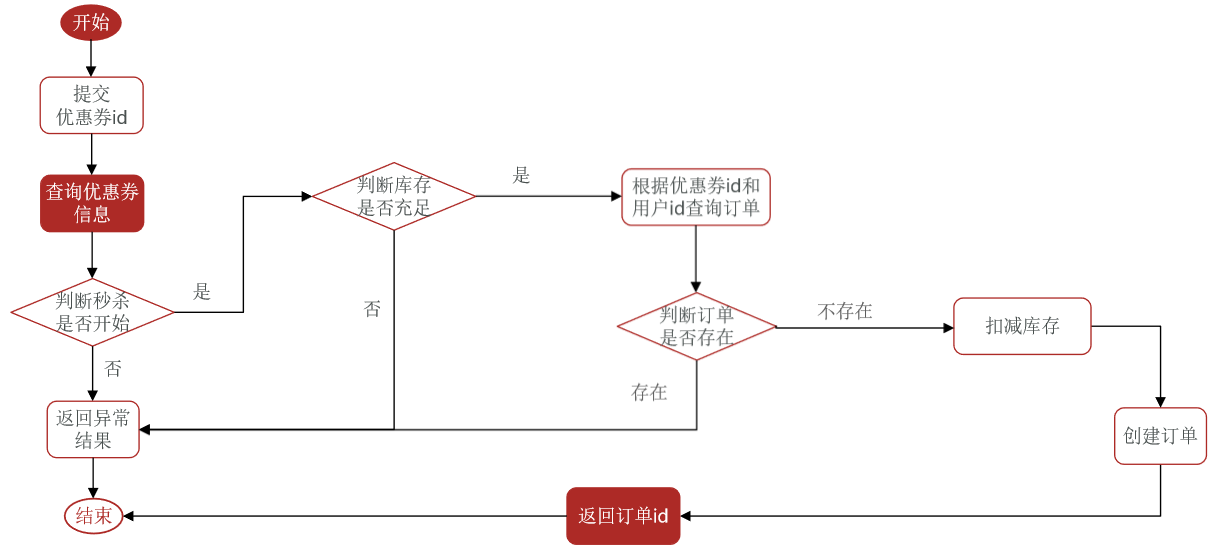

一人一单

问题

修改秒杀业务,要求同一个优惠券,一个用户只能下一单。可以直接用联合主键完成,也可以代码里写逻辑。

- 查询订单

- 判断是否存在,不存在则扣减库存,创建订单。

查询订单和扣减库存这块会出现并发问题,因为查询和创建不是原子性的。在加锁的时候需要注意锁的范围和事务的范围。同时,需要注意用什么充当锁。此处可以采用用户的 id 充当锁,因为我们的目的是一人一单,避免有人用脚本刷单,对单个用户的一人一单操作加锁即可。(涉及到了 String 的 intern 方法)

单价情况下一人一单

事务是由 Spring 进行管理的。在释放锁后,才会开始提交事务。函数执行完后,Spring 提交事务,此时锁以及被释放了,其他线程已经可以进来,而且事务尚未提交,其他用户查到的是未更新的数据,存在很大的问题。应该是提交事务后,再释放锁。

@Transactional

public Result createVoucherOrder(Long voucherId){

Long userId = UserHolder.getUser().getId();

// toString 返回的是一个 new String(xxx)

synchronized(userId.toString().intern()){

// 业务代码

}

// 会出现,锁已经释放了,但是事务还没有提交。数据没有刷新到数据库中,导致其他事务查询到的还是未更新的数据,导致数据不一致。

// 为了避免这种问题,需要加大锁的范围

}

加大锁的范围,需要注意的是,Spring 的事务是通过代理对象实现的,直接调用 createVoucherOrder 是不会走代理对象的,所以我们需要改成用代理对象调用,这样就是走的代理方法了。

@Transactional

public Result createVoucherOrder(Long voucherId){

Long userId = UserHolder.getUser().getId();

// 业务代码,操作数据库。

}

// 加大锁的范围,让锁锁住事务 Spring 事务失效的几中情况

public boolean KK(){

// some code

Long userId = UserHolder.getUser().getId();

// Spring 的事务是通过代理对象实现的,

// 而 KK 方法上面没有加事务注解,因此 KK 方法不会走代理方法增强

// 在 KK 方法中直接调用 createVoucherOrder 是不会走代理对象的

// 所以我们需要改成用代理对象调用

synchronized(userId.toString().intern()){

IVoucherOrderService proxy = (IVoucherOrderService)AopContext.currentProxy();

return proxy.createVoucherOrder(userId); // createVoucherOrder 是接口 IVoucherOrderService 中的方法

}

}

// 在 SpringBoot 启动类上加上注解

@EnableAspectJAutoProxy(exposeProxy = true) // 暴露代理对象。

@MapperScan("xx.xxx.xxx")

@SpringBootApplication

public class XXApplication{

// some code

}

2023-1-9 温习 Spring 的时候温习到了事务相关的内容,对上述内容又做了一次实验,确实是会导致事务失效的。测试代码如下。

@Service

public class UserService {

@Autowired

UserDao userDao;

// 调用 testTX 方法,testAopContext 不会对事务进行回滚!

public void testTX() {

synchronized (this) {

testAopContext();

}

}

@Transactional

public void testAopContext() {

String update = "update tb_u set age = ? where id = ?";

userDao.update(update, 30, 1);

int i = 1 / 0;

userDao.update(update, 30, 2);

}

}

分布式下的一人一单

通过加锁可以解决在单机情况下的一人一单安全问题,但是在集群模式下就不行了。假定下面两个线程访问的是不同的服务器:

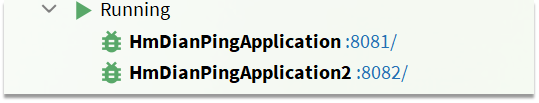

模拟集群模型:

1.将服务启动两份,端口分别为 8081 和 8082

2.修改 nginx 的 conf 目录下的 nginx.conf 文件,配置反向代理和负载均衡。

3.jmeter 并发访问,出现并发安全问题,并未实现一人一单。

分布式锁可以解决上述问题。当然也可以直接用数据库的联合主键解决一人一单的问题。对比下使用联合主键和分布式锁的性能差距。

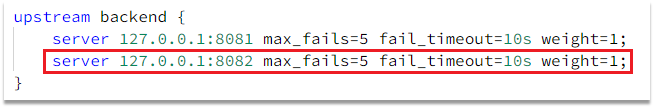

分布式锁

分布式锁是满足分布式系统或集群模式下多进程可见并且互斥的锁。

分布式锁的核心是实现多进程之间互斥,而满足这一点的方式有很多,常见的有三种

| – | MySQL | Redis | Zookeeper |

|---|---|---|---|

| 互斥 | 利用 mysql 本身的互斥锁机制 | 利用 setnx 这样的互斥命令 | 利用节点的唯一性和有序性实现互斥 |

| 高可用 | 好 | 好 | 好 |

| 高性能 | 一般 | 好 | 一般 |

| 安全性 | 断开连接,自动释放锁 | 利用锁超时时间,到期释放 | 临时节点,断开连接自动释放 |

基于Redis的分布式锁

在处理一人一单业务的时候,在分布式情况下需要使用分布式锁来确保一人一单。这里使用 Redis 定义一个分布式锁,再创建订单时先看能不能拿到锁,能拿到锁就创建订单,不能就返回错误。在代码中,我们为了实现分布式锁时定义了两个基本方法:

| 方法 | 说明 |

|---|---|

| 获取锁方法 | ①互斥,确保只能有一个线程获取锁 ② setnx lock thread1,并通过 expire lock 10 添加锁过期时间,避免服务器宕机引起死锁③非阻塞:尝试一次,成功返回 true,失败返回 false |

| 释放锁方法 | ①手动释放 ②超时释放:获取锁时添加一个超时时间 del key |

public interface ILock{

// 尝试获取锁,timeoutsec 表示锁的持有时间,过期后自动释放。

boolean tryLock(long timeoutsec){};

void unlock();

}

public class SimpleRedisLock implements ILock{

private String name;

private StringRedisTemplate stringRedisTemplate;

private static final String KEY_PREFIX = "lock:";

public SimpleRedisLock(String name, StringRedisTemplate stringRedisTemplate){

this.name = name;

this.stringRedisTemplate = stringRedisTemplate;

}

@Override

public boolean tryLock(long timeout){

long threadId = Thread.currentThread().getId();

Boolean success = stringRedisTemplate.opsForValue().setIfAbsent(KEY_PREFIX+name, threadId+"", timeout, TimeUnit.SECONDS);

return Boolean.TRUE.equals(success);

}

@Override

public void unlock(){

stringRedisTemplate.opsForValue().delete(KEY_PREFIX+name);

}

}

// 使用锁的代码示例:

new SimpleRedisLock("order:"+userId, stringRedisTemplate);

上述的方案存在一个问题,如果两个线程争抢锁,线程 1 抢到了,但是由于执行业务的时间太长了,致使锁超时释放。此时线程 2 拿到了锁执行业务。在线程 2 执行业务的时候,线程 1 业务执行完毕了,释放了锁(释放了其他线程加的锁),线程 3 在线程 2 为完成业务,且锁未超时的情况下拿到了锁。

问题辨析:锁超时了,其他线程拿到了锁合理吗?如果是缓存重建这种情况,锁超时了还未成功重建缓存,其他线程在超时的情况下拿到锁是没什么大问题的。

为了解决这个问题,我们需要在释放锁之前判断一下,是不是自己加的锁,是自己加的锁才要释放。

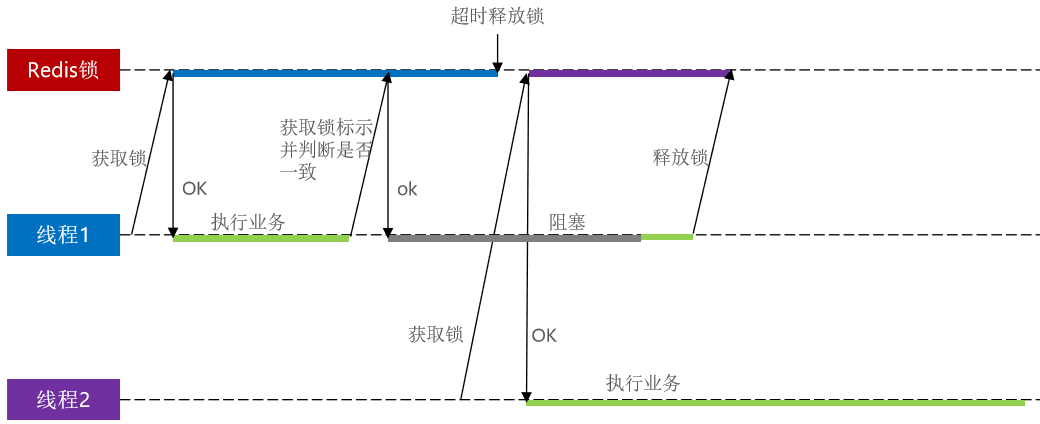

改进Redis的分布式锁

需求:修改之前的分布式锁实现,满足:

- 在获取锁时存入线程标识(可以用 UUID + Thread ID 表示),之前直接采用 JVM Thread 的 id,这种 id 是不唯一的。

- 在释放锁时先获取锁中的线程标示,判断是否与当前线程标识一致

- 如果一致则释放锁

- 如果不一致则不释放锁

// 修改分布式锁释放锁的代码

public void unlock(){

String threadId = ID_PREFIX + Thread.currentThread().getId();

// 获取、判断、删除不是原子性的,会存在并发问题。

String id = stringRedisTemplate.opsForValue().get(KEY_PREFIX + name);

if(threadId.eqquals(id)){

// 一致则释放锁

stringRedisTemplate.opsForValue().delete(KEY_PREFIX+name);

}

// 不一致则不释放

}

但是这种方案仍然存在问题

判断锁标识和释放锁不是原子性的,会有并发问题。线程 1 判断锁标识,发现一致,在释放锁时发送了阻塞(如 GC)。在阻塞过程中,其他服务器的线程 2 获取到了锁,并开始执行业务。在线程 2 执行业务时,线程 1 把线程 2 的锁释放了。如果有其他线程也来抢锁,是可以拿到锁的。

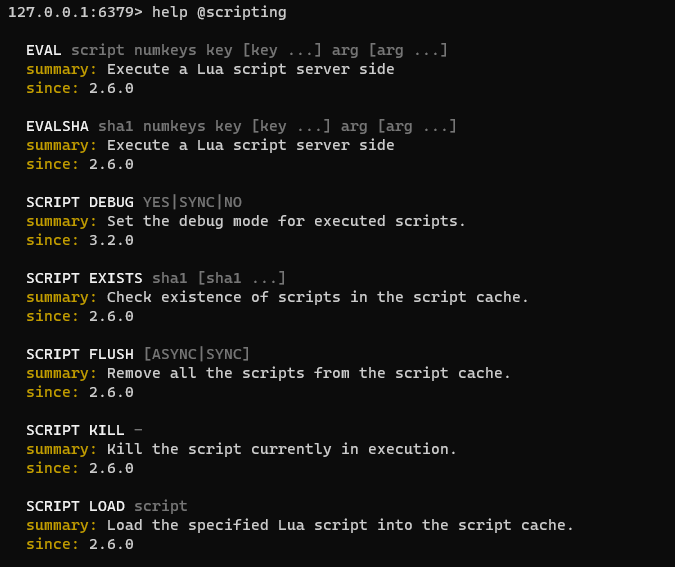

Lua 脚本

前面的核心问题在与,判断锁和释放锁不是原子性的操作,而 Lua 脚本可以解决这种问题。

基本语法

Redis 提供了 Lua 脚本功能,在一个脚本中编写多条 Redis 命令,确保多条命令执行时的原子性。Lua 是一种编程语言,它的基本语法可以参考网站:https://www.runoob.com/lua/lua-tutorial.html 这里重点介绍 Redis 提供的调用函数,语法如下:

# 执行redis命令

redis.call('命令名称', 'key', '其它参数', ...)

例如,我们要执行 set name jack,则脚本是这样

# 执行 set name jack

redis.call('set', 'name', 'jack')

例如,我们要先执行 set name Rose,再执行 get name,则脚本如下

# 先执行 set name jack

redis.call('set', 'name', 'jack')

# 再执行 get name

local name = redis.call('get', 'name')

# 返回

return name

写好脚本以后,需要用 Redis 命令来调用脚本,调用脚本的常见命令如下

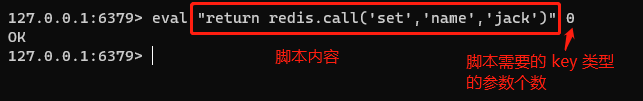

例如,我们要执行 redis.call(‘set’, ‘name’, ‘jack’) 这个脚本,语法如下

如果脚本中的 key、value 不想写死,可以作为参数传递。key 类型参数会放入 KEYS 数组,其它参数会放入 ARGV 数组,在脚本中可以从 KEYS 和 ARGV 数组获取这些参数。

# keys 数组只有 1 个元素 name,arg 数组有一个元素 rose

eval "return redis.call('set', KEYS[1],ARGV[1])" 1 name rose

# keys 数组无元素(0),arg 数组有一个元素 arg

eval "return argv[1]" 0 arg1

Lua 改进分布式锁

释放锁的业务流程如下

- 1.获取锁中的线程标识

- 2.判断是否与指定的标识(当前线程标识)一致

- 3.如果一致则释放锁(删除)

- 4.如果不一致则什么都不做

- 5.如果用 Lua 脚本来表示则是这样的:

-- 这里的 KEYS[1] 就是锁的key,这里的ARGV[1] 就是当前线程标示

-- 获取锁中的标示,判断是否与当前线程标示一致

if (redis.call('GET', KEYS[1]) == ARGV[1]) then

-- 一致,则删除锁

return redis.call('DEL', KEYS[1])

end

-- 不一致,则直接返回

return 0

需求:基于 Lua 脚本实现分布式锁的释放锁逻辑

提示:RedisTemplate 调用 Lua 脚本的 API 如下

/**

script:脚本

keys:对应 KEYG

args:对应 ARGV

*/

public <T> execute(RedisScript<T> script, List<K> kyes, Object... args){

return scriptExecutor.execute(script, keys, args);

}

假定,我们将 lua 脚本放在 resources 根目录下

private static final DefaultRedisScript<Long> UNLOCK_SCRIPT;

static{

UNLOCK_SCRIPT = new DefaultRedisScript<>();

UNLOCK_SCRIPT.setLocation(new ClassPathResource("unlock.lua"));

UNLOCK_SCRIPT.setResultType(Long.class);

}

public static unlock(){

stringRedisTemplate.execute(

UNLOCK_SCRIPT,

Collections.singletionList(KEY_PREFIX+name),

ID_PREFIX+Thread.currentThread().getId()

);

}

基于 Redis 的分布式锁实现思路:

- 利用 set nx ex 获取锁,并设置过期时间,保存线程标识

- 释放锁时先判断线程标识是否与自己一致,一致则删除锁

特性:

- 利用 set nx 满足互斥性

- 利用 set ex 保证故障时锁依然能释放,避免死锁,提高安全性

- 利用 Redis 集群保证高可用和高并发特性

基于 setnx 实现的分布式锁存在下面的问题:

- 不可重入:同一个线程无法多次获取同一把锁

- 不可重试:获取锁只尝试一次就返回 false,没有重试机制

- 超时释放:锁超时释放虽然可以避免死锁,但如果是业务执行耗时较长,也会导致锁释放,存在安全隐患

- 主从一致性:如果 Redis 提供了主从集群,主从同步存在延迟,当主宕机时,如果从没有同步主中的锁数据,则会出现锁失效。

Redisson

介绍&配置

Redisson 是一个在 Redis 的基础上实现的 Java 驻内存数据网格(In-Memory Data Grid)。它不仅提供了一系列的分布式的 Java 常用对象,还提供了许多分布式服务,其中就包含了各种分布式锁的实现。

官网地址: https://redisson.org GitHub 地址: https://github.com/redisson/redisson

为了避免 Redission 里的配置把 SpringBoot 里的覆盖了,这里就采用引入 redisson,自己配置 Redission 的方式。

引入依赖

<dependency>

<groupId>org.redisson</groupId>

<artifactId>redisson</artifactId>

<version>3.13.6</version>

</dependency>

配置客户端

@Configuration

public class RedisConfig{

@Bean

public RedissonClient redissonClient(){

Config config = new Config();

// 添加redis地址,这里添加了单点的地址,也可以使用config.useClusterServers()添加集群地址

config.useSingleServer()

.setAddress("redis://192.168.1.101:6379")

.setPassword("123");

return Redission.create(config);

}

}

使用 Redisson 分布式锁

@Resource

private RedissonClient redissonClient;

@Test

void testRedisson() throws InterruptedException {

// 获取锁(可重入),指定锁的名称

RLock lock = redissonClient.getLock("anyLock");

// 尝试获取锁,参数分别是:获取锁的最大等待时间(期间会重试),锁自动释放时间,时间单位

boolean isLock = lock.tryLock(1, 10, TimeUnit.SECONDS);

// 判断释放获取成功

if(isLock){

try {

System.out.println("执行业务");

}finally {

// 释放锁

lock.unlock();

}

}

}

原理

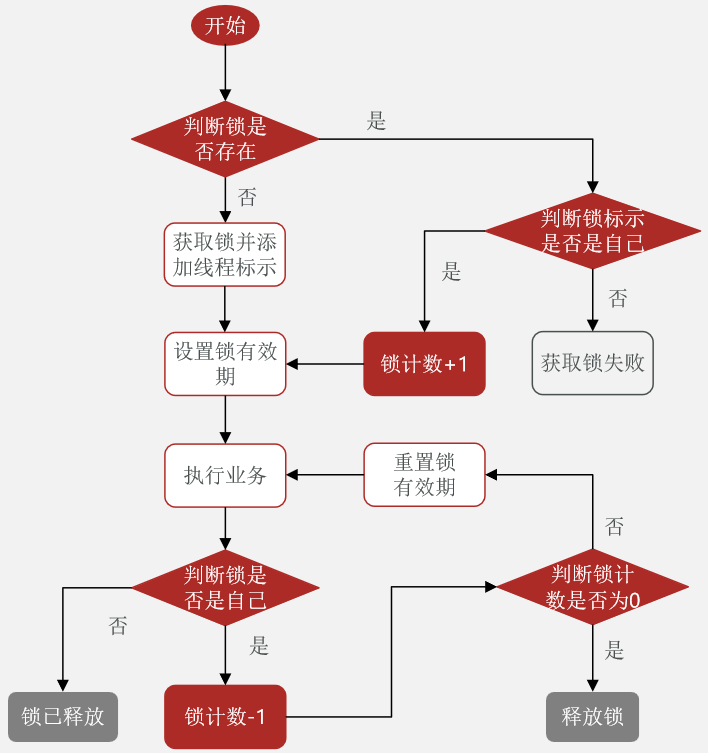

可重入锁原理

与 Java 其他的可重入锁的原理很类似。内部的数据类型如下。

| key | value | |

|---|---|---|

| field | value | |

| lock | thread1 | 1 |

有人加锁时判断是是持有锁的线程,是则锁的重入次数(value 值)+1,不是则加锁失败。释放锁也是类似的,value – 后为 0 就释放锁。

释放锁的 lua 脚本

local key = KEYS[1];

-- 锁的key

local threadId = ARGV[1];

-- 线程唯一标识

local releaseTime = ARGV[2];

-- 锁的自动释放时间

-- 判断当前锁是否还是被自己持有

if (redis.call('HEXISTS', key, threadId) == 0) then

return nil;

-- 如果已经不是自己,则直接返回

end;

-- 是自己的锁,则重入次数-1

local count = redis.call('HINCRBY', key, threadId, -1);

-- 判断是否重入次数是否已经为0

if (count > 0) then

-- 大于0说明不能释放锁,重置有效期然后返回

redis.call('EXPIRE', key, releaseTime);

return nil;

else -- 等于0说明可以释放锁,直接删除

redis.call('DEL', key);

return nil;

end;

源码位于 RedissonLock。如果有人释放锁了会发布一个消息,而那些等待锁的会订阅这个消息。如果在指定时间还没获取到锁就取消订阅。如果在指定时间内发现有人释放了锁,则尝试获取锁。这样不断的尝试。巧妙的运用了发布订阅模式,避免无休止的盲等。

Redisson 分布式锁原理

- 可重入:利用 hash 结构记录线程 id 和重入次数

- 可重试:利用信号量和 PubSub 功能实现等待、唤醒,获取锁失败的重试机制

- 超时续约:利用 watchDog,每隔一段时间(releaseTime / 3),重置超时时间

主从一致问题

Redisson 分布式锁主从一致问题。如果是单节点的 Redis 发送了故障,会导致所有依赖于 Redis 的业务都出现问题。一般都会搭建主从节点。主节点负责写操作,从节点负责读操作。锁数据同步需要时间。假定在主节点要同步锁数据的时候,主节点宕机了,所有的从节点都没有同步到锁数据,访问新的主节点时

graph LR

subgraph 设置锁,主从节点正常

Java应用-->|获取锁,set lock thread1 nx ex 10|Redis Master-->|主从同步|Redis Slave1

Redis Master-->|主从同步|Redis Slave2

end

graph LR

subgraph 设置锁,主节点宕机

Java应用-->|获取锁,set lock thread1 nx ex 10|Redis Master宕机

Java应用-->|获取锁,set lock thread1 nx ex 10|Redis Slave2升级为主节点

Redis Slave2升级为主节点-->|主从同步|Redis Slave1

end

这样,A 线程设置好了锁,其他线程尝试获取锁时,因为原先的主节点宕机了,而且锁没有同步过去,其他线程向新的主节点设置锁时可以设置成功。这样就不是一个线程持有锁了,而是两个了。Redission 的 multiLock 可以避免这种问题,只要 Redis 集群设置成这种模式,每个节点都可以读写。

graph LR

subgraph 设置锁,主从节点正常

Java应用-->|获取锁,set lock thread1 nx ex 10|Redis Node1,lock=thread1

Java应用-->|获取锁,set lock thread1 nx ex 10|Redis Node2,lock=thread1

Java应用-->|获取锁,set lock thread1 nx ex 10|Redis Node3,lock=thread1

end

如果觉得这样的可用性不高,那么可以为这些节点再设置从节点。

| 类型 | 原理 | 缺陷 |

|---|---|---|

| 不可重入 Redis 分布式锁 | 利用 setnx 的互斥性;利用 ex 避免死锁;释放锁时判断线程标示 | 不可重入、无法重试、锁超时失效 |

| 可重入的 Redis 分布式锁 | 利用 hash 结构,记录线程标示和重入次数;利用 watchDog 延续锁时间;利用信号量控制锁重试等待 | redis 宕机引起锁失效问题 |

| Redisson 的 multiLock | 多个独立的 Redis 节点,必须在所有节点都获取重入锁,才算获取锁成功 | 运维成本高、实现复杂 |

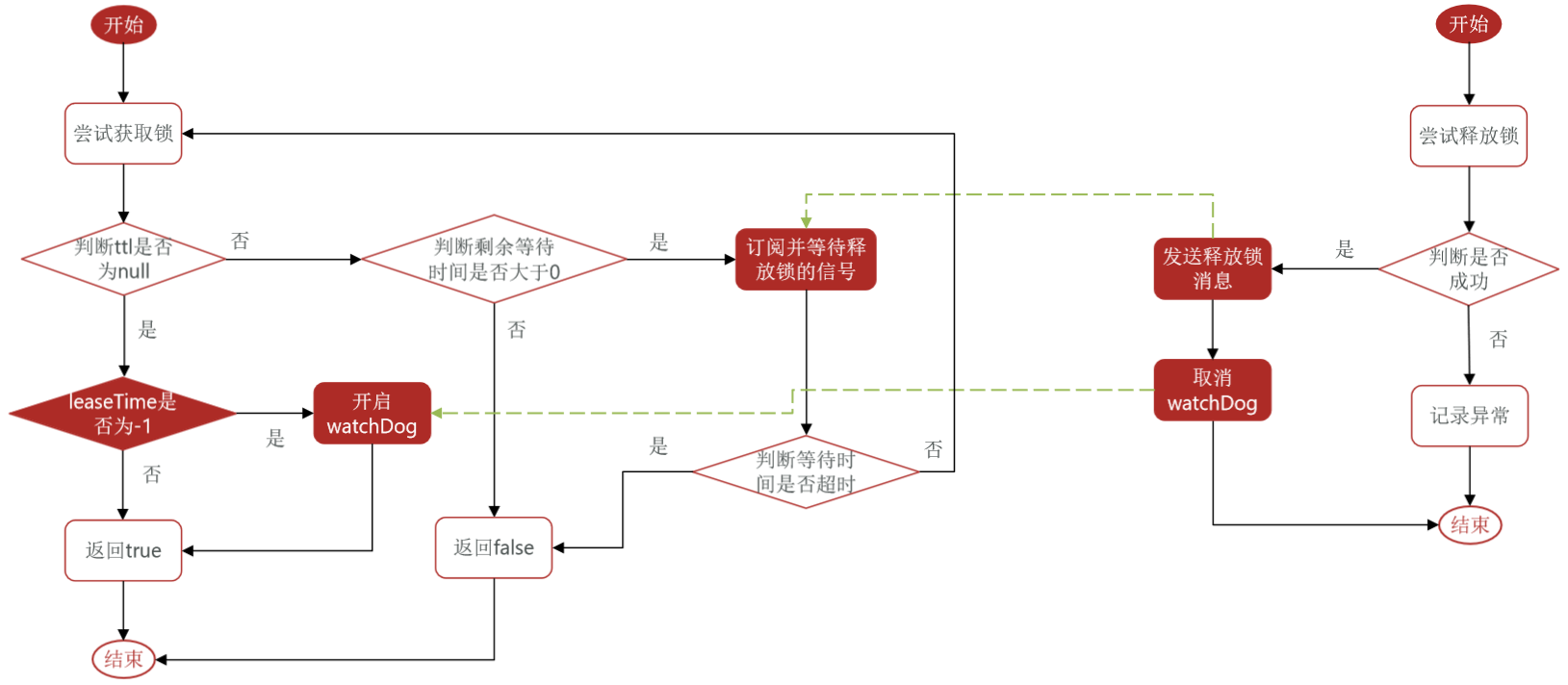

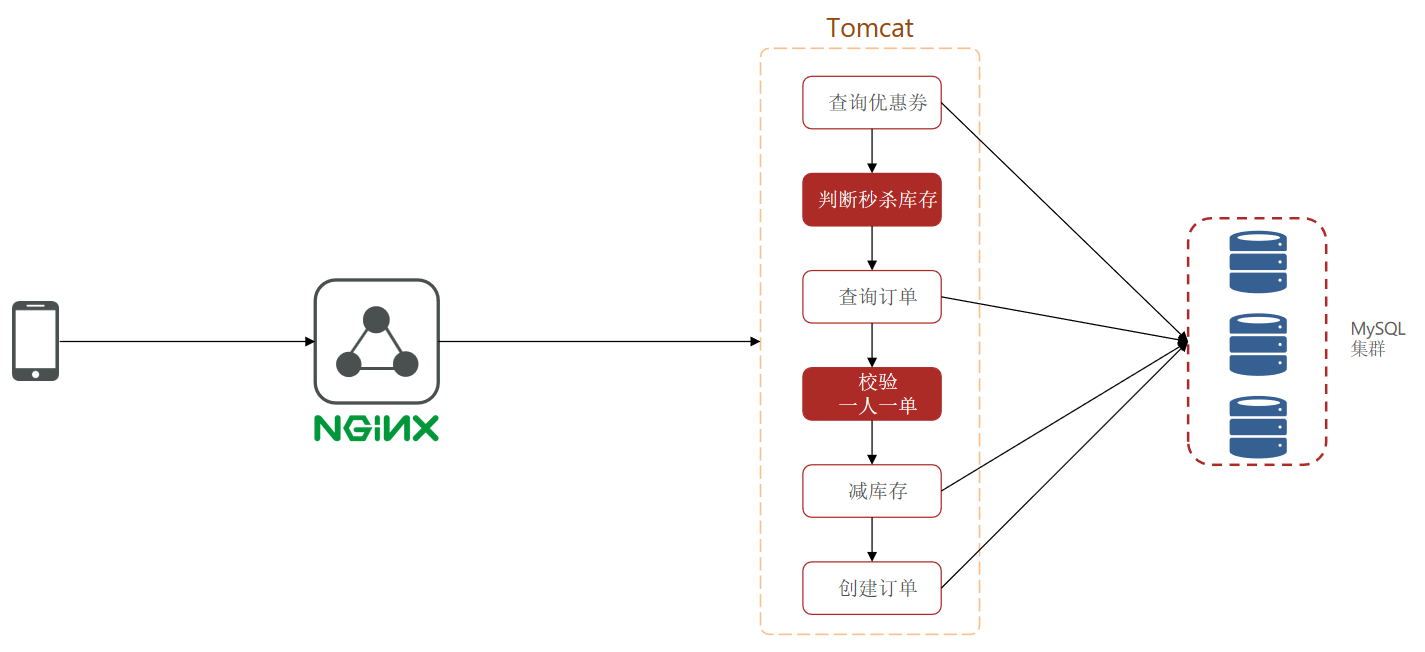

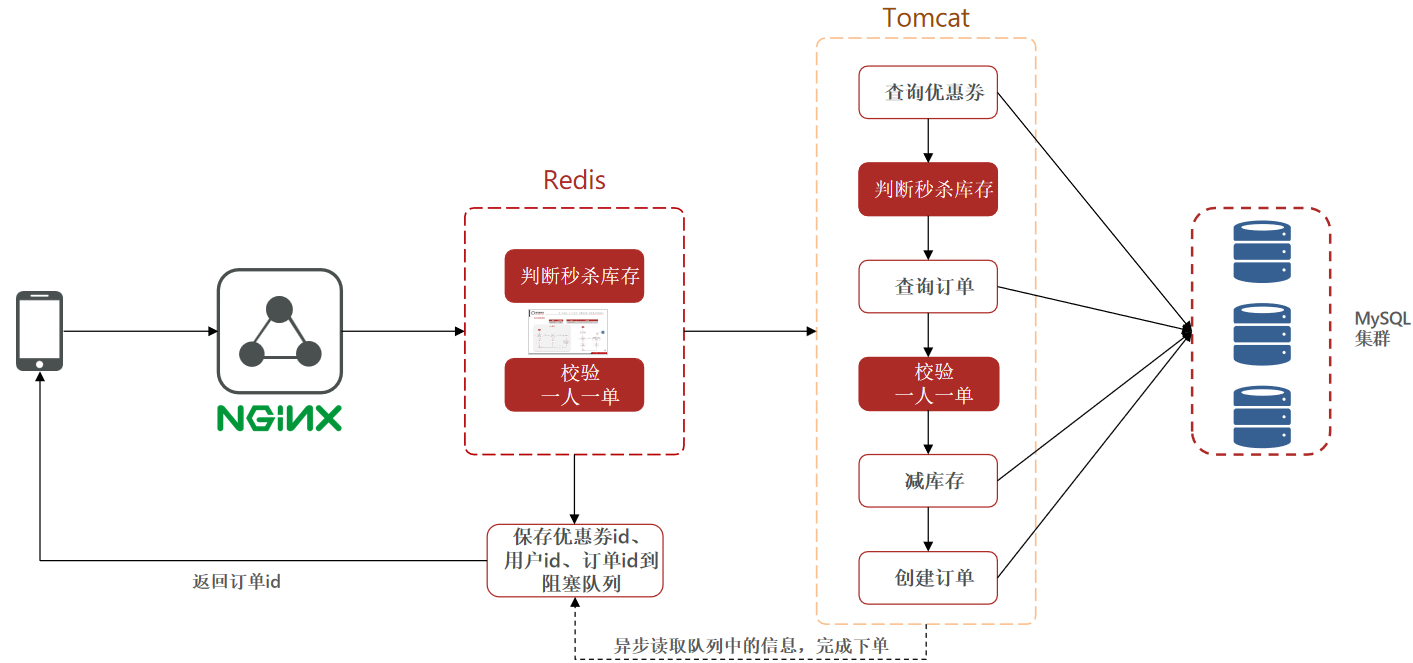

Redis优化秒杀

Redis 中预先缓存库存,下单前先查库存,库存够才允许下单。下单前再在 Redis 中做订单校验判断是否下单过。(有个业务问题,校验成功后 Redis 直接预减库存,生成订单信息加入 MQ。MQ 的消费端再慢慢从 MQ 中取出数据进行消费,修改数据库中的存货。如果用户取消订单,则 Redis 中库存 +1)

原始架构

Redis优化后

key 的设计 stock:vid:7,用 String 即可。一人一单则采用 zset 中存储用户 id,确保唯一,key 的设计为 order:vid:7。

改进秒杀业务,提高并发性能

- 新增秒杀优惠券的同时,将优惠券信息保存到 Redis 中

- 基于 Lua 脚本,判断秒杀库存、一人一单,决定用户是否抢购成功

- 如果抢购成功,将优惠券 id 和用户 id 封装后存入阻塞队列(暂时不写)

- 开启线程任务,不断从阻塞队列中获取信息,实现异步下单功能(暂时不写)

秒杀优化思路

- 先利用 Redis 完成库存余量、一人一单判断,完成抢单业务

- 再将下单业务放入阻塞队列,利用独立线程异步下单

- 基于阻塞队列的异步秒杀存在哪些问题?

- 内存限制问题

- 数据安全问题

消息队列实现异步秒杀

消息队列(Message Queue),字面意思就是存放消息的队列。最简单的消息队列模型包括 3 个角色。

- 消息队列:存储和管理消息,也被称为消息代理(Message Broker)

- 生产者:发送消息到消息队列

- 消费者:从消息队列获取消息并处理消息

flowchart LR

生产者-->1(Message Queue)-->消费者

使用消息队列完成异步秒杀

生产者:判断秒杀时间和库存;校验一人一单;都通过后发送优惠券 id 和用户 id 到消息队列。

消费者:接受消息后完成下单。

Redis 提供了三种不同的方式来实现消息队列

- List 结构:基于 List 结构模拟消息队列

- PubSub:基本的点对点消息模型

- Stream:比较完善的消息队列模型

基于List的消息队列

消息队列(Message Queue),字面意思就是存放消息的队列。而 Redis 的 list 数据结构是一个双向链表,很容易模拟出队列效果。队列是入口和出口不在一边,因此我们可以利用:LPUSH 结合 RPOP、或者 RPUSH 结合 LPOP 来实现。不过要注意的是,当队列中没有消息时 RPOP 或 LPOP 操作会返回null,并不像 JVM 的阻塞队列那样会阻塞并等待消息。因此这里应该使用 BRPOP 或者 BLPOP 来实现阻塞效果。

基于 List 的消息队列有哪些优缺点?

优点:利用 Redis 存储,不受限于 JVM 内存上限;基于 Redis 的持久化机制,数据安全性有保证;可以满足消息有序性。

缺点:无法避免消息丢失;只支持单消费者。

基于PubSub的消息队列

PubSub(发布订阅)是 Redis2.0 版本引入的消息传递模型。顾名思义,消费者可以订阅一个或多个 channel,生产者向对应 channel 发送消息后,所有订阅者都能收到相关消息。

- SUBSCRIBE channel [channel]:订阅一个或多个频道

- PUBLISH channel msg:向一个频道发送消息

- PSUBSCRIBE pattern[pattern]:订阅与 pattern 格式匹配的所有频道

flowchart LR

生产者-->|publish order.queue msg1|1(Message Queue)-->|subscribe order.queue|消费者1

1(Message Queue)-->|subscribe order.queue|消费者2

基于 PubSub 的消息队列

优点:采用发布订阅模型,支持多生产、多消费

缺点:不支持数据持久化;无法避免消息丢失;消息堆积有上限,超出时数据丢失

基于Stream的消息队列

Stream 是 Redis 5.0 引入的一种新数据类型,可以实现一个功能非常完善的消息队列。

发送消息的命令

127.0.0.1:6379> help xadd

XADD key [NOMKSTREAM] [MAXLEN|MINID [=|~] threshold [LIMIT count]] *|ID field value [field value ...]

summary: Appends a new entry to a stream

since: 5.0.0

group: stream

# 创建名为 users 的队列,并向其中发送一个消息,内容是 {name=jack, age=21}, 并且使用 Redis 自动生成 id

127.0.0.1:6379> xadd users * name jack age 21

"1674809034254-0"

读取消息的方式之一:XREAD

127.0.0.1:6379> help xread

XREAD [COUNT count] [BLOCK milliseconds] STREAMS key [key ...] ID [ID ...]

summary: Return never seen elements in multiple streams, with IDs greater than the ones reported by the caller for each stream. Can block.

since: 5.0.0

group: stream

例如,使用 XREAD 读取第一个消息

127.0.0.1:6379> xread count 1 streams users 0

1) 1) "users"

2) 1) 1) "1674809034254-0"

2) 1) "name"

2) "jack"

3) "age"

4) "21"

XREAD 阻塞方式,读取最新的消息 ($ 表示读取最新的消息)

127.0.0.1:6379> xread count 1 block 1000 streams users $

(nil)

(1.02s)

在业务开发中,我们可以循环的调用 XREAD 阻塞方式来查询最新消息,从而实现持续监听队列的效果,伪代码如下。

while(true){

//尝试读取队列中的消息,最多阻塞2秒

Object msg = redis.execute("XREAD COUNT 1 BLOCK 2000 STREAMS users $");

if(msg == null){

continue;

}

//处理消息

handleMessage(msg);

}

当我们指定起始 ID 为 $ 时,代表读取最新的消息,如果我们处理一条消息的过程中,又有超过 1 条以上的消息到达队列,则下次获取时也只能获取到最新的一条,会出现漏读消息的问题。

Stream 消息队列的 XREAD 命令特点

- 消息可回溯

- 一个消息可以被多个消费者读取

- 可以阻塞读取

- 有消息漏读的风险

基于Stream的消息队列-消费者组

消费者组(Consumer Group),将多个消费者划分到一个组中,监听同一个队列。具备下列特点:

- 消息分流:队列中的消息会分流给组内的不同消费者,而不是重复消费,从而加快消息处理的速度

- 消息标示:消费者组会维护一个标示,记录最后一个被处理的消息,哪怕消费者宕机重启,还会从标示之后读取消息。确保每一个消息都会被消费

- 消息确认:消费者获取消息后,消息处于 pending 状态,并存入一个 pending-list。当处理完成后需要通过 XACK 来确认消息,标记消息为已处理,才会从 pending-list 移除。

创建消费者组

XGROUP CREATE key groupName ID [MKSTREAM]

- key:队列名称

- groupName:消费者组名称

- ID:起始 ID 标示,$ 代表队列中最后一个消息,0 则代表队列中第一个消息

- MKSTREAM:队列不存在时自动创建队列

其他常见命令

# 删除指定的消费者组

XGROUP DESTORY key groupName

# 给指定的消费者组添加消费者

XGROUP CREATECONSUMER key groupname consumername

# 删除消费者组中的指定消费者

XGROUP DELCONSUMER key groupname consumername

从消费者组读消息

XREADGROUP GROUP group consumer [COUNT count] [BLOCK milliseconds] [NOACK] STREAMS key [key ...] ID [ID ...]

- group:消费组名称

- consumer:消费者名称,如果消费者不存在,会自动创建一个消费者

- count:本次查询的最大数量

- BLOCK milliseconds:当没有消息时最长等待时间

- NOACK:无需手动 ACK,获取到消息后自动确认

- STREAMS key:指定队列名称

- ID:获取消息的起始 ID:

- ”>”:从下一个未消费的消息开始

- 其它:根据指定 id 从 pending-list 中获取已消费但未确认的消息,例如 0,是从 pending-list 中的第一个消息开始

消费者监听消息的基本思路

while(true){

//尝试监听队列, 使用阻塞模式,最长等待 2000 毫秒

Object msg = redis.call("XREADGROUP GROUP g1 c1 COUNT 1 BLOCK 2000 STREAMS s1 >");

if(msg == null){ // null 说明没有消息,继续下一次

continue;

}

try {

//外理消息,完成后一定要 ACK

handleMessage(msg);

} catch(Exception e){

while(true){

Object msg = redis.call("XREADGROUP GROUP g1 c1 COUNT 1 STREAMS s1 0");

if(msg == null){ // null 说明没有异常消息,所有消息确认,结束循环

break;

}

try {

//说明有异常消息,再次处理

handleMessage(msg);

} catch(Fxception H){

// 再次出现异常,记录日志,继续循环

continue;

}

}

}

}

Stream 消息队列 XREADGROUP 命令特点

- 消息可回溯

- 可以多消费者争抢消息,加快消费速度

- 可以阻塞读取

- 没有消息漏读的风险

- 有消息确认机制,保证消息至少被消费一次

Redis 消息队列总结

| - | List | PubSub | Stream |

|---|---|---|---|

| 消息持久化 | 支持 | 不支持 | 支持 |

| 阻塞读取 | 支持 | 支持 | 支持 |

| 消息堆积处理 | 受限于内存空间,可以利用多消费者加快处理 | 受限于消费者缓冲区 | 受限于队列长度,可以利用消费者组提高消费速度,减少堆积 |

| 消息确认机制 | 不支持 | 不支持 | 支持 |

| 消息回溯 | 不支持 | 不支持 | 支持 |

案例练习

基于 Redis 的 Stream 结构作为消息队列,实现异步秒杀下单

- 创建一个 Stream 类型的消息队列,名为 stream.orders

- 修改之前的秒杀下单 Lua 脚本,在认定有抢购资格后,直接向 stream.orders 中添加消息,内容包含 voucherId、userId、orderId

- 项目启动时,开启一个线程任务,尝试获取 stream.orders 中的消息,完成下单

达人探店

这部分主要练习业务。

- 发布笔记

- 点赞

- 点赞排行

发布笔记

探店笔记类似点评网站的评价,往往是图文结合。对应的表有两个。

- tb_blog:探店笔记表,包含笔记中的标题、文字、图片等

- tb_blog_comments:其他用户对探店笔记的评价

DROP TABLE IF EXISTS `tb_blog`;

CREATE TABLE `tb_blog` (

`id` bigint(20) UNSIGNED NOT NULL AUTO_INCREMENT COMMENT '主键',

`shop_id` bigint(20) NOT NULL COMMENT '商户id',

`user_id` bigint(20) UNSIGNED NOT NULL COMMENT '用户id',

`title` varchar(255) CHARACTER SET utf8mb4 COLLATE utf8mb4_unicode_ci NOT NULL COMMENT '标题',

`images` varchar(2048) CHARACTER SET utf8mb4 COLLATE utf8mb4_general_ci NOT NULL COMMENT '探店的照片,最多9张,多张以\",\"隔开',

`content` varchar(2048) CHARACTER SET utf8mb4 COLLATE utf8mb4_unicode_ci NOT NULL COMMENT '探店的文字描述',

`liked` int(8) UNSIGNED NULL DEFAULT 0 COMMENT '点赞数量',

`comments` int(8) UNSIGNED NULL DEFAULT NULL COMMENT '评论数量',

`create_time` timestamp NOT NULL DEFAULT CURRENT_TIMESTAMP COMMENT '创建时间',

`update_time` timestamp NOT NULL DEFAULT CURRENT_TIMESTAMP ON UPDATE CURRENT_TIMESTAMP COMMENT '更新时间',

PRIMARY KEY (`id`) USING BTREE

) ENGINE = InnoDB AUTO_INCREMENT = 23 CHARACTER SET = utf8mb4 COLLATE = utf8mb4_general_ci ROW_FORMAT = Compact;

需要注意部分是文件上传的设置。文件上传的路径要设置好,此处需要设置为 Nginx 目录

public class SystemConstants{

// 设置为 nginx 的目录

public static final String IMAGE_UPLOAD_DIR = "D:\\xx\\nginx-1.18.0\\html\\xx\imgs\\";

public static final String USER_NICK_NAME_PREFIX = "user_";

public static final int DEFAULT_PAGE_SIZE = 5;

public static final int MAX_PAGE_SIZE = 10;

}

点赞

需求如下:

- 同一个用户只能点赞一次,再次点击则取消点赞

- 如果当前用户已经点赞,则点赞按钮高亮显示(前端已实现,判断字段 Blog 类的 isLike 属性)

实现步骤:

- 给 Blog 类中添加一个 isLike 字段,标示是否被当前用户点赞。

- 如何用 Redis 实现该功能呢?

- 可以用 Blog 的 id 作为 key,然后 value 中记录那些用户点赞过。

- 用什么数据类型呢?用 set 集合,可以确保数据的值唯一,一个用户只能点赞一次。

- 修改点赞功能,利用 Redis 的 set 集合判断是否点赞过,未点赞过则点赞数 +1,已点赞过则点赞数 -1

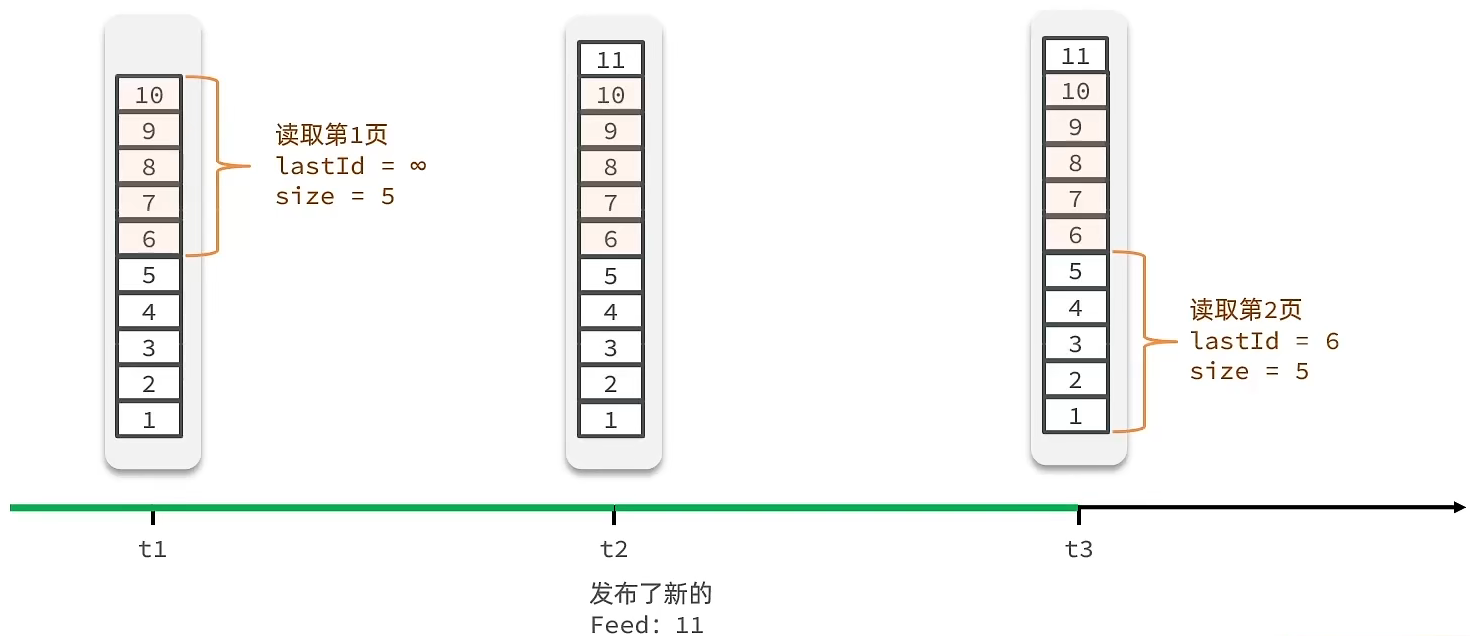

- 修改根据 id 查询 Blog 的业务,判断当前登录用户是否点赞过,赋值给 isLike 字段